GSP1158

Panoramica

Dataplex Universal Catalog è un data fabric intelligente che consente alle organizzazioni di centralizzare l'individuazione, la gestione, il monitoraggio e la governance dei dati in data lake, data warehouse e data mart per potenziare l'analisi su larga scala.

Una funzionalità importante di Dataplex Universal Catalog è la capacità di definire ed eseguire controlli sulla qualità dei dati per i suoi asset, come le tabelle di BigQuery e i file di Cloud Storage. Utilizzando le attività di qualità dei dati di Dataplex, puoi integrare i controlli di qualità dei dati nei workflow quotidiani convalidando i dati che fanno parte di una pipeline di produzione di dati, monitorando regolarmente la qualità dei dati rispetto a un set di criteri e creando report sulla qualità dei dati per i requisiti normativi.

In questo lab imparerai a valutare la qualità dei dati con Dataplex Universal Catalog. Per farlo, creerai un file di specifiche personalizzato per la qualità dei dati e lo userai per definire ed eseguire un job di controllo qualità sui dati BigQuery.

In questo lab proverai a:

- Creare un lake, una zona e un asset in Dataplex Universal Catalog

- Eseguire query su una tabella BigQuery per controllare la qualità dei dati

- Creare e caricare un file di specifiche della qualità dei dati

- Definire ed eseguire un job di qualità dei dati

- Esaminare i risultati di un job di qualità dei dati

Configurazione e requisiti

Prima di fare clic sul pulsante Avvia lab

Leggi le seguenti istruzioni. I lab sono a tempo e non possono essere messi in pausa. Il timer si avvia quando fai clic su Inizia il lab e ti mostra per quanto tempo avrai a disposizione le risorse Google Cloud.

Con questo lab pratico avrai la possibilità di completare le attività in un ambiente cloud reale e non di simulazione o demo. Riceverai delle nuove credenziali temporanee che potrai utilizzare per accedere a Google Cloud per la durata del lab.

Per completare il lab, avrai bisogno di:

- Accesso a un browser internet standard (Chrome è il browser consigliato).

Nota: per eseguire questo lab, utilizza una finestra del browser in modalità di navigazione in incognito (consigliata) o privata. Ciò evita conflitti tra il tuo account personale e l'account studente, che potrebbero causare addebiti aggiuntivi sul tuo account personale.

- È ora di completare il lab: ricorda che, una volta iniziato, non puoi metterlo in pausa.

Nota: utilizza solo l'account studente per questo lab. Se utilizzi un altro account Google Cloud, potrebbero essere addebitati costi su quell'account.

Come avviare il lab e accedere alla console Google Cloud

-

Fai clic sul pulsante Avvia lab. Se devi effettuare il pagamento per il lab, si aprirà una finestra di dialogo per permetterti di selezionare il metodo di pagamento.

A sinistra, trovi il riquadro Dettagli lab con le seguenti informazioni:

- Il pulsante Apri la console Google Cloud

- Tempo rimanente

- Credenziali temporanee da utilizzare per il lab

- Altre informazioni per seguire questo lab, se necessario

-

Fai clic su Apri console Google Cloud (o fai clic con il tasto destro del mouse e seleziona Apri link in finestra di navigazione in incognito se utilizzi il browser Chrome).

Il lab avvia le risorse e apre un'altra scheda con la pagina di accesso.

Suggerimento: disponi le schede in finestre separate posizionate fianco a fianco.

Nota: se visualizzi la finestra di dialogo Scegli un account, fai clic su Usa un altro account.

-

Se necessario, copia il Nome utente di seguito e incollalo nella finestra di dialogo di accesso.

{{{user_0.username | "Username"}}}

Puoi trovare il Nome utente anche nel riquadro Dettagli lab.

-

Fai clic su Avanti.

-

Copia la Password di seguito e incollala nella finestra di dialogo di benvenuto.

{{{user_0.password | "Password"}}}

Puoi trovare la Password anche nel riquadro Dettagli lab.

-

Fai clic su Avanti.

Importante: devi utilizzare le credenziali fornite dal lab. Non utilizzare le credenziali del tuo account Google Cloud.

Nota: utilizzare il tuo account Google Cloud per questo lab potrebbe comportare addebiti aggiuntivi.

-

Fai clic nelle pagine successive:

- Accetta i termini e le condizioni.

- Non inserire opzioni di recupero o l'autenticazione a due fattori, perché si tratta di un account temporaneo.

- Non registrarti per le prove gratuite.

Dopo qualche istante, la console Google Cloud si apre in questa scheda.

Nota: per accedere ai prodotti e ai servizi Google Cloud, fai clic sul menu di navigazione o digita il nome del servizio o del prodotto nel campo Cerca.

Attiva Cloud Shell

Cloud Shell è una macchina virtuale in cui sono caricati strumenti per sviluppatori. Offre una home directory permanente da 5 GB e viene eseguita su Google Cloud. Cloud Shell fornisce l'accesso da riga di comando alle risorse Google Cloud.

-

Fai clic su Attiva Cloud Shell  nella parte superiore della console Google Cloud.

nella parte superiore della console Google Cloud.

-

Fai clic nelle seguenti finestre:

- Continua nella finestra delle informazioni di Cloud Shell.

- Autorizza Cloud Shell a utilizzare le tue credenziali per effettuare chiamate API Google Cloud.

Quando la connessione è attiva, l'autenticazione è già avvenuta e il progetto è impostato sul tuo Project_ID, . L'output contiene una riga che dichiara il Project_ID per questa sessione:

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

gcloud è lo strumento a riga di comando di Google Cloud. È preinstallato su Cloud Shell e supporta il completamento tramite tasto Tab.

- (Facoltativo) Puoi visualizzare il nome dell'account attivo con questo comando:

gcloud auth list

- Fai clic su Autorizza.

Output:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (Facoltativo) Puoi elencare l'ID progetto con questo comando:

gcloud config list project

Output:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Nota: per la documentazione completa di gcloud, in Google Cloud, fai riferimento alla guida Panoramica dell'interfaccia a riga di comando gcloud.

Abilita l'API Dataproc

-

Nella barra del titolo della console Google Cloud, inserisci API Cloud Dataproc nel campo Cerca, quindi fai clic su API Cloud Dataproc nei risultati di ricerca.

-

Se non è già abilitato, fai clic su Abilita.

Attività 1: crea un lake, una zona e un asset in Dataplex

Per definire ed eseguire attività di qualità dei dati, sono necessarie alcune risorse Dataplex Universal Catalog.

In questa attività creerai un nuovo lake Dataplex Universal Catalog per archiviare le informazioni sui clienti di e-commerce, aggiungerai una zona grezza al lake e poi collegherai un set di dati BigQuery creato in precedenza come nuovo asset nella zona.

Crea un lake

- Nella console Google Cloud, nel menu di navigazione (

) > Visualizza tutti i prodotti, vai ad Analisi > Dataplex Universal Catalog.

) > Visualizza tutti i prodotti, vai ad Analisi > Dataplex Universal Catalog.

Se appare il messaggio Ti diamo il benvenuto nel nuovo Dataplex Universal Catalog, fai clic su Chiudi.

-

In Gestisci lake, fai clic su Gestisci.

-

Fai clic su Crea lake.

-

Inserisci le informazioni richieste per creare un nuovo lake. Lascia tutti gli altri campi con i valori predefiniti:

| Proprietà |

Valore |

| Nome visualizzato |

Ecommerce Lake |

| Regione |

|

- Fai clic su Crea.

La creazione del lake può richiedere fino a 3 minuti.

Aggiungi una zona al lake

-

Nella scheda Gestisci, fai clic sul nome del tuo lake.

-

Fai clic su AGGIUNGI ZONA.

-

Inserisci le informazioni richieste per creare una nuova zona. Lascia tutti gli altri campi con i valori predefiniti:

| Proprietà |

Valore |

| Nome visualizzato |

Customer Contact Raw Zone |

| Tipo |

Zona grezza |

| Località dei dati |

Regional |

- Fai clic su Crea.

La creazione della zona può richiedere fino a 2 minuti.

Nota: puoi eseguire l'attività successiva una volta che lo stato della zona è Attivo.

Collega un asset a una zona

-

Nella scheda Zone, fai clic su Customer Contact Raw Zone.

-

Nella scheda Asset, fai clic su Aggiunti asset.

-

Fai clic su Aggiungi un asset.

-

Inserisci le informazioni richieste per collegare un nuovo asset. Lascia invariati i valori predefiniti degli altri campi.

| Proprietà |

Valore |

| Tipo |

Set di dati BigQuery |

| Nome visualizzato |

Contact Info |

| Set di dati |

.customers |

-

Fai clic su Fine.

-

Fai clic su Continua.

-

Per Impostazioni di rilevamento, seleziona Eredita per ereditare le impostazioni di rilevamento dal livello di zona, quindi fai clic su Continua.

-

Fai clic su Invia.

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Crea un lake, una zona e un asset in Dataplex Universal Catalog

Attività 2: esegui query su una tabella BigQuery per controllare la qualità dei dati

Questo lab utilizza due set di dati BigQuery predefiniti:

-

customers, contenente una tabella denominata contact_info, che include i dati di contatto per i clienti come ID cliente, nome, email e altro. Questa è la tabella che esplorerai e controllerai per trovare eventuali problemi di qualità dei dati durante questo lab.

-

customers_dq_dataset, che non contiene tabelle. Quando definirai un job di qualità dei dati in un'attività successiva, utilizzerai questo set di dati come destinazione per una nuova tabella contenente i risultati del job di qualità dei dati.

In questa attività, eseguirai una query sul set di dati customers per identificare i problemi di qualità dei dati da includere come controlli in un job di qualità dei dati. Inoltre, apecificherai il set di dati customers_dq_dataset per archiviare i risultati del job di qualità dei dati in un'attività successiva.

Apri la console BigQuery

- Nella console Google Cloud, seleziona il menu di navigazione > BigQuery:

Si aprirà la finestra con il messaggio Ti diamo il benvenuto in BigQuery su Cloud Console. Questa finestra fornisce un link alla guida rapida e alle note di rilascio.

- Fai clic su Fine.

Si aprirà la console di BigQuery.

Esegui una query sulla tabella contact_info

- Nel riquadro Spazio di esplorazione, fai clic sulla freccia di espansione accanto all'ID progetto () per elencarne i contenuti.

Dovresti vedere i tre set di dati:

- Customer Contact Raw Zone

- customers

- customers_dq_dataset

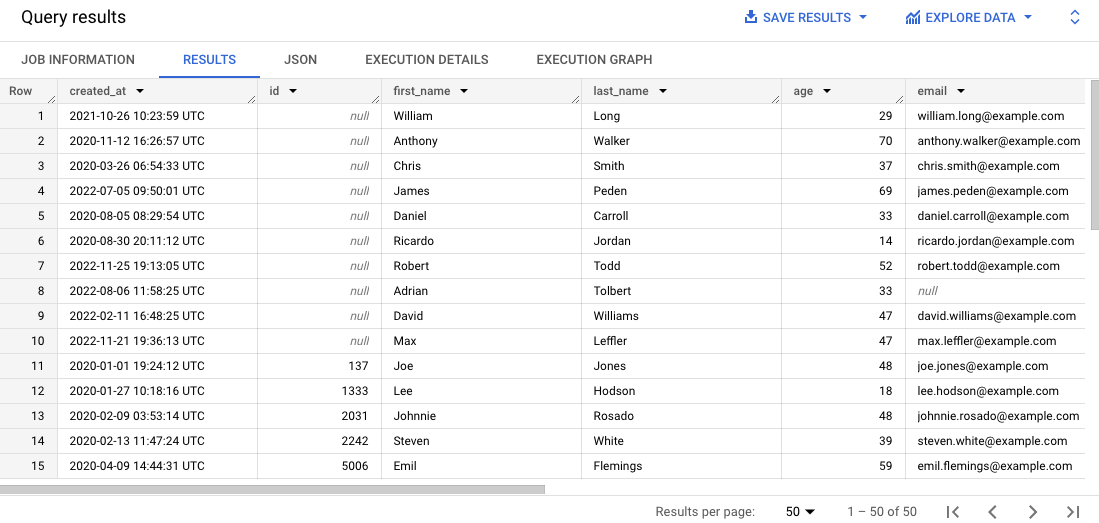

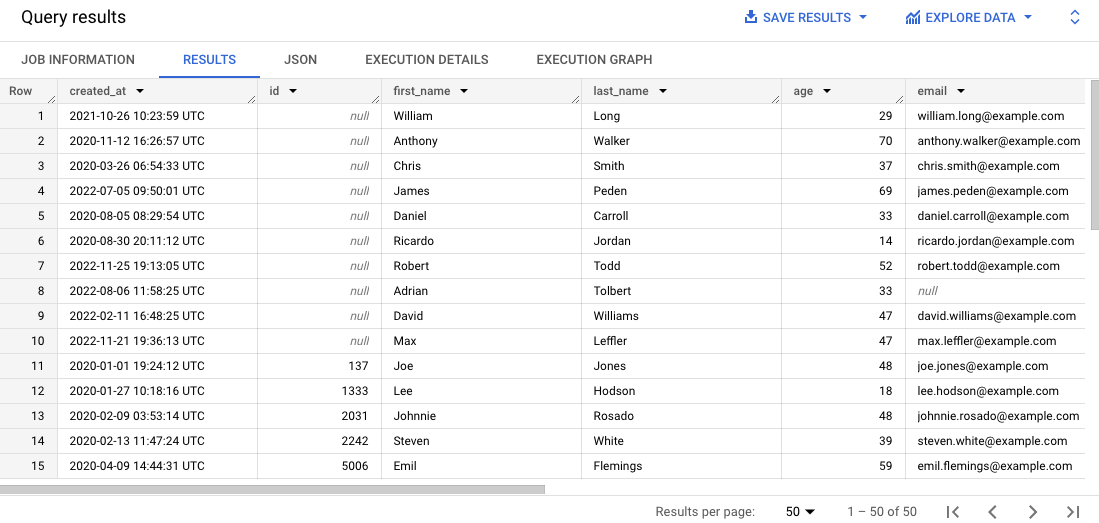

- Nell'Editor SQL, fai clic su Query SQL (+). Incolla la seguente query e fai clic su Esegui:

SELECT * FROM `{{{project_0.project_id}}}.customers.contact_info`

ORDER BY id

LIMIT 50

Questa query seleziona 50 record dalla tabella originale e ordina i record in base all'ID cliente nei risultati.

-

Scorri i risultati nel riquadro Risultati.

Nota che alcuni record sono privi degli ID cliente o hanno indirizzi email errati, cosa che può complicare la gestione degli ordini dei clienti.

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Esegui query su una tabella BigQuery per controllare la qualità dei dati

Attività 3: crea e carica un file di specifiche della qualità dei dati

I requisiti di controllo della qualità dei dati Dataplex vengono definiti utilizzando i file delle specifiche YAML di CloudDQ. Una volta creato, il file delle specifiche YAML viene caricato in un bucket Cloud Storage reso accessibile al job di qualità dei dati.

Il file YAML ha quattro sezioni chiave:

- un elenco di regole da eseguire (regole predefinite o personalizzate)

- filtri di riga per selezionare un sottoinsieme di dati per la convalida

- associazioni di regole per applicare le regole definite alle tabelle

- dimensioni delle regole facoltative per specificare i tipi di regole che il file YAML può contenere

In questa attività definirai un nuovo file di specifiche YAML per i controlli della qualità dei dati che identificano ID cliente ed email null nella tabella BigQuery specificata. Specificherai anche un set di dati BigQuery creato in precedenza denominato customer_dq_dataset per archiviare i risultati sulla qualità dei dati in una tabella denominata dq_results.

Dopo aver definito il file, caricalo in un bucket Cloud Storage creato in precedenza per utilizzarlo in un'attività successiva ed eseguire il job di qualità dei dati.

Crea il file delle specifiche della qualità dei dati

- In Cloud Shell, esegui il comando seguente per creare un nuovo file vuoto per la specifica della qualità dei dati:

nano dq-customer-raw-data.yaml

- Incolla il seguente codice nel file:

rules:

- nonNullExpectation: {}

column: id

dimension: COMPLETENESS

threshold: 1

- regexExpectation:

regex: '^[^@]+[@]{1}[^@]+$'

column: email

dimension: CONFORMANCE

ignoreNull: true

threshold: .85

postScanActions:

bigqueryExport:

resultsTable: projects/{{{project_0.project_id | Project ID}}}/datasets/customers_dq_dataset/tables/dq_results

- Esamina il codice per identificare le due regole principali sulla qualità dei dati definite in questo file.

Il file dq-customer-raw-data.yaml specifica due regole:

- la prima regola si riferisce alla dimensione di completezza come i valori null

- la seconda regola si riferisce alla dimensione di conformità come i valori non validi

In questo file, le due regole sono associate a colonne specifiche della tabella:

- La prima associazione di regole associa una regola notNullExpectation alla colonna id della tabella contact_info con una soglia del 100%, verificando se la colonna ID contiene valori NULL.

- La seconda associazione di regole associa una regola regexExpectation alla colonna email della tabella contact_info con una soglia dell'85%, verificando la validità degli indirizzi email.

- Inserisci

Ctrl+X, quindi Y, per salvare e chiudere il file.

Carica il file su Cloud Storage

- In Cloud Shell, esegui comando seguente per caricare il file in un bucket Cloud Storage:

gsutil cp dq-customer-raw-data.yaml gs://{{{project_0.project_id | Project ID}}}-bucket

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Crea e carica un file di specifiche della qualità dei dati

Attività 4: definisci ed esegui un job di qualità dei dati automatico in Dataplex

Il job di qualità dei dati utilizza un file YAML delle specifiche della qualità dei dati per eseguire un job di qualità dei dati e genera metriche sulla qualità dei dati che vengono scritte in un set di dati BigQuery.

In questa attività definirai ed eseguirai un job di qualità dei dati automatico utilizzando il file YAML delle specifiche della qualità dei dati in Cloud Storage. Quando definirai il job, specificherai anche il set di dati customer_dq_dataset per archiviare i risultati sulla qualità dei dati.

- In Cloud Shell, esegui questo comando per creare una scansione della qualità dei dati:

gcloud dataplex datascans create data-quality customer-orders-data-quality-job \

--project={{{project_0.project_id | Project ID}}} \

--location={{{project_0.default_region | Region}}} \

--data-source-resource="//bigquery.googleapis.com/projects/{{{project_0.project_id | Project ID}}}/datasets/customers/tables/contact_info" \

--data-quality-spec-file="gs://{{{project_0.project_id | Project ID}}}-bucket/dq-customer-raw-data.yaml"

Note: In this lab, the Compute Engine default service account has been preconfigured to have the appropriate IAM roles and permissions. Per saperne di più, consulta la documentazione di Dataplex Universal Catalog Crea un service account.

-

Torna alla console. Dovresti trovarti ancora in Dataplex Universal Catalog.

-

In Governa, fai clic su Profilazione e qualità dei dati.

-

Fai clic su customer-orders-data-quality-job.

-

Fai clic su Esegui ora.

Nota: l'esecuzione del job può richiedere diversi minuti.

Una volta completato il job, noterai che il suo stato è 1 dimensione 1 regola non riuscita.

- Fai clic su Visualizza risultati.

Nota che la regola di qualità dei dati per la colonna email è Passed, mentre per la colonna id è Failed. Questo è il comportamento previsto perché:

-

La regola per la colonna id è un null check con una soglia del 100%. Ciò significa che, per far sì che la regola venga applicata, tutte le righe devono avere un valore nella colonna "id". In questo caso, il 10% delle righe della colonna id della tabella contact_info ha valori null. Di conseguenza, questa regola risulterà Failed.

-

La regola per la colonna email è un Regex Check con una soglia dell'85%. Ciò significa che la regola non verrà applicata se il 15% dei record ha un formato email non valido. In questo caso, circa il 10,5% delle righe della colonna email della tabella contact_info contiene email non valide. Di conseguenza, questa regola risulterà Passed.

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Definisci ed esegui un job di qualità dei dati in Dataplex Universal Catalog

Attività 5: esamina i risultati sulla qualità dei dati in BigQuery

In questa attività, esaminerai le tabelle in customers_dq_dataset per identificare i record privi dei valori ID cliente o contenenti valori non validi per gli indirizzi email.

-

Torna a BigQuery e nel riquadro Explorer espandi la freccia accanto all'ID progetto per elencarne i contenuti:

-

Fai clic sulla freccia di espansione accanto al set di dati customer_dq_dataset.

-

Fai clic sulla tabella dq_results.

-

Fai clic sulla scheda Anteprima per vedere i risultati.

-

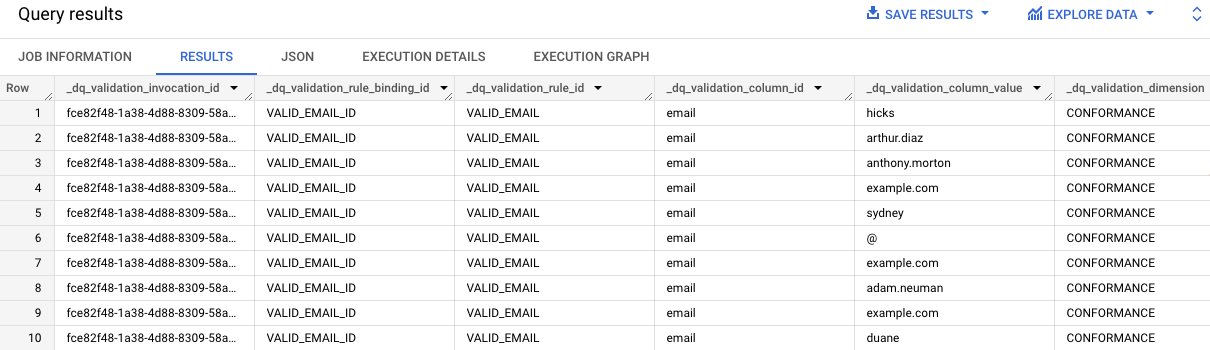

Scorri fino alla colonna denominata rule_failed_records_query.

-

Copia la query, inizia con WITH.

-

Fai clic su Query SQL (+). Copia e incolla la query nell'Editor SQL e fai clic su Esegui.

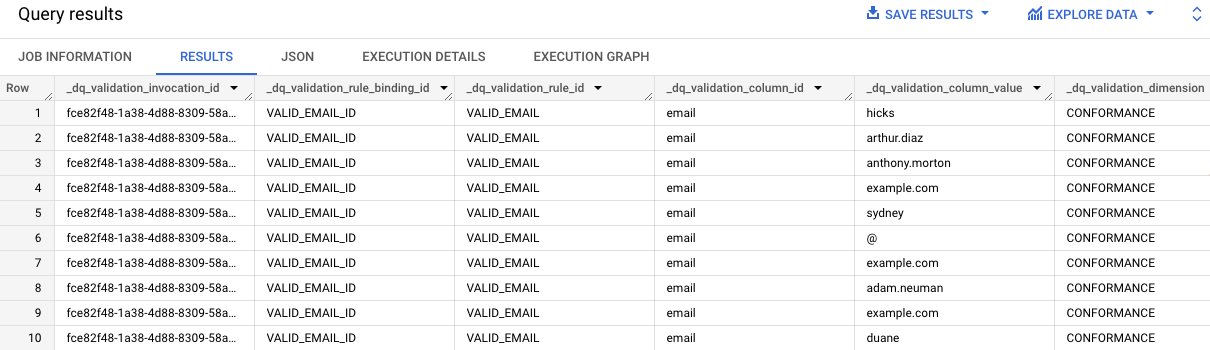

I risultati della query forniscono i valori email della tabella contact_info che non sono validi. Noterai la presenza di "email" in ogni voce della colonna dq_validation_column_id.

-

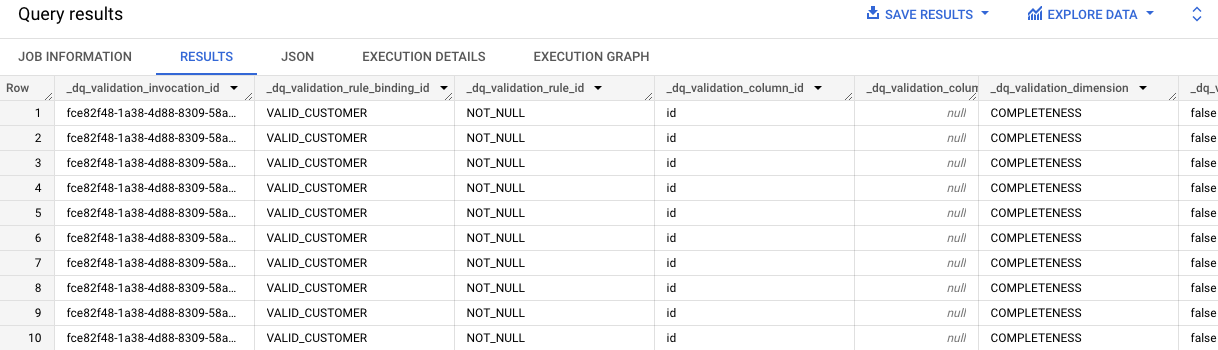

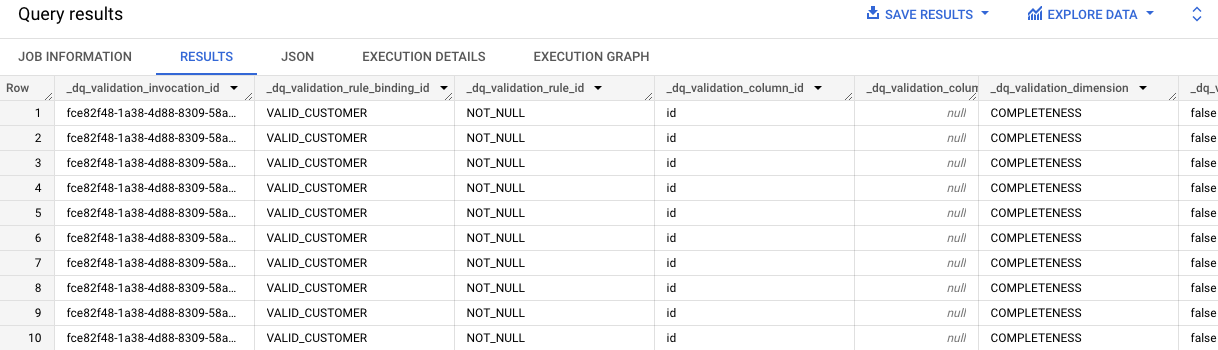

Ripeti i passaggi 7-8 per la seconda cella che contiene la query per i risultati della regola VALID_CUSTOMER.

Dai risultati della query emerge che nella tabella contact_info sono presenti 10 record privi dei valori ID.

Noterai la presenza di "id" in ogni voce della colonna dq_validation_column_id.

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Esamina i risultati sulla qualità dei dati nella tabella BigQuery

Complimenti!

Hai valutato la qualità dei dati con Dataplex Universal Catalog. Per farlo, hai creato un file di specifiche personalizzato della qualità dei dati e lo hai usato per eseguire un job di qualità dei dati su una tabella BigQuery.

Formazione e certificazione Google Cloud

… per utilizzare al meglio le tecnologie Google Cloud. I nostri corsi ti consentono di sviluppare competenze tecniche e best practice per aiutarti a metterti subito al passo e avanzare nel tuo percorso di apprendimento. Offriamo vari livelli di formazione, dal livello base a quello avanzato, con opzioni di corsi on demand, dal vivo e virtuali, in modo da poter scegliere il più adatto in base ai tuoi impegni. Le certificazioni ti permettono di confermare e dimostrare le tue abilità e competenze relative alle tecnologie Google Cloud.

Ultimo aggiornamento del manuale: 2 settembre 2025

Ultimo test del lab: 2 settembre 2025

Copyright 2025 Google LLC. Tutti i diritti riservati. Google e il logo Google sono marchi di Google LLC. Tutti gli altri nomi di società e prodotti sono marchi delle rispettive società a cui sono associati.

nella parte superiore della console Google Cloud.

nella parte superiore della console Google Cloud. ) > Visualizza tutti i prodotti, vai ad Analisi > Dataplex Universal Catalog.

) > Visualizza tutti i prodotti, vai ad Analisi > Dataplex Universal Catalog.