GSP1158

Descripción general

Dataplex Universal Catalog es un tejido de datos inteligente que permite a las organizaciones descubrir, administrar, supervisar y controlar de forma centralizada sus datos en todos los data lakes, almacenes de datos y data marts para potenciar la analítica a gran escala.

Una función valiosa de Dataplex Universal Catalog es la capacidad para definir y ejecutar verificaciones de calidad de los datos de sus recursos, como las tablas de BigQuery y los archivos de Cloud Storage. Con las tareas de calidad de los datos de Dataplex, puedes integrar estas verificaciones en los flujos de trabajo diarios a través de la validación de los datos que forman parte de una canalización de producción de datos, la supervisión habitual de la calidad de los datos en relación con un conjunto de criterios y la elaboración de informes de calidad de los datos para cumplir con requisitos reglamentarios.

En este lab, aprenderás a evaluar la calidad de los datos con Dataplex Universal Catalog. Para ello, crearás un archivo personalizado de especificación de calidad de los datos y lo usarás para definir y ejecutar un trabajo relacionado en datos de BigQuery.

Actividades

- Crear un lake, una zona y un recurso de Dataplex Universal Catalog

- Consultar una tabla de BigQuery para revisar la calidad de los datos

- Crear y subir un archivo de especificación de calidad de los datos

- Definir y ejecutar un trabajo de calidad de los datos

- Revisar los resultados de un trabajo de calidad de los datos

Configuración y requisitos

Antes de hacer clic en el botón Comenzar lab

Lee estas instrucciones. Los labs cuentan con un temporizador que no se puede pausar. El temporizador, que comienza a funcionar cuando haces clic en Comenzar lab, indica por cuánto tiempo tendrás a tu disposición los recursos de Google Cloud.

Este lab práctico te permitirá realizar las actividades correspondientes en un entorno de nube real, no en uno de simulación o demostración. Para ello, se te proporcionan credenciales temporales nuevas que utilizarás para acceder a Google Cloud durante todo el lab.

Para completar este lab, necesitarás lo siguiente:

- Acceso a un navegador de Internet estándar. Se recomienda el navegador Chrome.

Nota: Usa una ventana del navegador privada o de incógnito (opción recomendada) para ejecutar el lab. Así evitarás conflictos entre tu cuenta personal y la cuenta de estudiante, lo que podría generar cargos adicionales en tu cuenta personal.

- Tiempo para completar el lab (recuerda que, una vez que comienzas un lab, no puedes pausarlo).

Nota: Usa solo la cuenta de estudiante para este lab. Si usas otra cuenta de Google Cloud, es posible que se apliquen cargos a esa cuenta.

Cómo iniciar tu lab y acceder a la consola de Google Cloud

-

Haz clic en el botón Comenzar lab. Si debes pagar por el lab, se abrirá un diálogo para que selecciones la forma de pago.

A la izquierda, se encuentra el panel Detalles del lab, que tiene estos elementos:

- El botón para abrir la consola de Google Cloud

- El tiempo restante

- Las credenciales temporales que debes usar para el lab

- Otra información para completar el lab, si es necesaria

-

Haz clic en Abrir la consola de Google Cloud (o haz clic con el botón derecho y selecciona Abrir el vínculo en una ventana de incógnito si ejecutas el navegador Chrome).

El lab inicia recursos y abre otra pestaña en la que se muestra la página de acceso.

Sugerencia: Ordena las pestañas en ventanas separadas, una junto a la otra.

Nota: Si ves el diálogo Elegir una cuenta, haz clic en Usar otra cuenta.

-

De ser necesario, copia el nombre de usuario a continuación y pégalo en el diálogo Acceder.

{{{user_0.username | "Username"}}}

También puedes encontrar el nombre de usuario en el panel Detalles del lab.

-

Haz clic en Siguiente.

-

Copia la contraseña que aparece a continuación y pégala en el diálogo Te damos la bienvenida.

{{{user_0.password | "Password"}}}

También puedes encontrar la contraseña en el panel Detalles del lab.

-

Haz clic en Siguiente.

Importante: Debes usar las credenciales que te proporciona el lab. No uses las credenciales de tu cuenta de Google Cloud.

Nota: Usar tu propia cuenta de Google Cloud para este lab podría generar cargos adicionales.

-

Haz clic para avanzar por las páginas siguientes:

- Acepta los Términos y Condiciones.

- No agregues opciones de recuperación o autenticación de dos factores (esta es una cuenta temporal).

- No te registres para obtener pruebas gratuitas.

Después de un momento, se abrirá la consola de Google Cloud en esta pestaña.

Nota: Para acceder a los productos y servicios de Google Cloud, haz clic en el menú de navegación o escribe el nombre del servicio o producto en el campo Buscar.

Activa Cloud Shell

Cloud Shell es una máquina virtual que cuenta con herramientas para desarrolladores. Ofrece un directorio principal persistente de 5 GB y se ejecuta en Google Cloud. Cloud Shell proporciona acceso de línea de comandos a tus recursos de Google Cloud.

-

Haz clic en Activar Cloud Shell  en la parte superior de la consola de Google Cloud.

en la parte superior de la consola de Google Cloud.

-

Haz clic para avanzar por las siguientes ventanas:

- Continúa en la ventana de información de Cloud Shell.

- Autoriza a Cloud Shell para que use tus credenciales para realizar llamadas a la API de Google Cloud.

Cuando te conectes, habrás completado la autenticación, y el proyecto estará configurado con tu Project_ID, . El resultado contiene una línea que declara el Project_ID para esta sesión:

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

gcloud es la herramienta de línea de comandos de Google Cloud. Viene preinstalada en Cloud Shell y es compatible con la función de autocompletado con tabulador.

- Puedes solicitar el nombre de la cuenta activa con este comando (opcional):

gcloud auth list

- Haz clic en Autorizar.

Resultado:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- Puedes solicitar el ID del proyecto con este comando (opcional):

gcloud config list project

Resultado:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Nota: Para obtener toda la documentación de gcloud, en Google Cloud, consulta la guía con la descripción general de gcloud CLI.

Habilita la API de Dataproc

-

En la barra de título de la consola de Google Cloud, escribe API de Cloud Dataproc en el campo Buscar y, luego, haz clic en API de Cloud Dataproc en los resultados.

-

Si aún no está habilitada, haz clic en Habilitar.

Tarea 1. Crear un lake, una zona y un recurso en Dataplex

Para definir y ejecutar tareas de calidad de los datos, necesitas algunos recursos de Dataplex Universal Catalog.

En esta tarea, crearás un nuevo lake de Dataplex Universal Catalog para almacenar información de clientes de comercio electrónico, agregarás una zona de datos sin procesar al lake y, luego, conectarás un conjunto de datos de BigQuery creado previamente como un recurso nuevo en la zona.

Crea un lake

- En la consola de Google Cloud, en el menú de navegación (

)> Ver todos los productos, navega a Analytics > Dataplex Universal Catalog.

)> Ver todos los productos, navega a Analytics > Dataplex Universal Catalog.

Si aparece el mensaje Te damos la bienvenida a la nueva experiencia de Dataplex Universal Catalog, haz clic en Cerrar.

-

En Administrar lakes, haz clic en Administrar.

-

Haz clic en Crear lake.

-

Ingresa la información que se detalla abajo para crear un nuevo lake. Deja el resto de los campos con sus valores predeterminados.

| Propiedad |

Valor |

| Nombre visible |

Ecommerce Lake |

| Región |

|

- Haz clic en Crear.

El lake puede tardar hasta 3 minutos en crearse.

Agrega una zona al lake

-

En la pestaña Administrar, haz clic en el nombre de tu lake.

-

Haz clic en AGREGAR ZONA.

-

Ingresa la información que se detalla abajo para crear una nueva zona. Deja el resto de los campos con sus valores predeterminados.

| Propiedad |

Valor |

| Nombre visible |

Customer Contact Raw Zone |

| Tipo |

Zona de datos sin procesar |

| Ubicaciones de los datos |

Regional |

- Haz clic en Crear.

La zona puede tardar hasta 2 minutos en crearse.

Nota: Puedes realizar la tarea siguiente una vez que el estado de la zona sea Activa.

Conecta un recurso a una zona

-

En la pestaña Zonas, haz clic en Customer Contact Raw Zone.

-

En la pestaña Recursos, haz clic en Agregar recurso.

-

Haz clic en Agregar recurso.

-

Ingresa la información que se detalla abajo para conectar un recurso nuevo. Deja los otros campos con sus valores predeterminados.

| Propiedad |

Valor |

| Tipo |

Conjunto de datos de BigQuery |

| Nombre visible |

Contact Info |

| Conjunto de datos |

.customers |

-

Haz clic en Listo.

-

Haz clic en Continuar.

-

En la configuración de descubrimiento, selecciona Heredar para heredar la configuración de descubrimiento del nivel de la zona y, luego, haz clic en Continuar.

-

Haz clic en Enviar.

Haz clic en Revisar mi progreso para verificar el objetivo.

Crear un lake, una zona y un recurso en Dataplex Universal Catalog

Tarea 2. Consultar una tabla de BigQuery para revisar la calidad de los datos

En este lab, se usan dos conjuntos de datos de BigQuery creados previamente:

-

customers: Contiene una tabla llamada contact_info, que incluye información de contacto de clientes, como ID de cliente, nombre, correo electrónico, entre otros. Esta es la tabla que explorarás y en la que verificarás si existen problemas de calidad de los datos durante este lab.

-

customers_dq_dataset: No contiene ninguna tabla. Cuando definas un trabajo de calidad de los datos en una tarea posterior, usarás este conjunto de datos como el destino de una tabla nueva que contenga resultados del trabajo de calidad de los datos.

En esta tarea, consultarás el conjunto de datos customers para identificar problemas de calidad de los datos que se incluirán como verificaciones en un trabajo de calidad de los datos. También especificarás el conjunto de datos customers_dq_dataset para que almacene los resultados del trabajo de calidad de los datos en una tarea posterior.

Cómo abrir la consola de BigQuery

- En la consola de Google Cloud, selecciona el menú de navegación > BigQuery.

Se abrirá el cuadro de mensaje Te damos la bienvenida a BigQuery en la consola de Cloud. Este cuadro de mensaje contiene un vínculo a la guía de inicio rápido y las notas de la versión.

- Haz clic en Listo.

Se abrirá la consola de BigQuery.

Consulta la tabla contact_info

- En el panel Explorador, haz clic en la flecha de expandir junto al ID de tu proyecto () para ver una lista de los contenidos.

Deberías ver los tres conjuntos de datos:

- customer_contact_raw_zone

- customers

- customers_dq_dataset

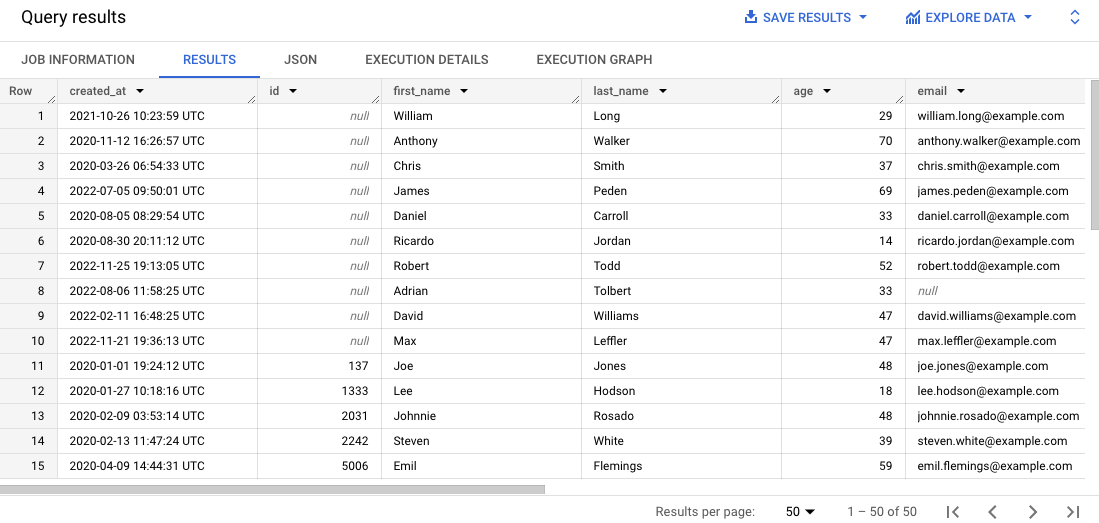

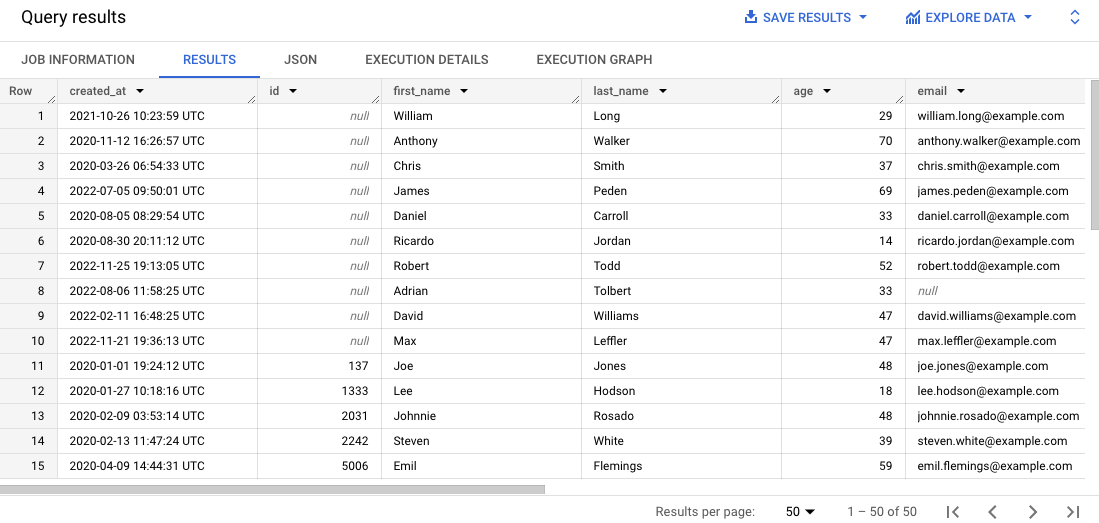

- En el editor de SQL, haz clic en Consulta en SQL (+). Pega la siguiente consulta y, luego, haz clic en Ejecutar:

SELECT * FROM `{{{project_0.project_id}}}.customers.contact_info`

ORDER BY id

LIMIT 50

Esta consulta selecciona 50 registros de la tabla original y los ordena según el ID de cliente en los resultados.

-

Desplázate por los resultados en el panel Resultados.

Ten en cuenta que a algunos registros les faltan los IDs de cliente o tienen correos electrónicos incorrectos, lo que puede dificultar la administración de los pedidos de los clientes.

Haz clic en Revisar mi progreso para verificar el objetivo.

Consultar una tabla de BigQuery para revisar la calidad de los datos

Tarea 3. Crear y subir un archivo de especificación de calidad de los datos

Los requisitos de verificación de calidad de los datos de Dataplex se definen usando los archivos de especificación YAML de CloudDQ. Una vez creado, el archivo de especificación YAML se sube a un bucket de Cloud Storage al que puede acceder el trabajo de calidad de los datos.

El archivo YAML tiene las siguientes cuatro secciones clave:

- Una lista de reglas a ejecutar (ya sean reglas predefinidas o personalizadas)

- Filtros de fila para seleccionar un subconjunto de datos para la validación

- Vinculaciones de reglas para aplicar las reglas a las tablas

- Dimensiones de reglas opcionales para especificar los tipos de reglas que puede contener el archivo YAML

En esta tarea, definirás un nuevo archivo de especificación YAML para verificaciones de calidad de los datos en las que se identifiquen IDs y correos electrónicos nulos de clientes en la tabla de BigQuery especificada. También especificarás un conjunto de datos de BigQuery creado previamente llamado customer_dq_dataset para que almacene los resultados de calidad de los datos en una tabla llamada dq_results.

Después de que definas el archivo, lo subirás a un bucket de Cloud Storage creado previamente para usarlo en una tarea posterior para ejecutar el trabajo de calidad de los datos.

Crea el archivo de especificación de calidad de los datos

- En Cloud Shell, ejecuta el siguiente comando para crear un archivo vacío nuevo para la especificación de calidad de los datos:

nano dq-customer-raw-data.yaml

- Pega el siguiente código en el archivo:

rules:

- nonNullExpectation: {}

column: id

dimension: COMPLETENESS

threshold: 1

- regexExpectation:

regex: '^[^@]+[@]{1}[^@]+$'

column: email

dimension: CONFORMANCE

ignoreNull: true

threshold: .85

postScanActions:

bigqueryExport:

resultsTable: projects/{{{project_0.project_id | Project ID}}}/datasets/customers_dq_dataset/tables/dq_results

- Revisa el código para identificar las dos reglas principales de calidad de los datos que se definen en este archivo.

El archivo dq-customer-raw-data.yaml especifica dos reglas:

- La primera regla se refiere a la dimensión de integridad, como los valores nulos.

- La segunda regla se refiere a la dimensión de cumplimiento, como los valores no válidos.

En este archivo, las dos reglas están vinculadas a columnas de tabla específicas:

- La primera vinculación de regla vincula una regla notNullExpectation a la columna id de la tabla contact_info con un umbral del 100%, lo que valida si la columna ID tiene valores NULL.

- La segunda vinculación de regla vincula una regla regexExpectation a la columna email de la tabla contact_info con un umbral del 85%, que verifica si hay correos electrónicos válidos.

- Ingresa

CTRL+X y, luego, Y para guardar y cerrar el archivo.

Sube el archivo a Cloud Storage

- En Cloud Shell, ejecuta el siguiente comando para subir el archivo a un bucket de Cloud Storage:

gsutil cp dq-customer-raw-data.yaml gs://{{{project_0.project_id | Project ID}}}-bucket

Haz clic en Revisar mi progreso para verificar el objetivo.

Crear y subir un archivo de especificación de calidad de los datos

Tarea 4. Definir y ejecutar un trabajo de calidad de los datos automático en Dataplex

El proceso de calidad de los datos usa un archivo de especificación YAML para ejecutar un trabajo de calidad de los datos y genera métricas relacionadas que se escriben en un conjunto de datos de BigQuery.

En esta tarea, definirás y ejecutarás un trabajo de calidad de los datos automático usando el archivo de especificación YAML correspondiente en Cloud Storage. Cuando defines el trabajo, también especificas el conjunto de datos customer_dq_dataset para que almacene los resultados de calidad de los datos.

- En Cloud Shell, ejecuta el siguiente comando para crear un análisis de calidad de los datos:

gcloud dataplex datascans create data-quality customer-orders-data-quality-job \

--project={{{project_0.project_id | Project ID}}} \

--location={{{project_0.default_region | Region}}} \

--data-source-resource="//bigquery.googleapis.com/projects/{{{project_0.project_id | Project ID}}}/datasets/customers/tables/contact_info" \

--data-quality-spec-file="gs://{{{project_0.project_id | Project ID}}}-bucket/dq-customer-raw-data.yaml"

Note: En este lab, la cuenta de servicio predeterminada de Compute Engine ya se configuró previamente para tener los roles y permisos de IAM adecuados. Para obtener más información, consulta la documentación de Dataplex Universal Catalog titulada Crea una cuenta de servicio.

-

Regresa a la consola. Deberías seguir en Dataplex Universal Catalog.

-

En Administrar, haz clic en Calidad y creación de perfiles de datos.

-

Haz clic en customer-orders-data-quality-job.

-

Haz clic en Ejecutar ahora.

Nota: El trabajo puede tardar varios minutos en ejecutarse.

Cuando se haya completado el trabajo, nota que su estado será 1 dimensión 1 regla con errores.

- Haz clic en Ver resultados.

Observa que la regla de calidad de los datos para la columna email es Aprobado, pero para la columna id, es Con errores. Esto es lo que se espera por los siguientes motivos:

-

La regla para la columna id es una Verificación de NULL con un umbral del 100%. Esto significa que, para que la regla se apruebe, todas las filas deben tener un valor para el ID. En este caso, el 10% de las filas de la columna id de la tabla contact_info tienen valores nulo. Por lo tanto, esta regla mostrará el mensaje Con errores.

-

La regla para la columna email es una verificación de regex con un umbral del 85%. Esto significa que la regla fallará si el 15% de los registros tiene un formato de correo electrónico no válido. En este caso, ~10.5% de las filas de la columna email de la tabla contact_info tienen un correo electrónico no válido. Por lo tanto, esta regla muestra el mensaje Aprobado.

Haz clic en Revisar mi progreso para verificar el objetivo.

Definir y ejecutar un trabajo de calidad de los datos en Dataplex Universal Catalog

Tarea 5. Revisar los resultados de la calidad de los datos en BigQuery

En esta tarea, revisarás las tablas en el conjunto de datos customers_dq_dataset para identificar registros a los que les faltan valores de ID de cliente o que tienen valores no válidos de correos electrónicos.

-

Vuelve a BigQuery y, en el panel Explorador, expande la flecha que aparece junto al ID de tu proyecto para ver una lista de los contenidos:

-

Haz clic en la flecha de expandir junto al conjunto de datos customer_dq_dataset.

-

Haz clic en la tabla dq_results.

-

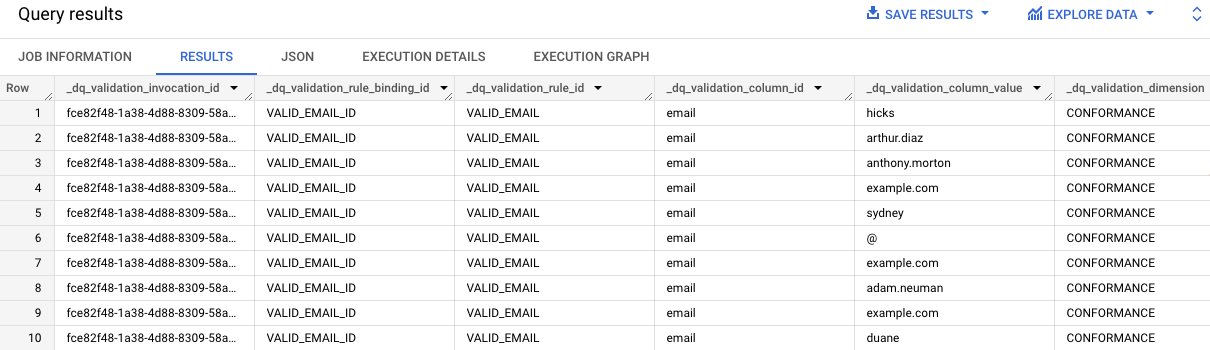

Haz clic en la pestaña Vista previa para consultar los resultados.

-

Desplázate hasta la columna llamada rule_failed_records_query.

-

Copia la consulta, que comienza con WITH.

-

Haz clic en Consulta en SQL (+). Copia y pega la consulta en el Editor de SQL y haz clic en Ejecutar.

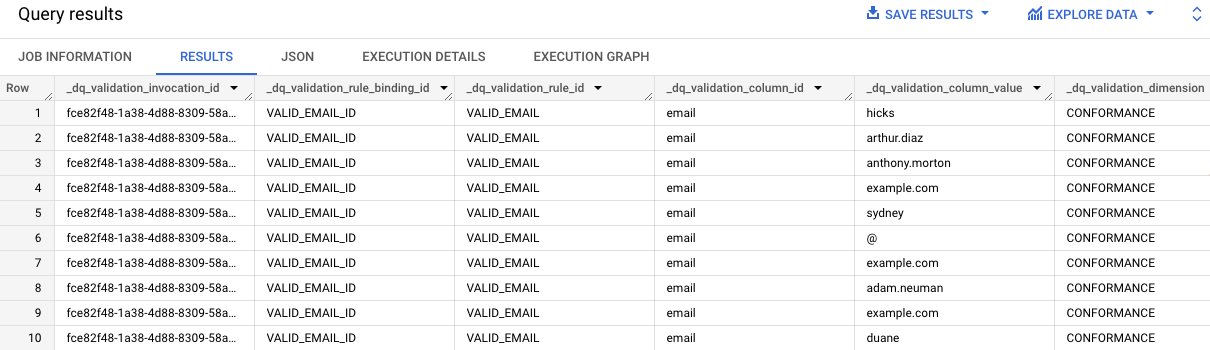

Los resultados de la consulta proporcionan valores de correo electrónico en la tabla contact_info que no son válidos. Observa "email" en cada entrada de la columna dq_validation_column_id.

-

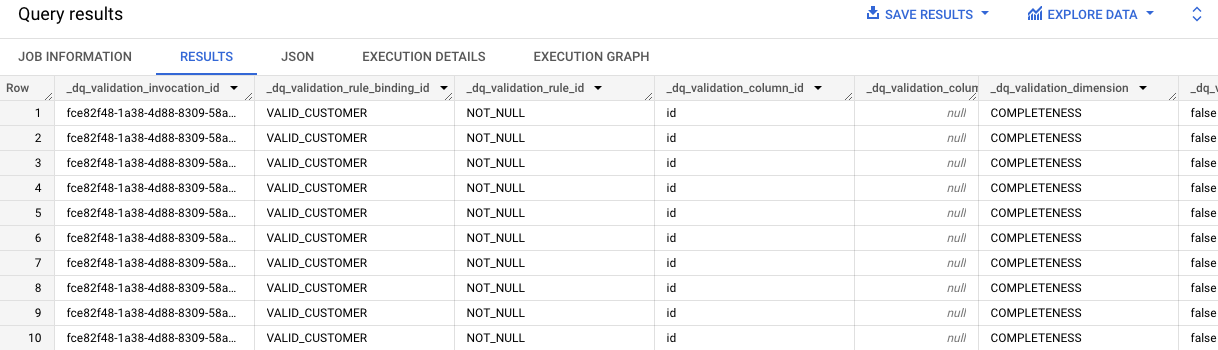

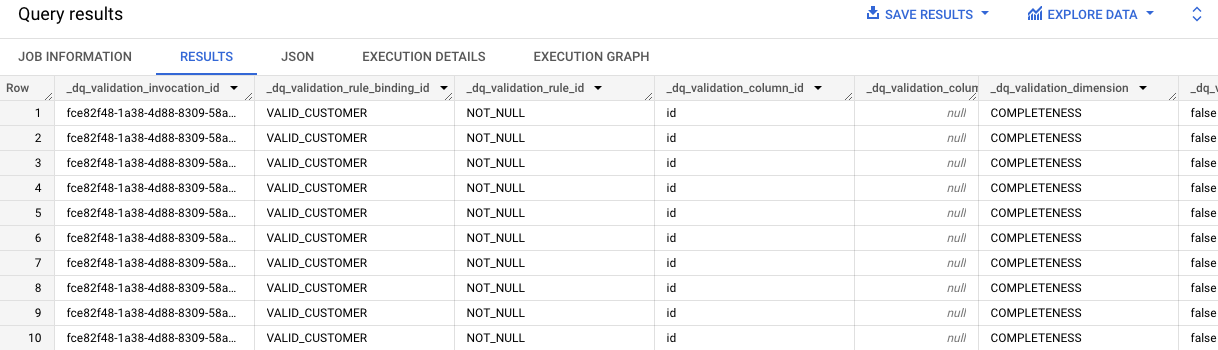

Repite los pasos 7 y 8 para la segunda celda que incluye la consulta para los resultados de la regla VALID_CUSTOMER.

Estos resultados identifican que hay 10 registros en la tabla contact_info a los que les faltan los valores de ID.

Observa "id" en cada entrada de la columna dq_validation_column_id.

Haz clic en Revisar mi progreso para verificar el objetivo.

Revisar los resultados de la calidad de los datos en la tabla de BigQuery

¡Felicitaciones!

Evaluaste la calidad de los datos con Dataplex Universal Catalog creando un archivo de especificación de calidad de los datos personalizado y usándolo para ejecutar un trabajo relacionado en una tabla de BigQuery.

Capacitación y certificación de Google Cloud

Recibe la formación que necesitas para aprovechar al máximo las tecnologías de Google Cloud. Nuestras clases incluyen habilidades técnicas y recomendaciones para ayudarte a avanzar rápidamente y a seguir aprendiendo. Para que puedas realizar nuestros cursos cuando más te convenga, ofrecemos distintos tipos de capacitación de nivel básico a avanzado: a pedido, presenciales y virtuales. Las certificaciones te ayudan a validar y demostrar tus habilidades y tu conocimiento técnico respecto a las tecnologías de Google Cloud.

Actualización más reciente del manual: 2 de septiembre de 2025

Prueba más reciente del lab: 2 de septiembre de 2025

Copyright 2025 Google LLC. All rights reserved. Google y el logotipo de Google son marcas de Google LLC. Los demás nombres de productos y empresas pueden ser marcas de las respectivas empresas a las que estén asociados.

en la parte superior de la consola de Google Cloud.

en la parte superior de la consola de Google Cloud. )> Ver todos los productos, navega a Analytics > Dataplex Universal Catalog.

)> Ver todos los productos, navega a Analytics > Dataplex Universal Catalog.