GSP1096

Présentation

Cet atelier vous permet de vous familiariser avec le déploiement de SingleStoreDB et son association à des produits cloud natifs de Google Cloud, tels que Pub/Sub, Dataflow et Cloud Storage. Pour illustrer les caractéristiques de ce produit, nous allons utiliser l'ensemble de données public sur les taxis new-yorkais.

L'atelier commence par le déploiement de SingleStoreDB dans votre navigateur local et la création du schéma approprié. Ensuite, vous allez utiliser Pub/Sub pour transférer les données vers Cloud Storage en temps réel à l'aide de Dataflow. Les données générées et hébergées dans le stockage d'objets seront consommées à l'aide du pipeline natif de SingleStoreDB. Une fois les données ingérées par SingleStoreDB, vous exécuterez des requêtes et interagirez avec SingleStore.

Points abordés

Dans cet atelier, vous allez apprendre à :

- vous connecter à Google Cloud et l'utiliser ;

- créer une instance/un cluster de base de données SingleStore ;

- utiliser Cloud Shell pour vous connecter à SingleStoreDB et y créer un schéma ;

- créer des sujets et des abonnements Pub/Sub, et extraire ou envoyer des données vers d'autres services ;

- créer un job Dataflow en flux continu ;

- utiliser le pipeline natif de SingleStore pour charger des données à partir du stockage d'objets ;

- exécuter des requêtes et interagir avec vos données dans SingleStore.

Prérequis

Vous devez avoir accès à un compte de messagerie personnel pour pouvoir répondre à l'e-mail de validation envoyé par SingleStore. Durant cet atelier, vous devrez répondre à un code de validation et cela n'est possible qu'avec une adresse e-mail personnelle.

Une connaissance préalable de Google Cloud et de SingleStore est recommandée, mais pas indispensable.

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Des identifiants temporaires vous sont fournis pour vous permettre de vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- Vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome).

Remarque : Ouvrez une fenêtre de navigateur en mode incognito (recommandé) ou de navigation privée pour effectuer cet atelier. Vous éviterez ainsi les conflits entre votre compte personnel et le compte temporaire de participant, qui pourraient entraîner des frais supplémentaires facturés sur votre compte personnel.

- Vous disposez d'un temps limité. N'oubliez pas qu'une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Remarque : Utilisez uniquement le compte de participant pour cet atelier. Si vous utilisez un autre compte Google Cloud, des frais peuvent être facturés à ce compte.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, une boîte de dialogue s'affiche pour vous permettre de sélectionner un mode de paiement.

Sur la gauche, vous trouverez le panneau "Détails concernant l'atelier", qui contient les éléments suivants :

- Le bouton "Ouvrir la console Google Cloud"

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google Cloud (ou effectuez un clic droit et sélectionnez Ouvrir le lien dans la fenêtre de navigation privée si vous utilisez le navigateur Chrome).

L'atelier lance les ressources, puis ouvre la page "Se connecter" dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte.

-

Si nécessaire, copiez le nom d'utilisateur ci-dessous et collez-le dans la boîte de dialogue Se connecter.

{{{user_0.username | "Username"}}}

Vous trouverez également le nom d'utilisateur dans le panneau "Détails concernant l'atelier".

-

Cliquez sur Suivant.

-

Copiez le mot de passe ci-dessous et collez-le dans la boîte de dialogue Bienvenue.

{{{user_0.password | "Password"}}}

Vous trouverez également le mot de passe dans le panneau "Détails concernant l'atelier".

-

Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis pour l'atelier. Ne saisissez pas ceux de votre compte Google Cloud.

Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés.

-

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas à des essais sans frais.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Remarque : Pour accéder aux produits et services Google Cloud, cliquez sur le menu de navigation ou saisissez le nom du service ou du produit dans le champ Recherche.

Tâche 1 : Lancer votre propre cluster SingleStore

À ce stade, vous devriez être connecté à la console Google Cloud dans une fenêtre de navigation privée.

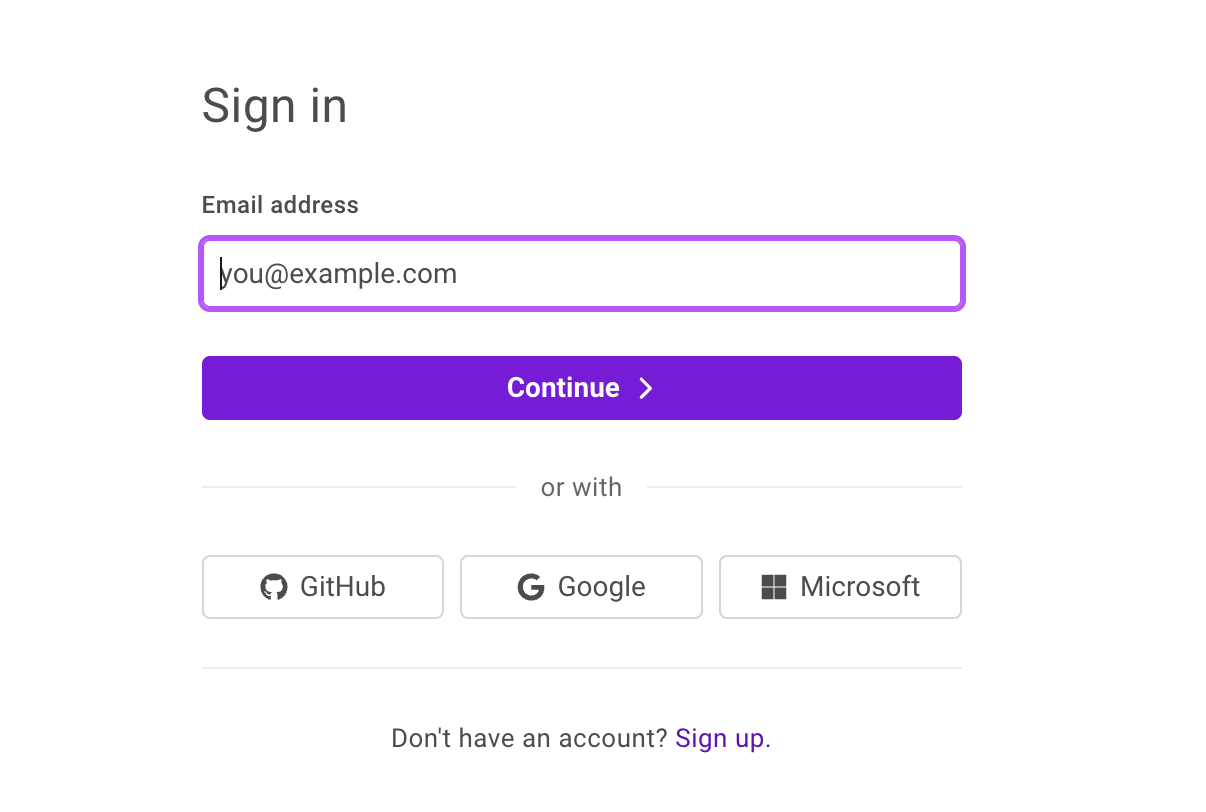

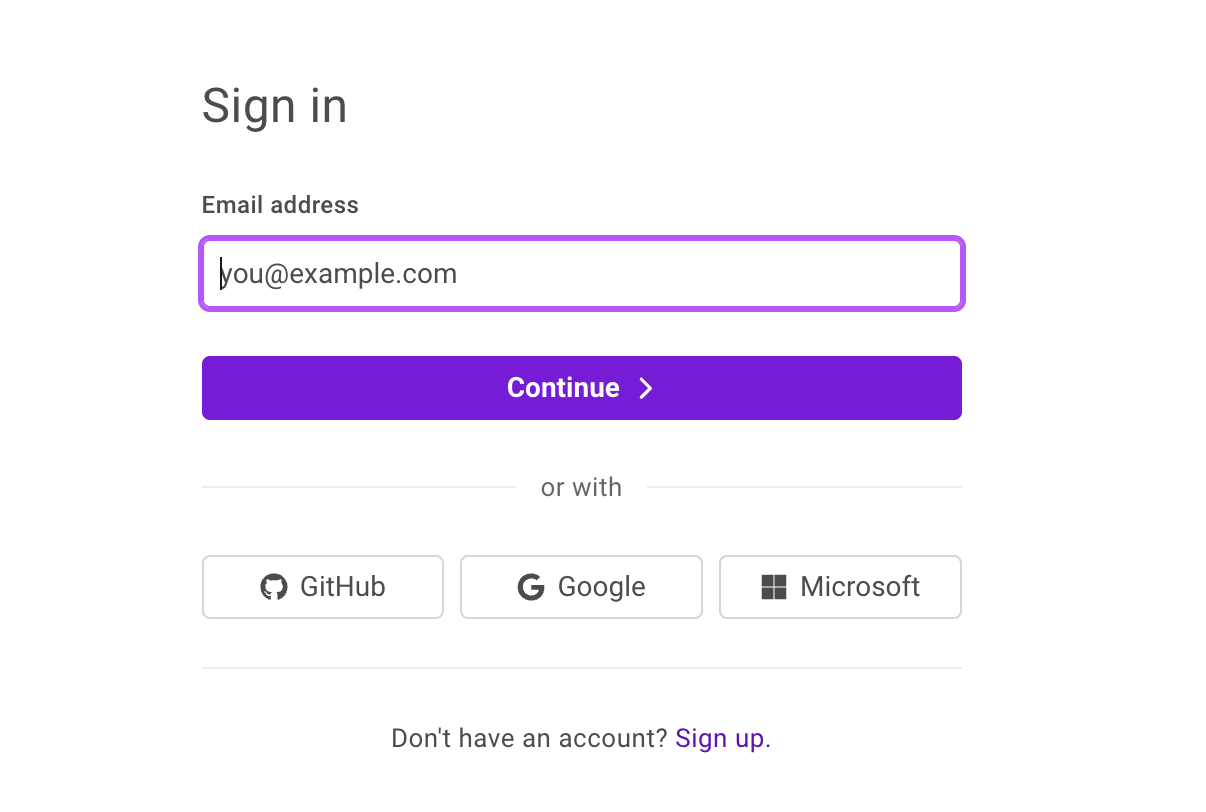

- Dans un autre onglet de la fenêtre de navigation privée que vous avez ouverte, accédez au portail SingleStore. La page illustrée ci-dessous doit s'afficher :

- Cliquez sur Sign Up (S'inscrire) et renseignez les informations vous concernant.

- Dans le champ Company email address (Adresse e-mail d'entreprise), saisissez votre adresse e-mail personnelle.

- Cliquez sur Continue (Continuer).

- Saisissez un mot de passe unique, puis cliquez sur Continue (Continuer) pour vous connecter à SingleStore.

- Saisissez le code de validation reçu à votre adresse e-mail, puis cliquez sur Submit (Envoyer).

- Cochez la case Terms of Service + Privacy Policy (Conditions d'utilisation + Règles de confidentialité), puis cliquez sur Continue (Continuer).

- Sur l'écran About your project (À propos de votre projet), sélectionnez l'une des options, puis cliquez sur Next (Suivant).

- Cliquez sur View my Deployment (Afficher mon déploiement) pour accéder au portail client SingleStore.

- Cliquez sur Start Using SingleStore (Commencer à utiliser SingleStore) lorsque le message Your free starter workspace is ready! (Votre espace de travail de démarrage sans frais est prêt !) s'affiche.

Créer l'espace de travail

-

En haut à gauche, cliquez sur + Create New (Créer), puis sélectionnez Deployment (Déploiement).

-

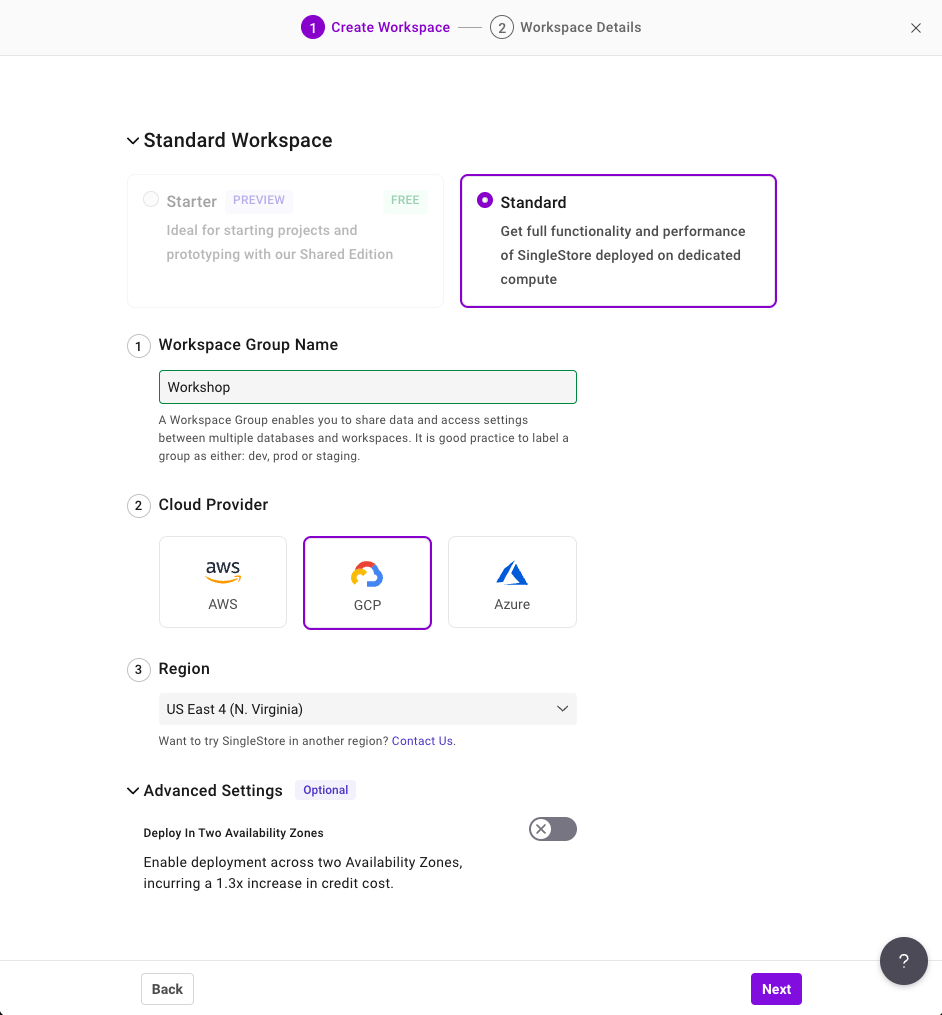

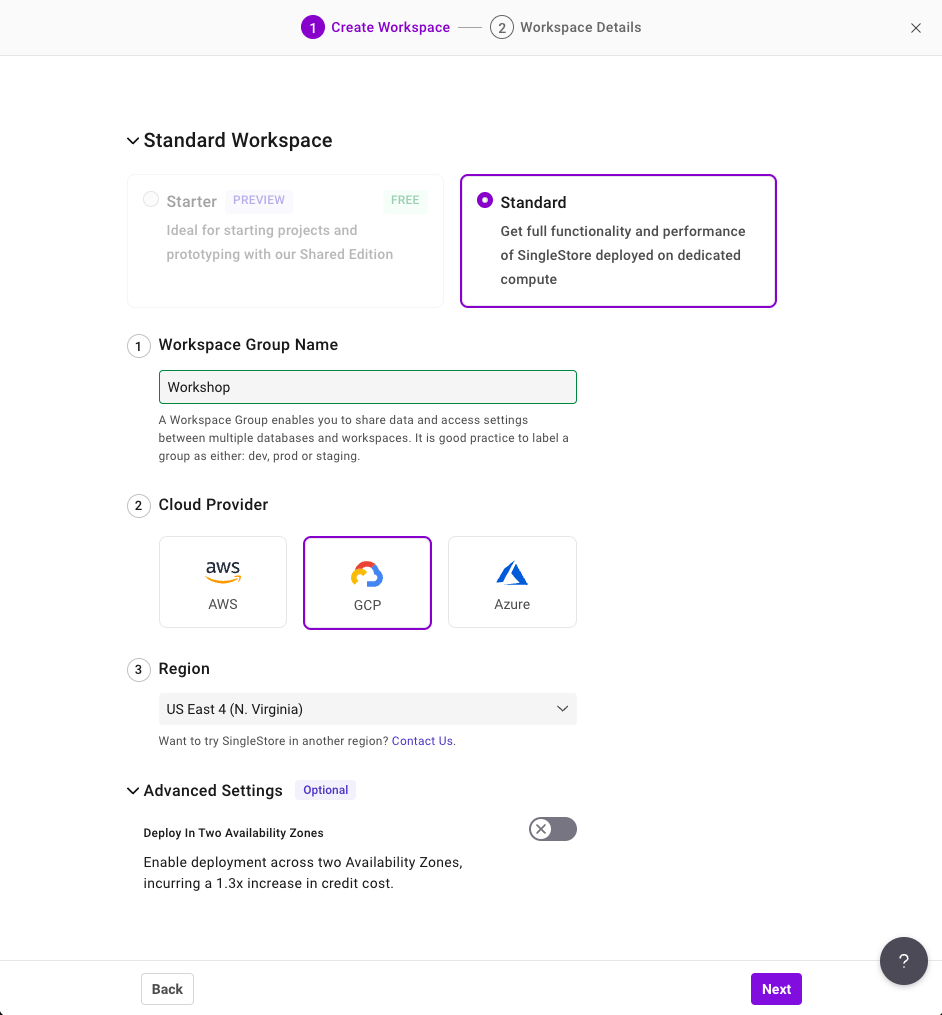

Sur la page "Create Workspace" (Créer un espace de travail), configurez les paramètres suivants :

- "Workspace Group Name" (Nom du groupe d'espaces de travail) : Workshop (Atelier)

- "Cloud Provider" (Fournisseur cloud) : GCP

- "Region" (Région) : US East 4 (N. Virginia). Cette région doit être sélectionnée par défaut. Si ce n'est pas le cas, modifiez-la.

Votre configuration doit se présenter comme suit :

-

Cliquez sur Next (Suivant).

-

Sur la page Workspace Details (Détails de l'espace de travail), conservez les paramètres par défaut et cliquez sur Create Workspace (Créer l'espace de travail).

Patientez quelques minutes pendant le démarrage de votre espace de travail. Il génère pour vous un exemple de base de données, que vous n'utiliserez cependant pas dans cet atelier.

Tâche 2 : Se connecter à SingleStore et Google Cloud

-

Avant de vous connecter à l'espace de travail SingleStore, revenez dans la console Google Cloud.

-

Ouvrez une nouvelle fenêtre Cloud Shell en cliquant sur l'icône Activer Cloud Shell ( ) en haut à droite de la console. Si vous y êtes invité, cliquez sur Continuer, puis sur Autoriser.

) en haut à droite de la console. Si vous y êtes invité, cliquez sur Continuer, puis sur Autoriser.

-

Dans Cloud Shell, exécutez les commandes suivantes pour cloner le dépôt GitHub et télécharger le code de l'atelier.

git clone https://github.com/mlochbihler/singlestore-gcp-looker-devday-01

cd singlestore-gcp-looker-devday-01/section_b

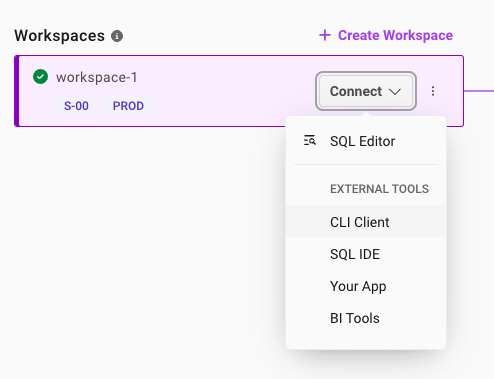

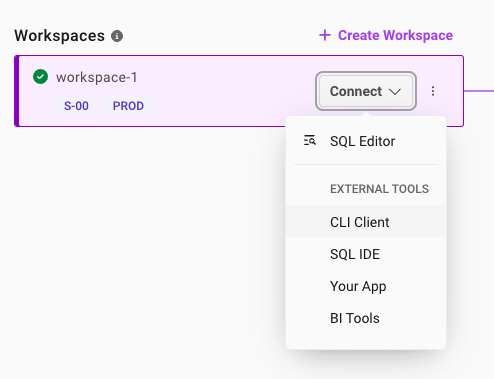

- Revenez au portail SingleStore. Une fois votre espace de travail initialisé, cliquez sur la flèche du menu déroulant à côté de Connect (Se connecter), puis sélectionnez CLI Client (Client CLI).

-

Sur la page Connect to Workspace (Se connecter à l'espace de travail), commencez par copier le mot de passe qui a été généré pour vous. Une icône de copie s'affiche à côté du mot de passe. Nous vous recommandons de l'enregistrer dans un fichier local, car vous en aurez besoin plus tard dans cet atelier.

-

Cliquez sur l'icône Copy (Copier) à droite de la commande MySQL. La commande est alors copiée dans votre presse-papiers.

La commande MySQL doit ressembler à ceci : mysql -u admin -h svc-b675ae2f-b129-4baf-86ca-0a03c2c31d19-dml.gcp-virginia-1.svc.singlestore.com -P 3306 --default-auth=mysql_native_password --password

Remarque : Il est possible que le mot de passe que vous venez de créer soit visible dans la commande MySQL ci-dessus. Cela se produit uniquement la première fois que vous ouvrez cette fenêtre. Le mot de passe n'est plus affiché par la suite. Il est donc important de l'enregistrer.

Si, pour une raison quelconque, vous ne parvenez pas à vous connecter à la base de données SingleStore, vous pouvez réinitialiser votre mot de passe en ouvrant l'onglet Access (Accès) et en cliquant sur Reset (Réinitialiser).

-

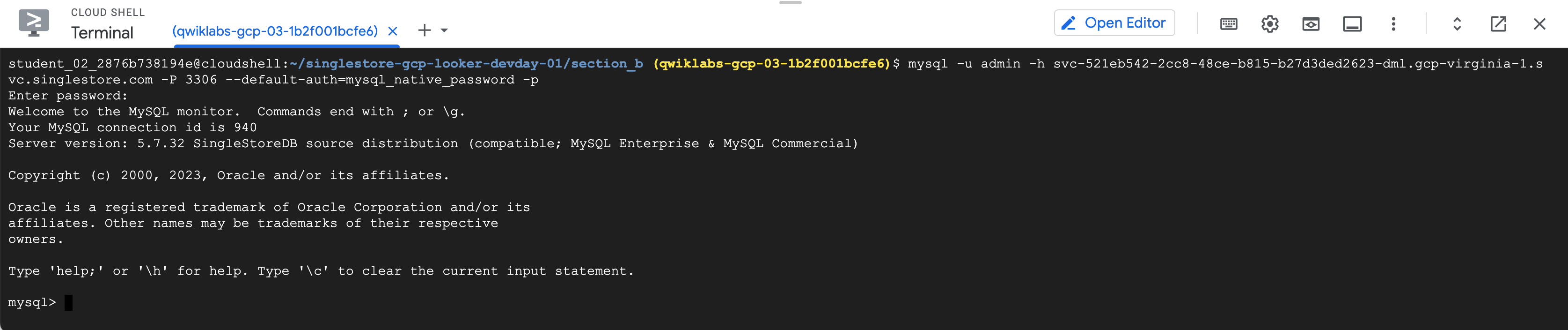

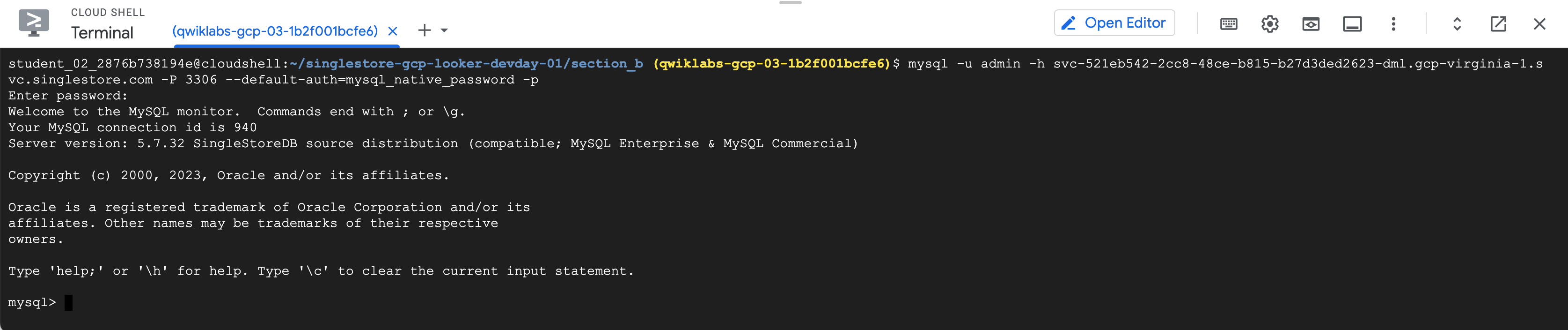

Revenez à la console Google Cloud et à votre instance Cloud Shell.

-

Collez la commande MySQL dans le terminal.

-

Si vous y êtes invité, saisissez le mot de passe que vous avez copié précédemment. L'invite "mysql>" s'affiche alors.

Remarque :

Si votre déploiement cesse de répondre aux commandes MySQL, vérifiez l'état de l'espace de travail dans SingleStore. Il est configuré pour se mettre en pause si vous le laissez inactif pendant plus de 20 minutes. Si c'est le cas, le bouton affiche Resume (Réactiver). Cliquez dessus pour reprendre les opérations. Cela ne devrait prendre que quelques minutes.

Tâche 3 : Créer un schéma et interagir avec SingleStore

Dans cette section, vous allez créer les schémas des tables.

Vous allez utiliser le code LDD ci-dessous pour créer une base de données nommée nyc_taxi.

- À l'invite mysql>, exécutez le code suivant :

source create_nyctaxi_tables.ddl;

use nyc_taxi; show tables;

Vous devriez obtenir des résultats semblables à ce qui suit.

Résultat :

Database changed

+--------------------+

| Tables_in_nyc_taxi |

+--------------------+

| avgcost |

| avgdist |

| avgriders |

| avgridetime |

| avgwait_driver |

| avgwait_passenger |

| drivers |

| nab_nyctaxi_scored |

| neighborhoods |

| trips |

| triptotals |

| triptotalsc |

+--------------------+

12 rows in set (0.05 sec)

Le schéma est créé et les tables de la base de données sont listées.

- Exécutez la commande suivante :

select * from avgcost limit 5;

Le résultat de cette requête est "Empty set" ou "0". Cela est dû au fait que vous n'avez créé que le schéma. La table est vide.

Prenez un instant pour faire le point. Vous avez créé la base de données SingleStore et vous y êtes connecté. Le schéma est configuré, mais il ne contient pas encore de données.

Si vous avez du temps devant vous, n'hésitez pas à explorer SingleStore.

Tâche 4 : Explorer les données de l'atelier (facultatif)

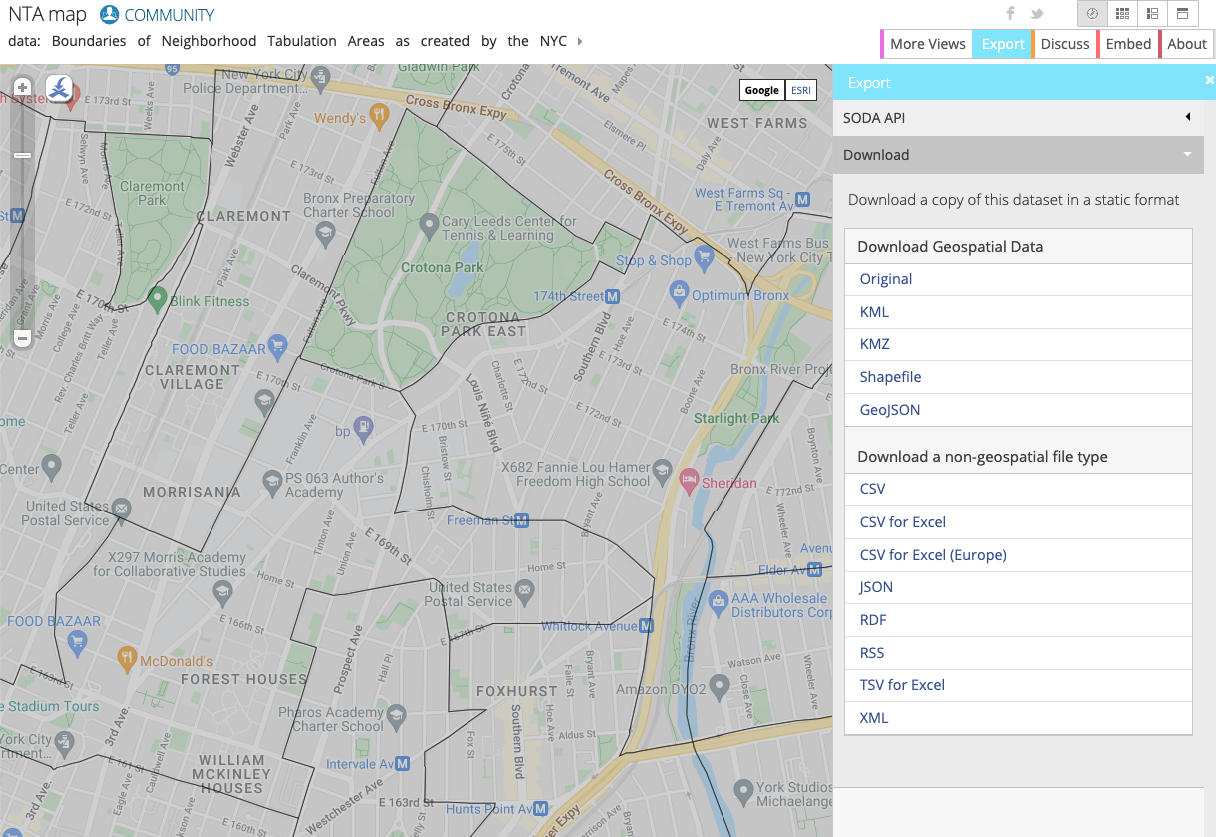

Dans l'atelier d'aujourd'hui, vous allez utiliser les données sur les taxis new-yorkais. Ces données sont disponibles dans les ensembles de données publics de BigQuery ou sur le site Web NYC Open Data.

Ces données ont été préalablement placées pour vous dans un bucket Cloud Storage. Vous n'avez donc pas besoin de les télécharger ni de les importer dans Google Cloud. Vous pouvez explorer les données si vous le souhaitez.

Le site Web NYC Open Data fournit des ensembles de données en libre accès liés à la ville de New York, y compris des données sur les taxis, l'éducation, la police et plus encore.

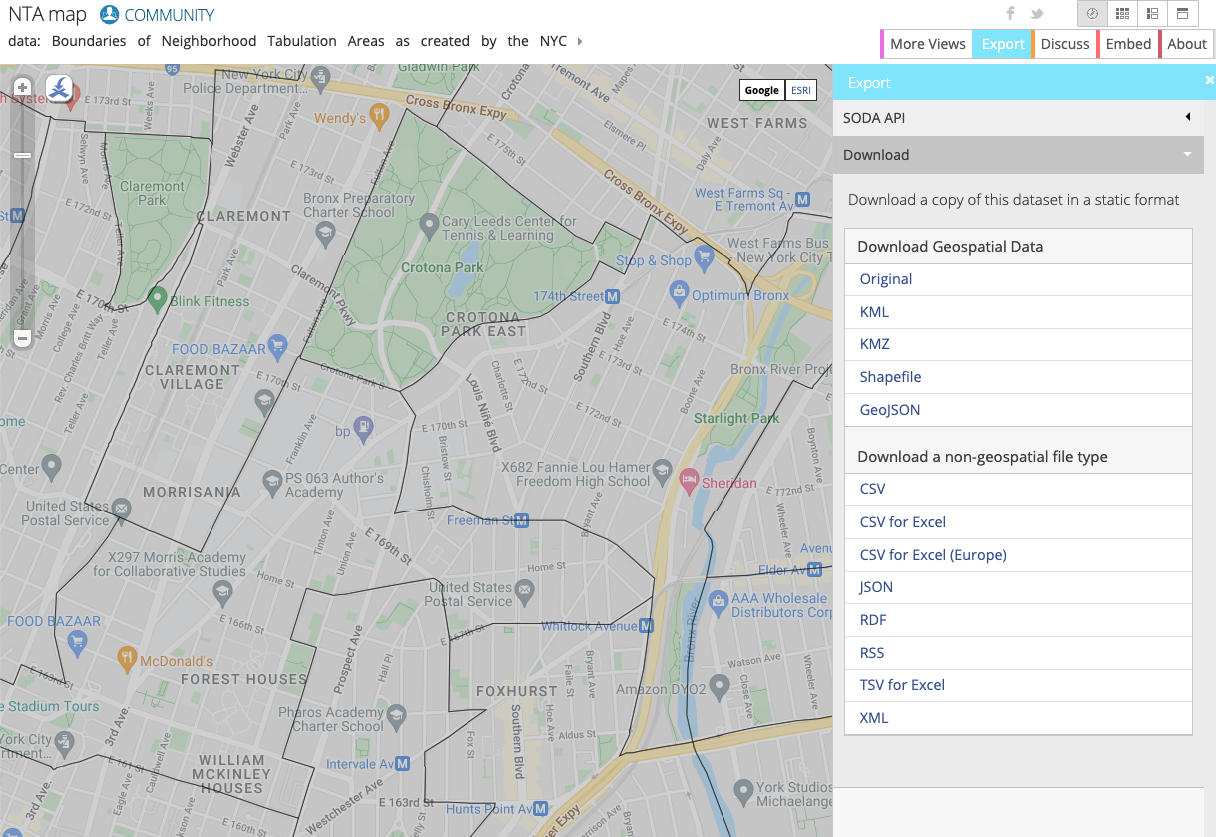

Dans cet atelier, vous allez exploiter les données Neighborhood Tabulation Areas (NTAs) du département de l'urbanisme de la ville de New York, qui fournissent des informations sur les zones et quartiers de la ville. Vous utiliserez ces informations conjointement aux données sur les taxis new-yorkais pour voir où les passagers ont été pris en charge et déposés.

Sur le site Web, vous pouvez visualiser les données par quartier :

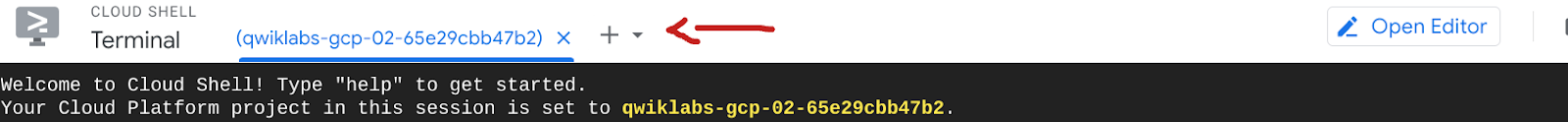

Tâche 5 : Configurer un bucket Cloud Storage

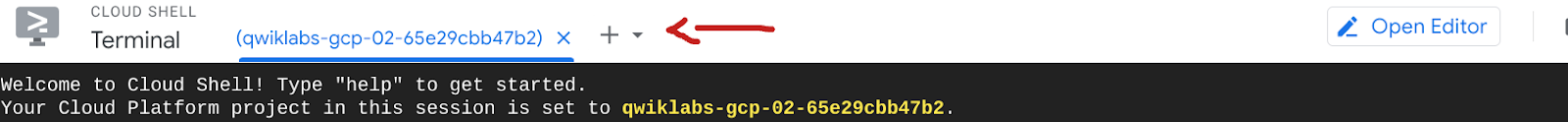

- Avant d'aborder cette section, ouvrez un nouvel onglet de terminal Cloud Shell en cliquant sur le bouton + :

Dans Google Cloud, vous pouvez configurer des ressources de deux manières principales : avec l'interface utilisateur graphique (IUG) et avec l'interface de ligne de commande (CLI). Dans cet atelier, vous allez utiliser la CLI pour créer le bucket et obtenir les données les plus récentes sur les quartiers à partir du site Web NYC Open Data.

- Copiez et exécutez les commandes suivantes pour créer votre propre bucket, puis importer les données depuis un bucket public dans ce bucket :

gcloud storage buckets create gs://$GOOGLE_CLOUD_PROJECT --location={{{ project_0.default_region | "REGION" }}}

gcloud storage cp -r gs://configuring-singlestore-on-gcp/drivers gs://$GOOGLE_CLOUD_PROJECT

gcloud storage cp -r gs://configuring-singlestore-on-gcp/trips gs://$GOOGLE_CLOUD_PROJECT

gcloud storage cp gs://configuring-singlestore-on-gcp/neighborhoods.csv gs://$GOOGLE_CLOUD_PROJECT

Cliquez sur Autoriser si vous y êtes invité.

Notez qu'un autre bucket a déjà été créé dans votre projet. Ne vous préoccupez pas de ce bucket : il s'agit d'un emplacement de préproduction/stockage temporaire pour Dataflow.

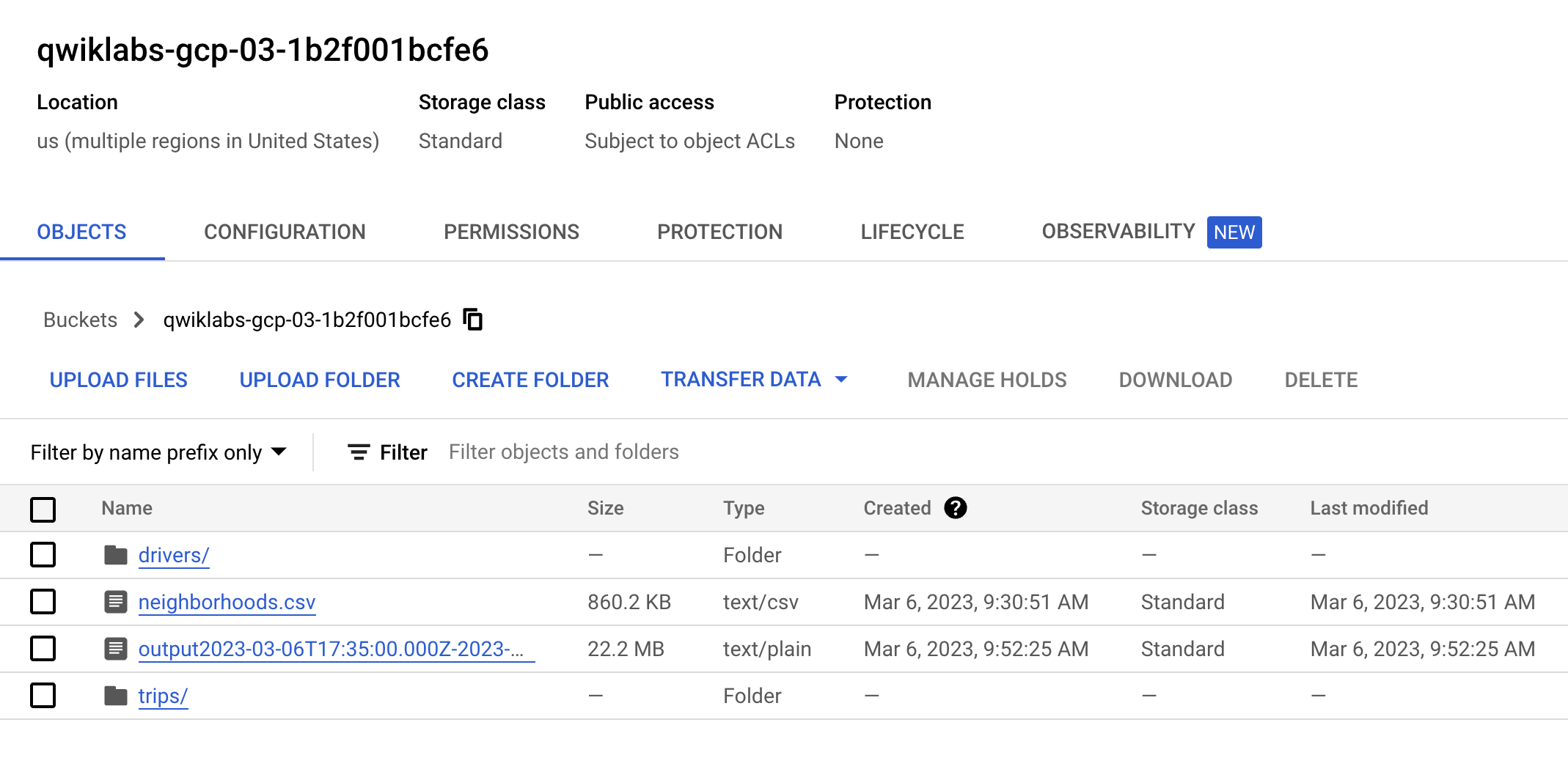

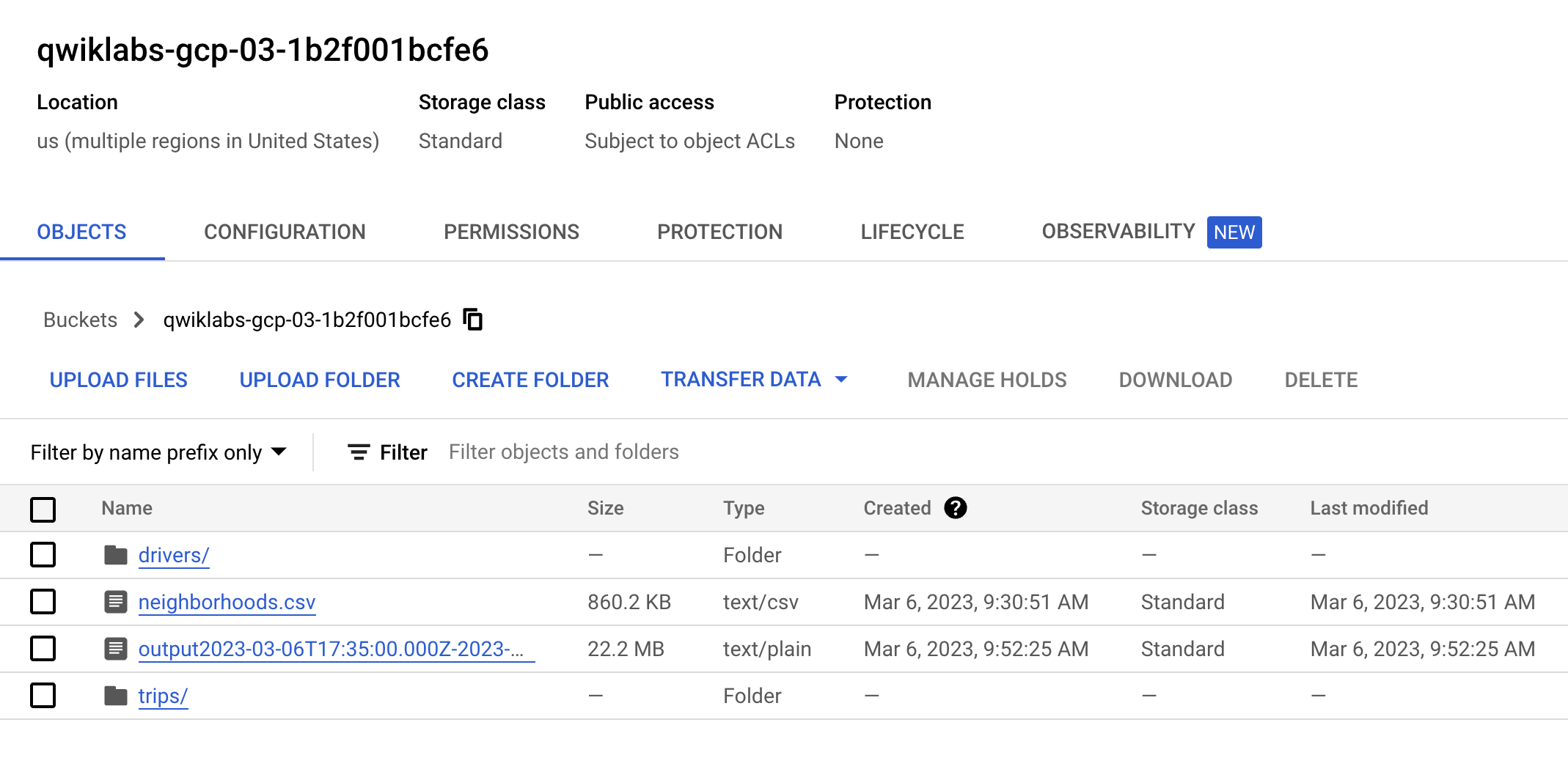

- Accédez à Cloud Storage > Buckets, recherchez votre bucket () et vérifiez qu'il contient deux dossiers et un fichier CSV, qui devraient ressembler à ceci :

Cliquez sur Vérifier ma progression pour valider l'objectif.

Configurer le bucket Cloud Storage

Tâche 6 : Configurer Pub/Sub et un job Dataflow en flux continu

Les ressources Pub/Sub et Dataflow ont été préremplies dans votre projet. Pour les afficher, utilisez le champ de recherche en haut de la console Cloud et recherchez respectivement Pub/Sub et Dataflow.

- Pour Pub/Sub, procédez comme suit :

- Vérifiez qu'il existe un sujet appelé "Taxi".

- Vérifiez qu'il existe un abonnement nommé "Taxi-sub".

- Pour Dataflow, procédez comme suit :

- Vérifiez qu'il existe un job nommé "GCStoPS" dont l'état est failed (en échec).

-

Cliquez sur le job, puis sur Cloner pour exécuter ce job précis. Renommez-le et vérifiez les informations sur le job (qui sont préremplies puisque vous l'avez cloné) pour savoir ce que vous exécutez. Faites défiler vers le bas, puis cliquez sur Exécuter le job.

-

Revenez à la page Jobs Dataflow et assurez-vous que votre job est à l'état "running (en cours d'exécution).

Remarque : Le démarrage du flux de votre job Dataflow peut prendre cinq à sept minutes.

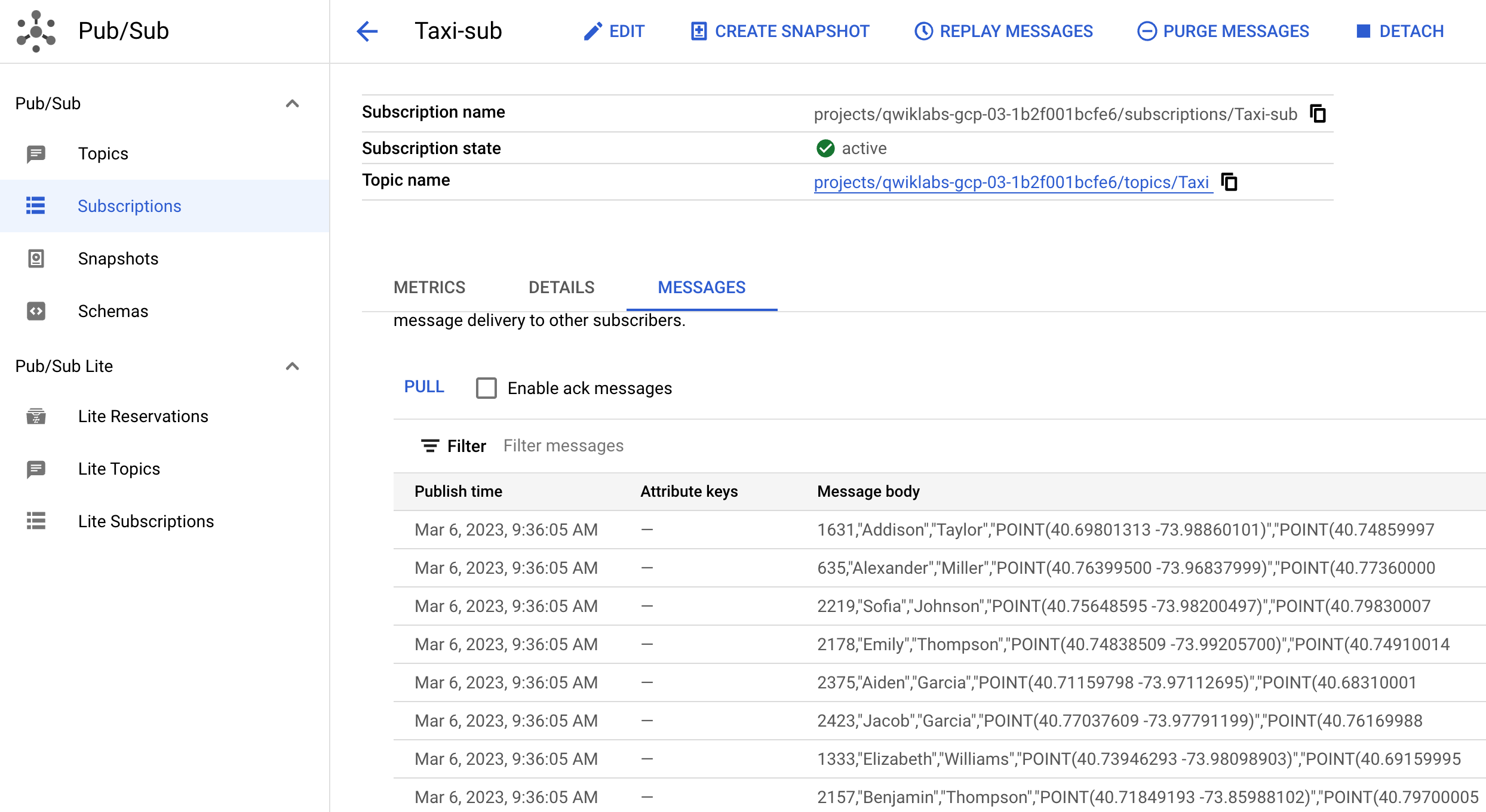

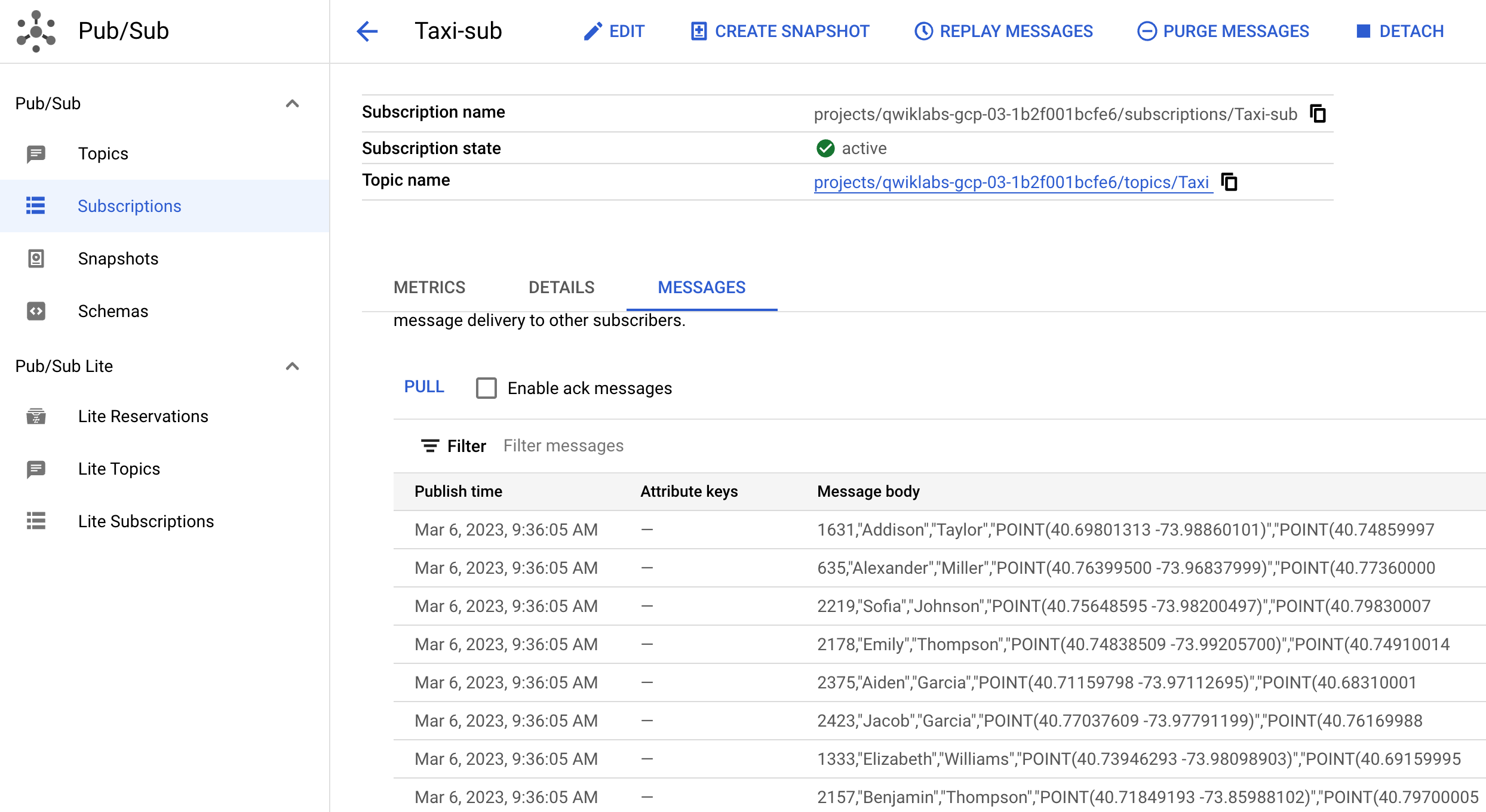

- Revenez à Pub/Sub, recherchez l'abonnement Taxi-sub, cliquez sur Messages, puis sur Extraire. Vous devriez commencer à voir arriver des messages, qui ressemblent à ceci :

Vous avez réussi à simuler un flux de données en direct. À titre d'exemple, si vous étiez amené à importer davantage de données dans GCS et à les extraire dans Pub/Sub, Dataflow déplacerait les données en direct.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Cloner le job Dataflow

Tâche 7 : Configurer une architecture de traitement en flux continu sur Google Cloud

Une architecture courante pour le traitement en flux continu sur Google Cloud se compose de Pub/Sub > Dataflow > GCS. Dans cette tâche, vous allez configurer ces outils, puis connecter SingleStore à GCS.

-

Retournez dans Dataflow.

-

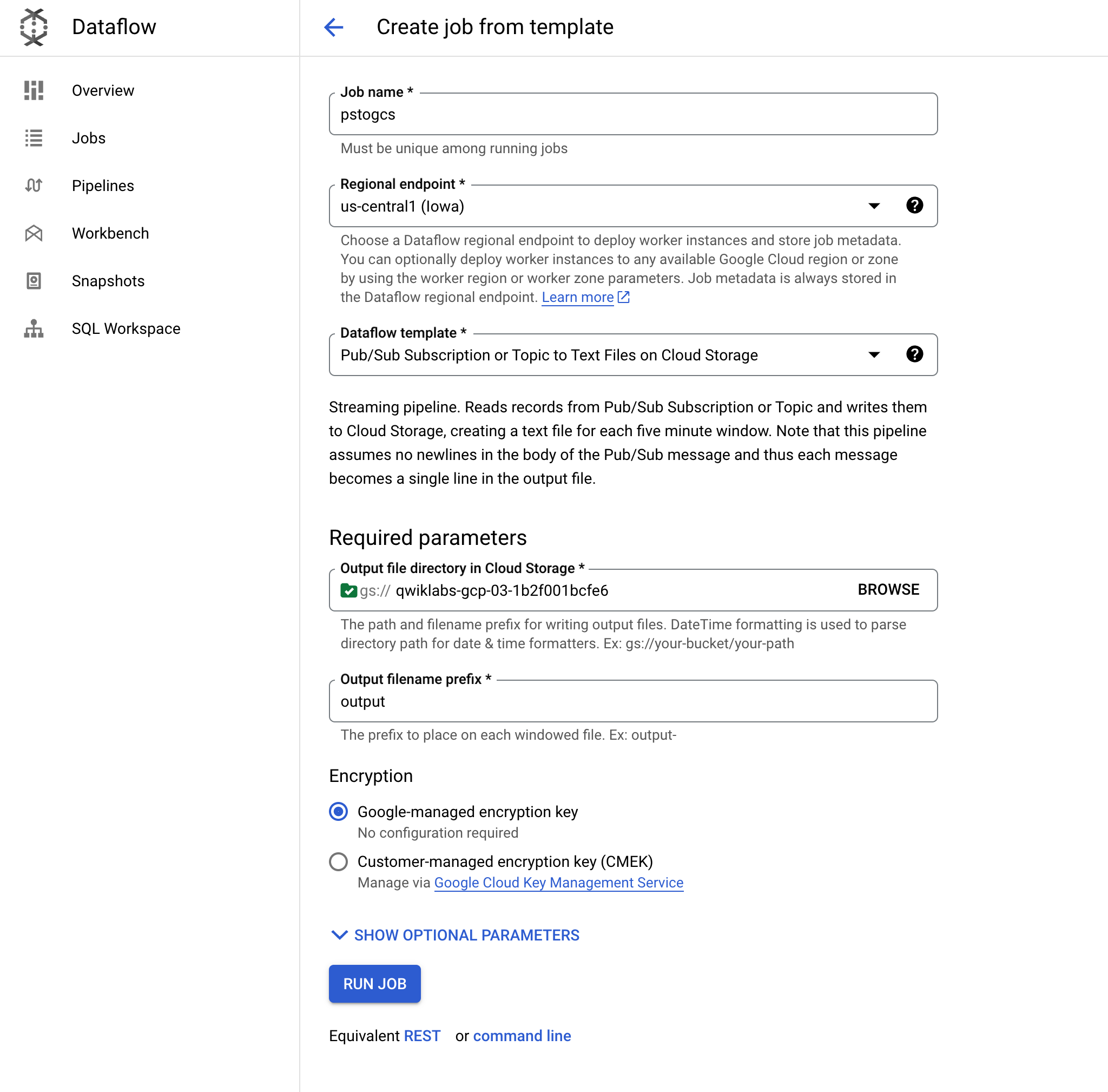

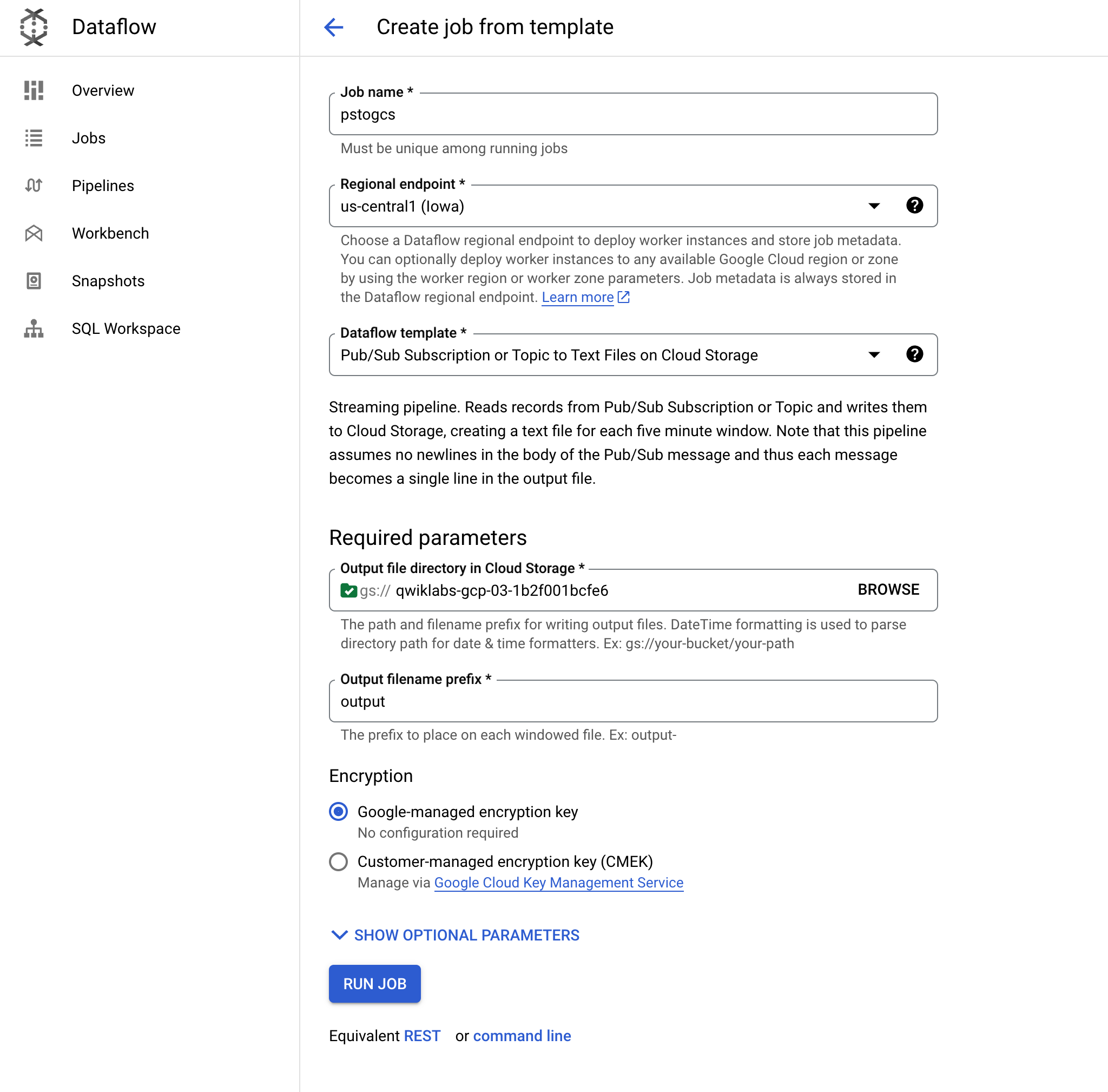

Cliquez sur Créer un job à partir d'un modèle et nommez-le pstogcs ("PubSub to GCS").

-

Sélectionnez comme point de terminaison régional .

-

Sélectionnez le modèle Dataflow suivant : Sujet Pub/Sub ou abonnement vers des fichiers texte dans Cloud Storage. Plusieurs options s'affichent. Vous devrez peut-être effectuer un filtrage pour la trouver.

-

Pour Cible, cliquez sur Parcourir et sélectionnez le bucket que vous avez créé précédemment, appelé . Vous souhaitez que le résultat de ce job soit placé dans le bucket que vous avez créé précédemment dans cet atelier. Cliquez sur Sélectionner.

-

Conservez output comme préfixe du nom de fichier de sortie. Cela permet d'identifier clairement les fichiers de sortie.

-

Développez la section Paramètres sources facultatifs. Pour Abonnement d'entrée Pub/Sub, sélectionnez Taxi-sub, qui est l'abonnement dans lequel vous venez de voir arriver des messages. Vous n'avez pas besoin d'ajouter un sujet d'entrée.

-

Conservez les valeurs par défaut pour tous les autres paramètres, puis accédez au bas de la page et cliquez sur EXÉCUTER LE JOB.

Remarque :

Si vous recevez un message d'erreur lorsque vous tentez d'exécuter le job, vérifiez si les problèmes se situent au niveau des champs de date et d'heure en format personnalisé. Si c'est le cas, supprimez les valeurs de tous ces champs et réessayez.

Ce job Dataflow doit lire les messages que vous avez précédemment vus dans Pub/Sub et les diffuser dans votre bucket Cloud Storage.

Remarque : Le démarrage du flux de votre job Dataflow peut prendre cinq à sept minutes.

-

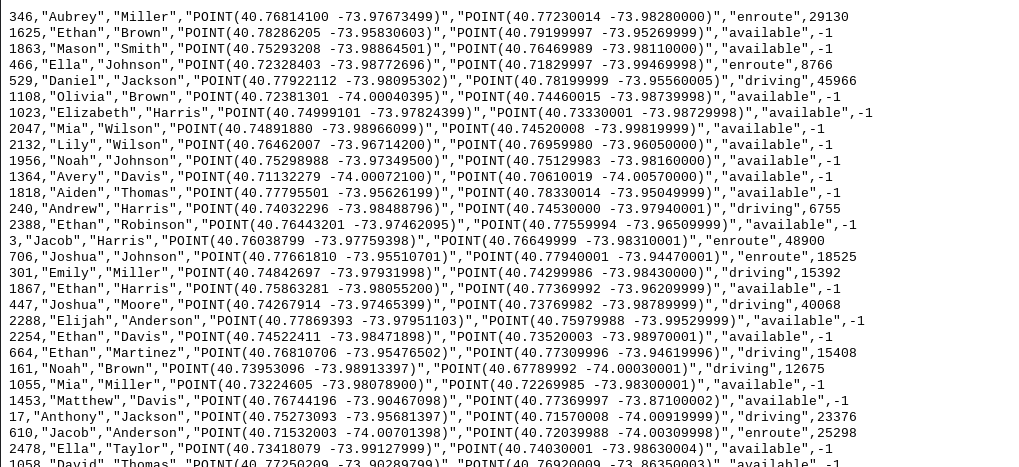

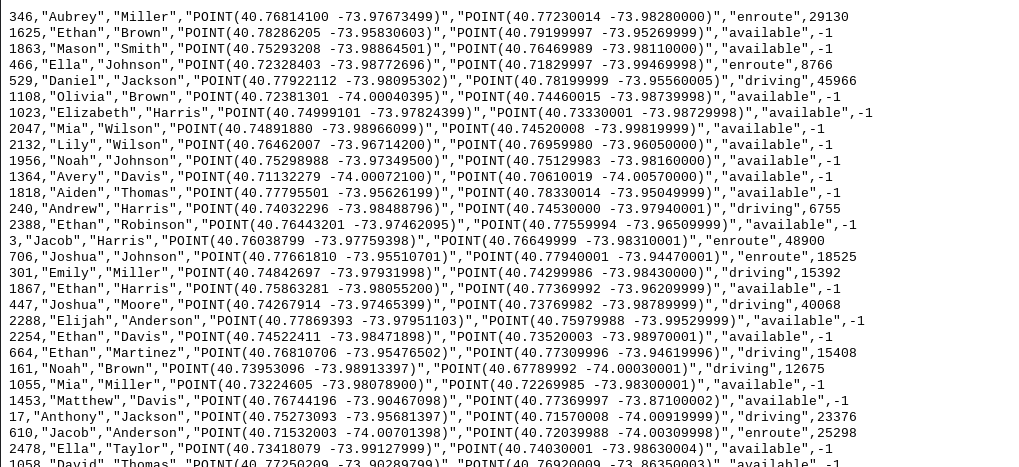

Accédez à Cloud Storage > Buckets et ouvrez votre bucket, . Un fichier de sortie horodaté devrait s'afficher dans le bucket.

-

Cliquez sur le fichier de sortie et sélectionnez Télécharger. Vous devriez y trouver des données sur des courses en taxi, qui incluent des noms, des coordonnées et des horaires.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Configurer une architecture de traitement en flux continu sur Google Cloud

Activer Gemini Code Assist dans Cloud Shell IDE

Vous pouvez utiliser Gemini Code Assist dans un environnement de développement intégré (IDE) tel que Cloud Shell pour obtenir des conseils sur le code ou résoudre des problèmes liés à votre code. Avant de pouvoir utiliser Gemini Code Assist, vous devez l'activer.

- Dans Cloud Shell, activez l'API Gemini pour Google Cloud à l'aide de la commande suivante :

gcloud services enable cloudaicompanion.googleapis.com

- Cliquez sur Ouvrir l'éditeur dans la barre d'outils Cloud Shell.

Remarque : Pour ouvrir l'éditeur Cloud Shell, cliquez sur Ouvrir l'éditeur dans la barre d'outils Cloud Shell. Vous pouvez passer de Cloud Shell à l'éditeur de code et inversement en cliquant sur Ouvrir l'éditeur ou sur Ouvrir le terminal selon le cas.

-

Dans le volet de gauche, cliquez sur l'icône Paramètres. Dans la vue Paramètres, recherchez Gemini Code Assist.

-

Recherchez l'option Geminicodeassist: Enable et assurez-vous que la case correspondante est cochée. Fermez ensuite les Paramètres.

-

Cliquez sur Cloud Code - Aucun projet dans la barre d'état en bas de l'écran.

-

Autorisez le plug-in comme indiqué. Si aucun projet n'est sélectionné automatiquement, cliquez sur Sélectionner un projet Google Cloud, puis choisissez .

-

Vérifiez que votre projet Google Cloud () s'affiche dans le message d'état Cloud Code de la barre d'état.

Connecter Cloud Storage à SingleStore

Vous devez maintenant créer une clé pour connecter ce bucket Cloud Storage privé à SingleStore.

-

Dans Cloud Storage, accédez à Paramètres (dans le menu de navigation).

-

Cliquez sur l'onglet Interopérabilité. En bas de la page, cliquez sur Créer une clé.

Ensuite, vous allez ingérer des données dans SingleStore à l'aide de pipelines et démarrer une procédure stockée.

- Retournez sur l'onglet Cloud Shell dans lequel le terminal SingleStore est ouvert.

-

Pour créer les pipelines SingleStore initiaux, procédez comme suit :

- Dans le premier onglet Cloud Shell, cliquez sur Ouvrir l'éditeur. Si vous y êtes invité, cliquez sur Ouvrir dans une nouvelle fenêtre.

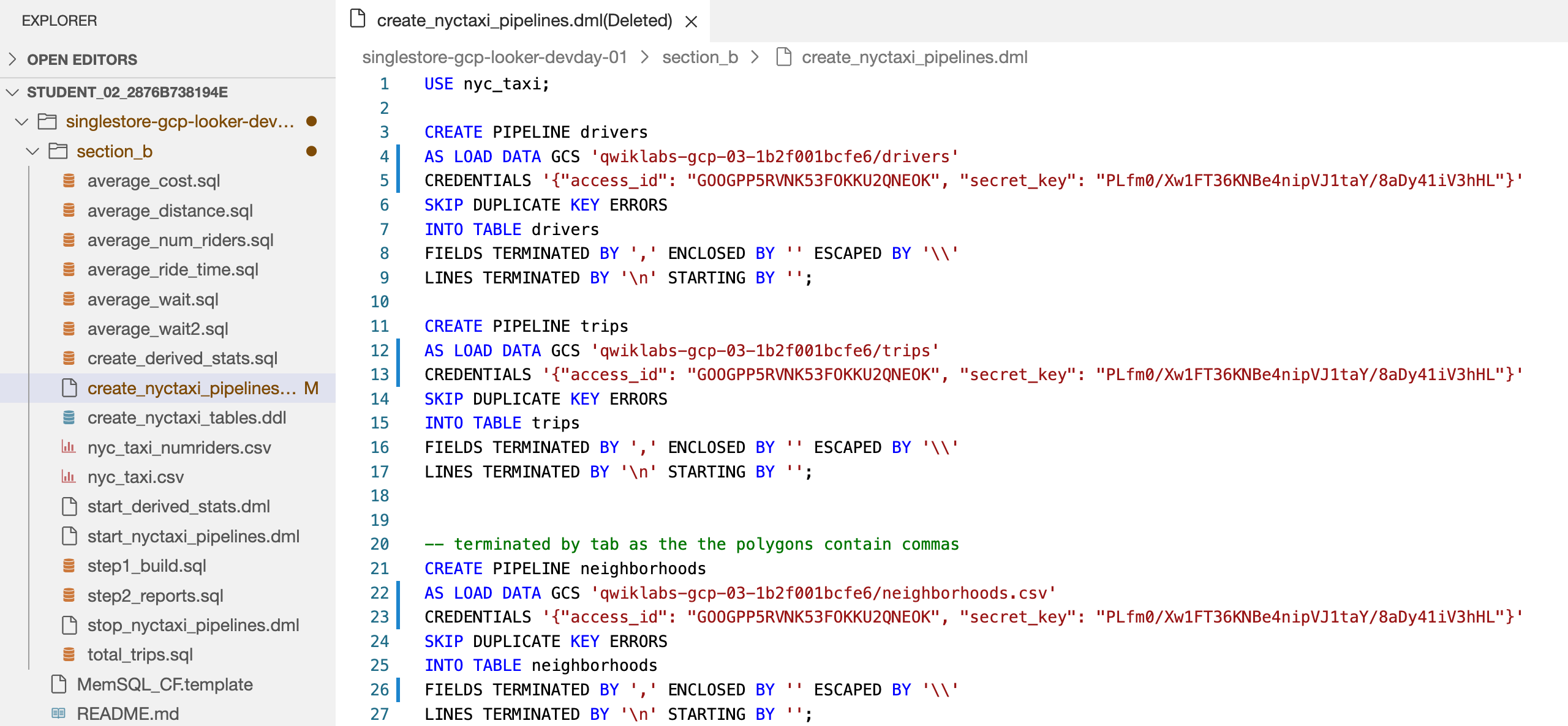

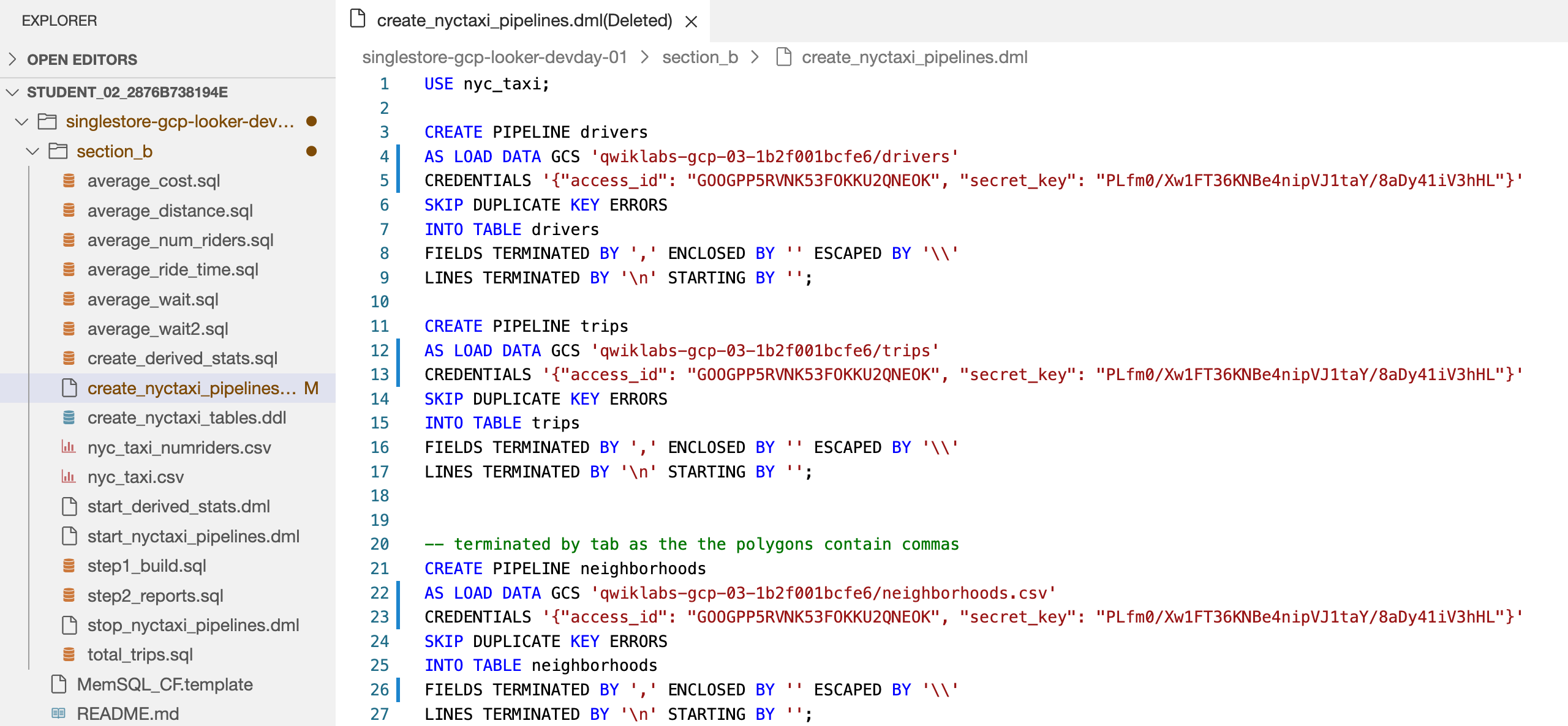

- Ouvrez le fichier singlestore-gcp-looker-devday-01 > section b > create_nyctaxi_pipelines.dml.

Cette action active Gemini Code Assist, comme l'indique l'icône  en haut à droite de l'éditeur.

en haut à droite de l'éditeur.

Utiliser Gemini Code Assist pour en savoir plus sur un fichier de pipeline SingleStore

-

Cliquez sur l'icône Gemini Code Assist : Actions intelligentes  , puis sélectionnez Expliquer.

, puis sélectionnez Expliquer.

-

Gemini Code Assist ouvre un volet de chat avec le prompt prédéfini Explain this (Explique-moi ça). Dans la zone de texte intégrée au volet de discussion Code Assist, remplacez le prompt prérempli par le suivant, puis cliquez sur Envoyer :

Tu es ingénieur de données expert chez Cymbal AI. Un nouveau membre de l'équipe a besoin de se familiariser avec ce code de pipeline SingleStore. Explique en détail le fichier "create_nyctaxi_pipelines.dml" en décrivant ses principaux composants utilisés dans le code.

Ne modifie pas ce fichier avec les suggestions d'amélioration.

L'explication du code du fichier create_nyctaxi_pipelines.dml s'affiche dans le chat Gemini Code Assist.

- Apportez les modifications suivantes au fichier :

- À la ligne 4, remplacez le nom du bucket par le nom de votre propre bucket.

- À la ligne 5, ajoutez l'ID d'accès et la clé secrète que vous venez de créer pour le bucket de stockage.

- À la ligne 12, remplacez le nom du bucket par le nom de votre propre bucket.

- À la ligne 13, ajoutez l'ID d'accès et la clé secrète que vous venez de créer pour le bucket de stockage.

- À la ligne 22, remplacez le nom du bucket par le vôtre et l'extension

.tsv par .csv.

- À la ligne 23, ajoutez l'ID d'accès et la clé secrète que vous venez de créer pour le bucket de stockage.

- À la ligne 26, remplacez

/t par ,.

Votre fichier doit se présenter comme suit :

- Cliquez sur Enregistrer.

-

Revenez au terminal Cloud Shell. Connectez-vous à SingleStore à l'aide de la commande MySQL que vous avez utilisée précédemment. Vous pouvez utiliser la même commande que précédemment pour vous connecter à SingleStore.

-

À l'invite MySQL, exécutez la commande suivante pour créer les pipelines :

source create_nyctaxi_pipelines.dml;

show pipelines;

La sortie doit ressembler à ceci :

Résultat :

| Pipelines_in_nyc_taxi | State | Scheduled |

| --------------------- | ------- | --------- |

| neighborhoods | Stopped | False |

| drivers | Stopped | False |

| trips | Stopped | False |

Tâche 8 : Démarrer les pipelines

- Exécutez les commandes suivantes pour démarrer les pipelines :

source start_nyctaxi_pipelines.dml;

show pipelines;

Résultat :

| Pipelines_in_nyc_taxi | State | Scheduled |

| --------------------- | ------- | --------- |

| neighborhoods | Running | False |

| drivers | Running | False |

| trips | Running | False |

- Pour chacun des trois pipelines, vérifiez que l'état est En cours d'exécution.

Tâche 9 : Exécuter des requêtes d'analyse opérationnelle

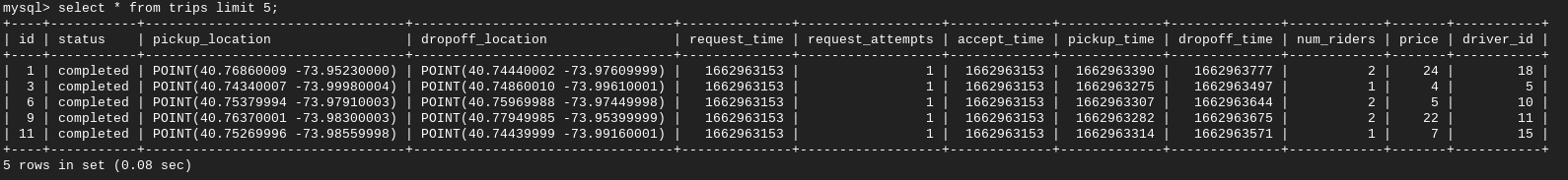

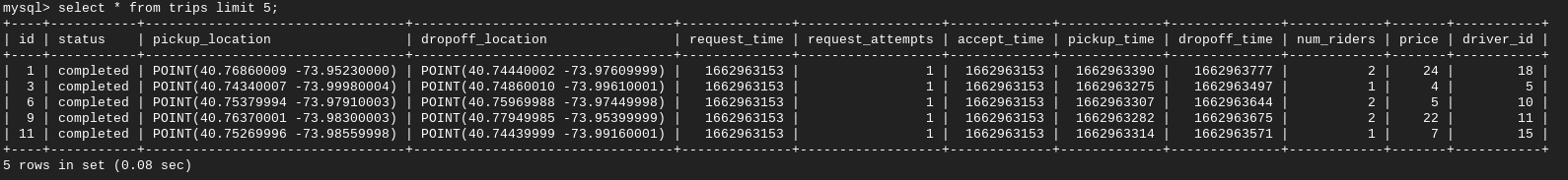

- Exécutez les commandes suivantes pour exécuter les requêtes d'analyse opérationnelle :

select * from trips limit 5;

select * from drivers limit 5;

select * from neighborhoods limit 5;

Rapport n°1 : Nombre total de trajets pour chaque quartier.

- Exécutez ensuite la commande ci-dessous :

source total_trips.sql;

Rapport n°2 : Délai moyen entre une demande de course et sa prise en charge effective.

- Exécutez maintenant la commande suivante :

source average_wait.sql;

Rapport n°3 : Distance moyenne d'un trajet.

- Exécutez la commande suivante :

source average_distance.sql;

Rapport n°4 : Durée moyenne entre la prise en charge et la dépose d'une personne.

- Exécutez la commande suivante :

source average_ride_time.sql;

Rapport n°5 : Coût moyen d'un trajet.

- Exécutez la commande suivante :

source average_cost.sql;

Rapport n°6 : Délai moyen entre l'acceptation d'une course par un chauffeur et la prise en charge effective du passager.

- Exécutez la commande suivante :

source average_wait2.sql;

Rapport n°7 : Nombre moyen de passagers par trajet.

- Enfin, exécutez la commande suivante :

source average_num_riders.sql;

Félicitations !

Félicitations ! Dans cet atelier, vous avez déployé SingleStoreDB et l'avez associé à des produits cloud natifs de Google Cloud tels que Pub/Sub, Dataflow et Cloud Storage. Vous avez également utilisé le pipeline natif de SingleStoreDB pour ingérer des données depuis Cloud Storage et exécuter des requêtes d'analyse opérationnelle.

Pour en savoir plus sur SingleStore, consultez SingleStore.com.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 4 septembre 2025

Dernier test de l'atelier : 04 septembre 2025

Copyright 2025 Google LLC. Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.

) en haut à droite de la console. Si vous y êtes invité, cliquez sur Continuer, puis sur Autoriser.

) en haut à droite de la console. Si vous y êtes invité, cliquez sur Continuer, puis sur Autoriser.

en haut à droite de l'éditeur.

en haut à droite de l'éditeur.