Panoramica

In questo lab imparerai come utilizzare Vertex AI Pipelines per eseguire una semplice pipeline ML derivata dall'SDK Kubeflow Pipeline.

Obiettivi

In questo lab imparerai a:

- Configurare l'ambiente del progetto.

- Ispezionare e configurare il codice della pipeline.

- Eseguire la pipeline di AI.

Configurazione e requisiti

Prima di fare clic sul pulsante Inizia il lab

Nota: leggi le seguenti istruzioni.

I lab sono a tempo e non possono essere messi in pausa. Il timer si avvia quando fai clic su Inizia il lab e ti mostra per quanto tempo avrai a disposizione le risorse Google Cloud.

Con questo lab pratico Qwiklabs avrai la possibilità di completare le attività in prima persona, in un ambiente cloud reale e non di simulazione o demo. Riceverai delle nuove credenziali temporanee che potrai utilizzare per accedere a Google Cloud per la durata del lab.

Cosa serve

Per completare il lab, avrai bisogno di:

- Accesso a un browser internet standard (Chrome è il browser consigliato).

- Tempo a disposizione per completare il lab.

Nota: se hai già un account o un progetto Google Cloud personale, non utilizzarli per questo lab.

Nota: se utilizzi un Pixelbook, apri una finestra di navigazione in incognito per avviare questo lab.

Come avviare il lab e accedere alla console

-

Fai clic sul pulsante Avvia lab. Se devi effettuare il pagamento per il lab, si apre una finestra popup per permetterti di selezionare il metodo di pagamento.

Sul lato sinistro trovi un riquadro con le credenziali temporanee da utilizzare per il lab.

-

Copia il nome utente, quindi fai clic su Apri console Google.

Il lab avvia le risorse e apre un'altra scheda che mostra la pagina Scegli un account.

Nota: apri le schede in finestre separate posizionate fianco a fianco.

-

Nella pagina Scegli un account, fai clic su Utilizza un altro account. Si apre la pagina di accesso.

-

Qui incolla il nome utente che hai copiato dal riquadro Dettagli connessione, quindi copia e incolla la password.

Nota: devi utilizzare le credenziali presenti nel riquadro Dettagli connessione. Non utilizzare le tue credenziali Google Cloud Skills Boost. Se hai un account Google Cloud, non usarlo per questo lab per evitare che ti vengano addebitati dei costi.

- Fai clic nelle pagine successive:

- Accetta i termini e le condizioni.

- Non inserire opzioni di recupero o l'autenticazione a due fattori, perché si tratta di un account temporaneo.

- Non registrarti per le prove gratuite.

Dopo qualche istante, la console Cloud si apre in questa scheda.

Nota: puoi visualizzare il menu con un elenco di prodotti e servizi Google Cloud facendo clic sul menu di navigazione in alto a sinistra.

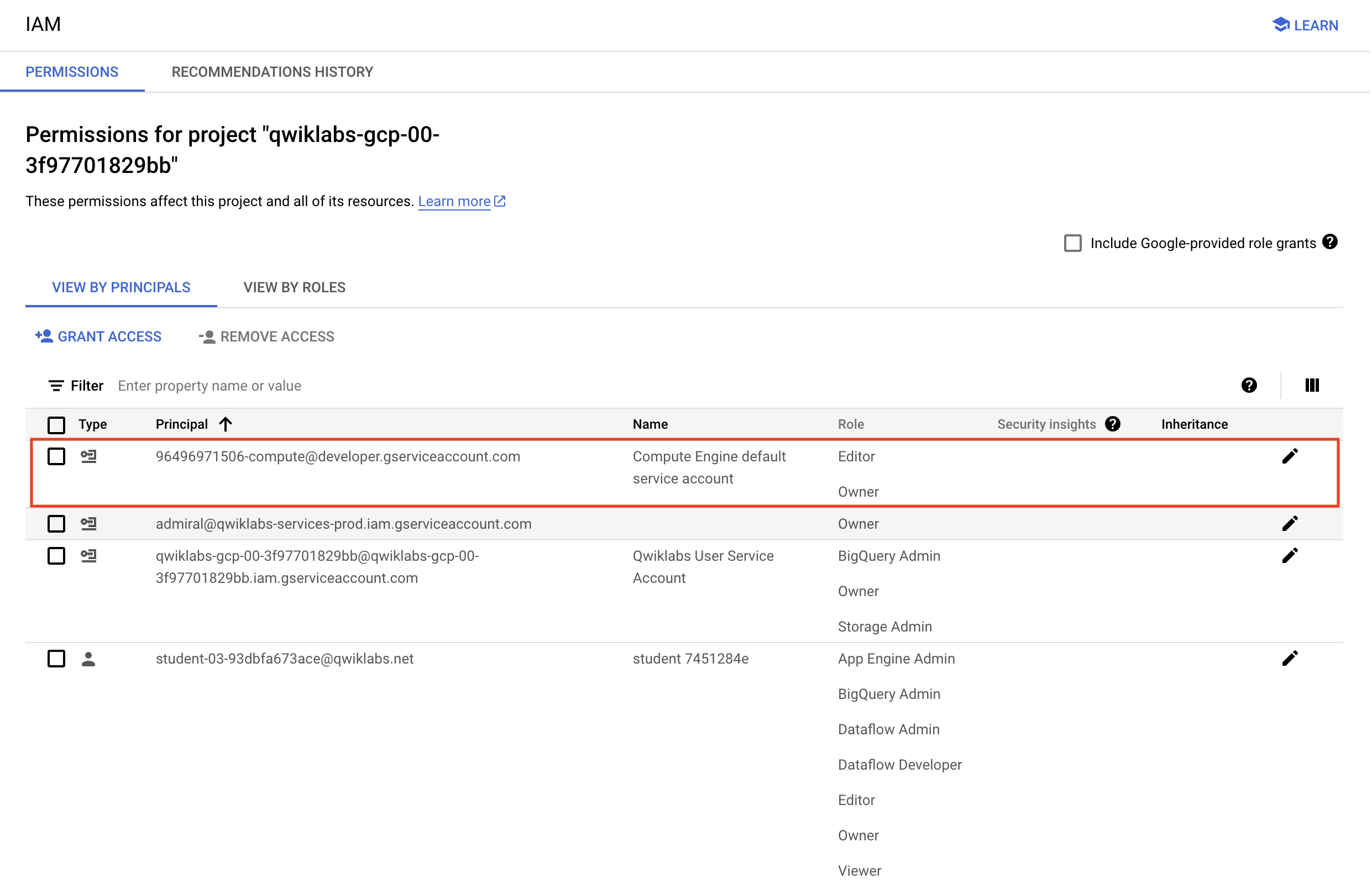

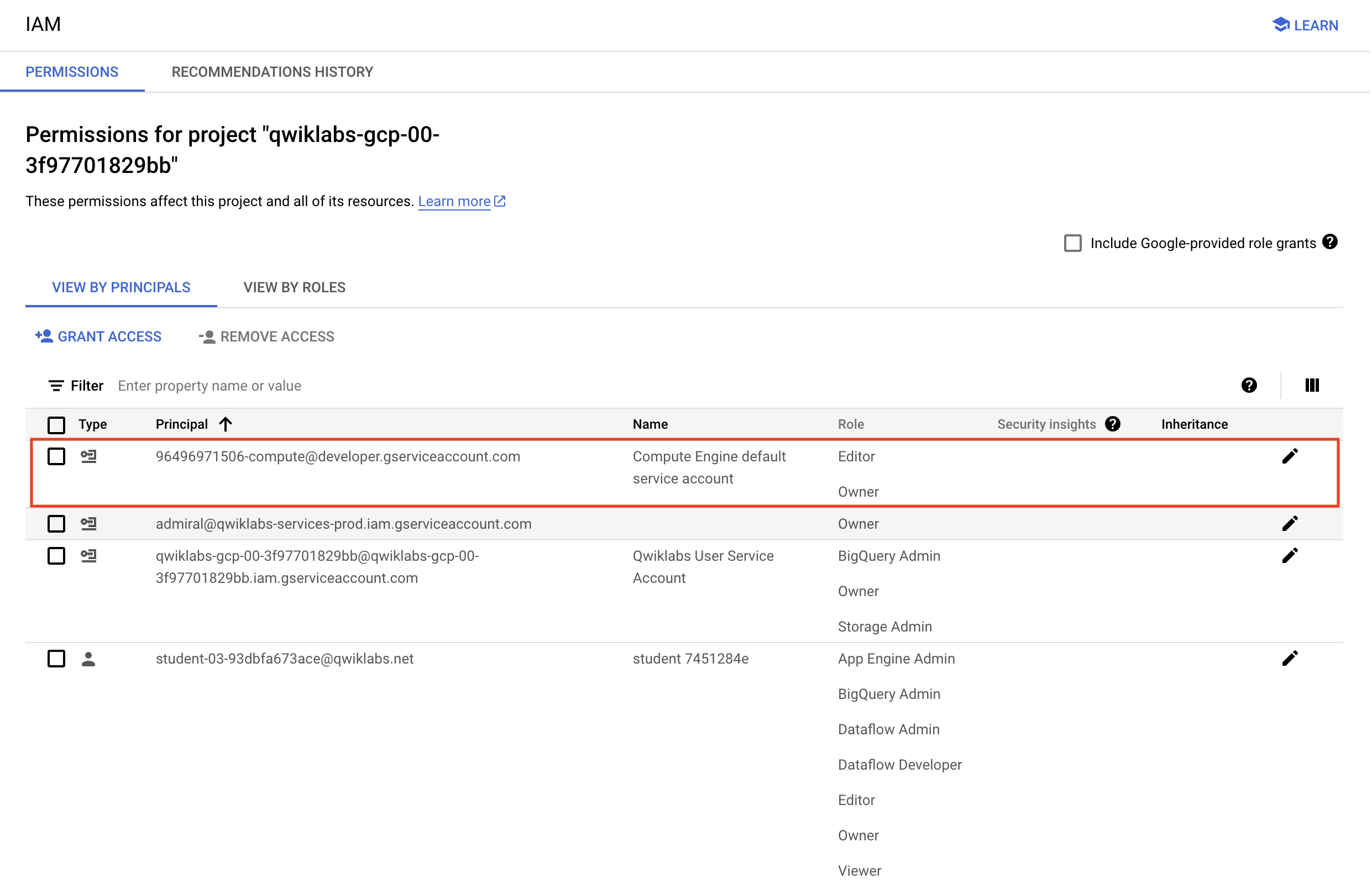

Verifica le autorizzazioni del progetto

Prima di iniziare il tuo lavoro su Google Cloud, devi assicurarti che il tuo progetto disponga delle autorizzazioni corrette in Identity and Access Management (IAM).

-

Nella console Google Cloud, nel menu di navigazione ( ), seleziona IAM e amministrazione > IAM.

), seleziona IAM e amministrazione > IAM.

-

Conferma che l'account di servizio di computing predefinito {project-number}-compute@developer.gserviceaccount.com sia presente e che abbia il ruolo di editor assegnato. Il prefisso dell'account è il numero del progetto, che puoi trovare in Menu di navigazione > Panoramica di Cloud > Dashboard

Nota: se l'account non è presente in IAM o non dispone del ruolo editor, attieniti alla procedura riportata di seguito per assegnare il ruolo richiesto.

- Nel menu di navigazione della console Google Cloud, fai clic su Panoramica di Cloud > Dashboard.

- Copia il numero del progetto (es.

729328892908).

- Nel menu di navigazione, seleziona IAM e amministrazione > IAM.

- Nella parte superiore della tabella dei ruoli, sotto Visualizza per entità, fai clic su Concedi accesso.

- Per Nuove entità, digita:

{project-number}-compute@developer.gserviceaccount.com

- Sostituisci

{project-number} con il numero del tuo progetto.

- Come Ruolo, seleziona Progetto (o Base) > Editor.

- Fai clic su Salva.

Attività 1: configura l'ambiente del progetto

Vertex AI Pipelines viene eseguito in un framework serverless in cui il deployment delle pipeline precompilate viene eseguito on demand o in base a una pianificazione. Per facilitare l'esecuzione senza problemi è necessario configurare l'ambiente.

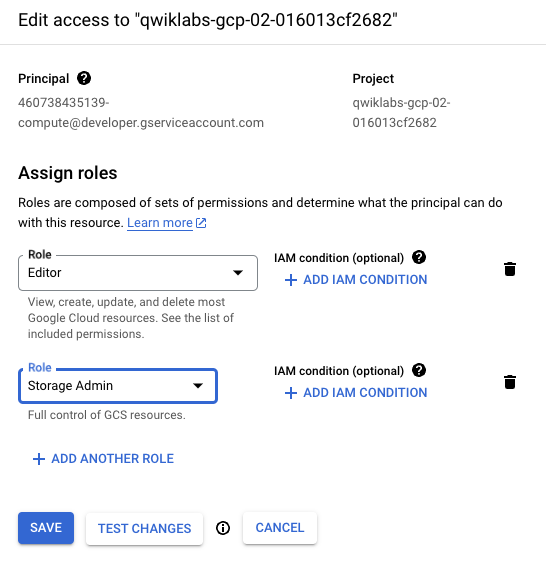

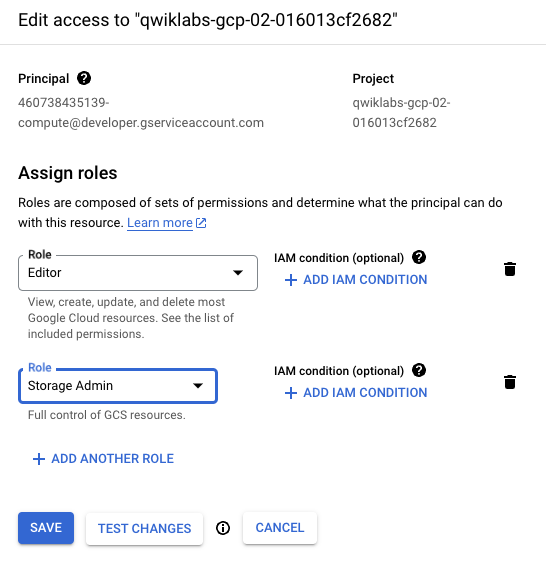

Per la corretta esecuzione del codice della pipeline in un ambiente Qwiklabs, l'account di servizio di computing necessita di privilegi elevati su Cloud Storage.

-

Nella console Google Cloud, nel menu di navigazione ( ), fai clic su IAM e amministrazione > IAM.

), fai clic su IAM e amministrazione > IAM.

-

Fai clic sull'icona a forma di matita per l'account del servizio di computing predefinito {project-number}-compute@developer.gserviceaccount.com per assegnare il ruolo Storage Admin.

-

Nella finestra a scorrimento, fai clic su Aggiungi un altro ruolo. Digita Storage Admin nella casella di ricerca. Seleziona Storage Admin con Concede il controllo completo dei bucket e degli oggetti dall'elenco dei risultati.

-

Fai clic su Salva per assegnare il ruolo all'account di servizio di computing.

Sarà possibile accedere agli artefatti durante l'importazione e l'esportazione quando viene eseguita la pipeline.

- Esegui questo blocco di codice in Cloud Shell per creare un bucket nel tuo progetto e due cartelle, ciascuna con un file vuoto:

gcloud storage buckets create gs://{{{primary_project.project_id|Project ID}}}

touch emptyfile1

touch emptyfile2

gcloud storage cp emptyfile1 gs://{{{primary_project.project_id|Project ID}}}/pipeline-output/emptyfile1

gcloud storage cp emptyfile2 gs://{{{primary_project.project_id|Project ID}}}/pipeline-input/emptyfile2

La pipeline è già stata creata per te e richiede semplicemente alcune piccole modifiche per consentirne l'esecuzione nel tuo progetto Qwiklabs.

- Scarica la pipeline di IA dalla cartella delle risorse del lab:

wget https://storage.googleapis.com/cloud-training/dataengineering/lab_assets/ai_pipelines/basic_pipeline.json

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Configura l'ambiente

Attività 2: configura e ispeziona il codice della pipeline

Il codice della pipeline è una raccolta di due operazioni AI scritte in Python. L'esempio è molto semplice ma dimostra quanto sia facile orchestrare procedure ML scritte in vari linguaggi (TensorFlow, Python, Java ecc.) in una pipeline di IA di semplice deployment. L'esempio di lab esegue due operazioni, concatenazione e inversione, su due valori stringa.

- Per prima cosa devi apportare una modifica per aggiornare la cartella di output per l'esecuzione di pipeline di AI. In Cloud Shell utilizza il comando Linux Stream EDitor (sed) per modificare questa impostazione:

sed -i 's/PROJECT_ID/{{{primary_project.project_id|Project ID}}}/g' basic_pipeline.json

- Controlla basic_pipeline.json per confermare che la cartella di output è impostata sul tuo progetto:

tail -20 basic_pipeline.json

Le sezioni chiave del codice in basic_pipeline.json sono i blocchi deploymentSpec e command. Di seguito è riportato il primo blocco command, il job che concatena le stringhe di input. Questo è il codice Kubeflow Pipeline SDK (kfp) progettato per essere eseguito dal motore Python 3.7. Non modificherai alcun codice, la sezione è mostrata qui come riferimento:

"program_path=$(mktemp -d)\nprintf \"%s\" \"$0\" > \"$program_path/ephemeral_component.py\"\npython3 -m kfp.v2.components.executor_main --component_module_path \"$program_path/ephemeral_component.py\" \"$@\"\n",

"\nimport kfp\nfrom kfp.v2 import dsl\nfrom kfp.v2.dsl import *\nfrom typing import *\n\ndef concat(a: str, b: str) -> str:\n return a + b\n\n"

],

"image": "python:3.7"

- Puoi esplorare l'intero file utilizzando il comando seguente:

more basic_pipeline.json

Nota: premi la barra spaziatrice per avanzare nel file fino alla fine. Se desideri chiudere il file in anticipo, digita q per chiudere il comando more.

- Successivamente, sposta il file basic_pipeline.json aggiornato nel bucket Cloud Storage creato in precedenza in modo che sia possibile accedervi per eseguire un job della pipeline di IA:

gcloud storage cp basic_pipeline.json gs://{{{primary_project.project_id|Project ID}}}/pipeline-input/basic_pipeline.json

Fai clic su Controlla i miei progressi per verificare l'obiettivo.

Esegui il deployment della pipeline

Attività 3: esegui la pipeline di AI

-

Dalla console, apri il menu di navigazione ( ), nella sezione Intelligenza artificiale fai clic su Vertex AI.

), nella sezione Intelligenza artificiale fai clic su Vertex AI.

-

Fai clic su Abilita tutte le API consigliate, in blu.

-

Una volta abilitata l'API, fai clic su Pipeline nel menu a sinistra.

-

Fai clic su Crea esecuzione nel menu in alto.

-

Dai dettagli dell'esecuzione, seleziona Importa da Cloud Storage e per URL di Cloud Storage vai alla cartella pipeline-input che hai creato all'interno del bucket Cloud Storage del tuo progetto. Seleziona il file basic_pipeline.json.

-

Fai clic su Seleziona.

-

In corrispondenza di Regione, seleziona .

-

Lascia invariati i restanti valori predefiniti e fai clic su Continua.

Puoi lasciare invariati i valori predefiniti per Configurazione di runtime. Tieni presente che la directory di output di Cloud Storage è impostata sulla cartella del bucket creata in un passaggio precedente. I parametri della pipeline sono precompilati con i valori del file basic_pipeline.json ma hai la possibilità di modificarli in fase di runtime tramite questa procedura guidata.

-

Fai clic su Invia per avviare l'esecuzione della pipeline.

-

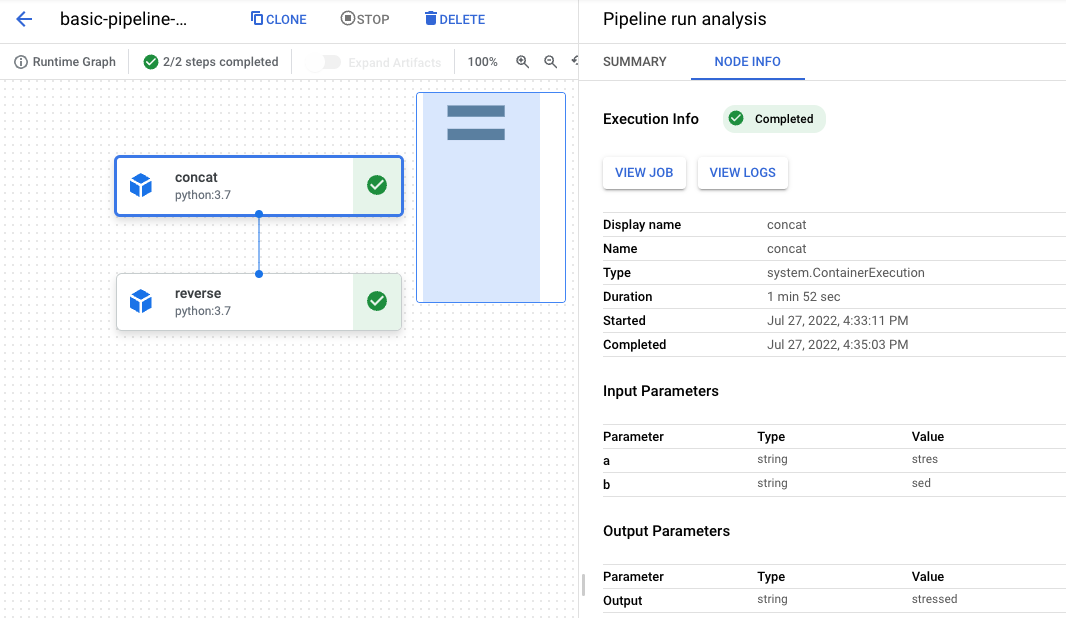

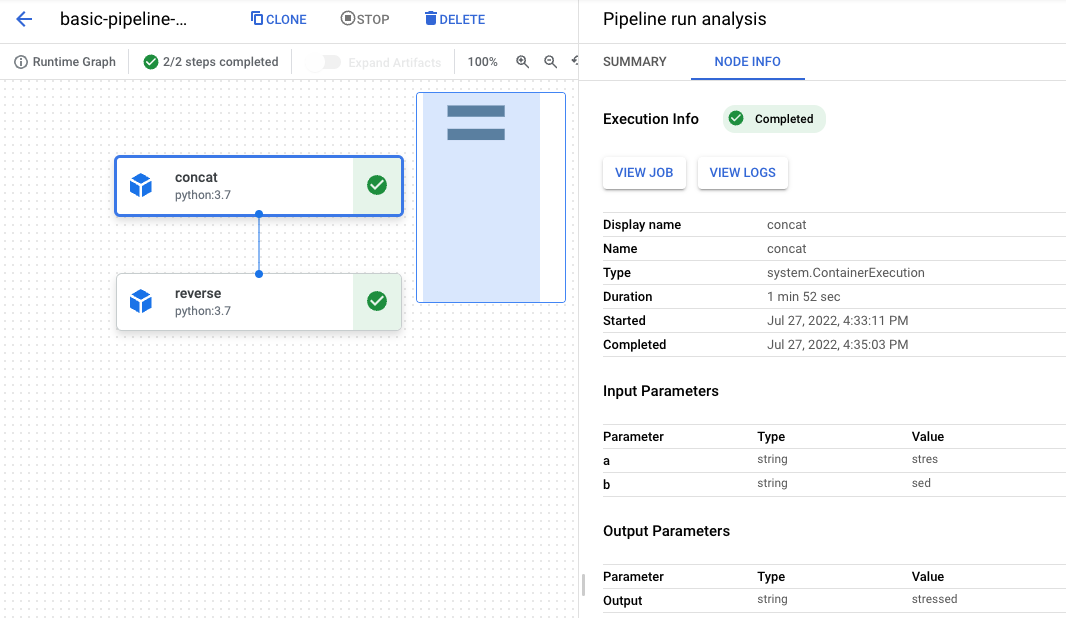

Tornerai alla dashboard Pipeline e la tua esecuzione passerà da In sospeso a In esecuzione a Riuscito. L'intera esecuzione durerà dai 3 ai 6 minuti.

-

Una volta che lo stato raggiunge Riuscito, fai clic sul nome della corsa per visualizzare il grafico e i dettagli dell'esecuzione.

-

Esiste un elemento grafico per ogni passaggio. Fai clic sull'oggetto concat per vedere i dettagli del job.

-

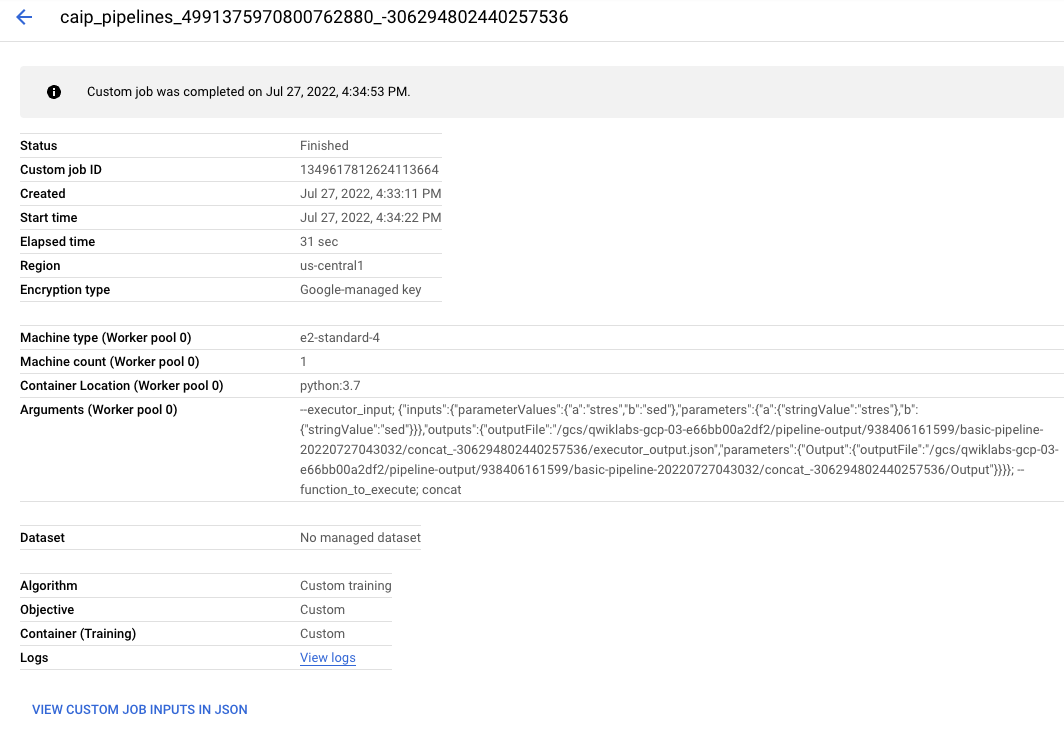

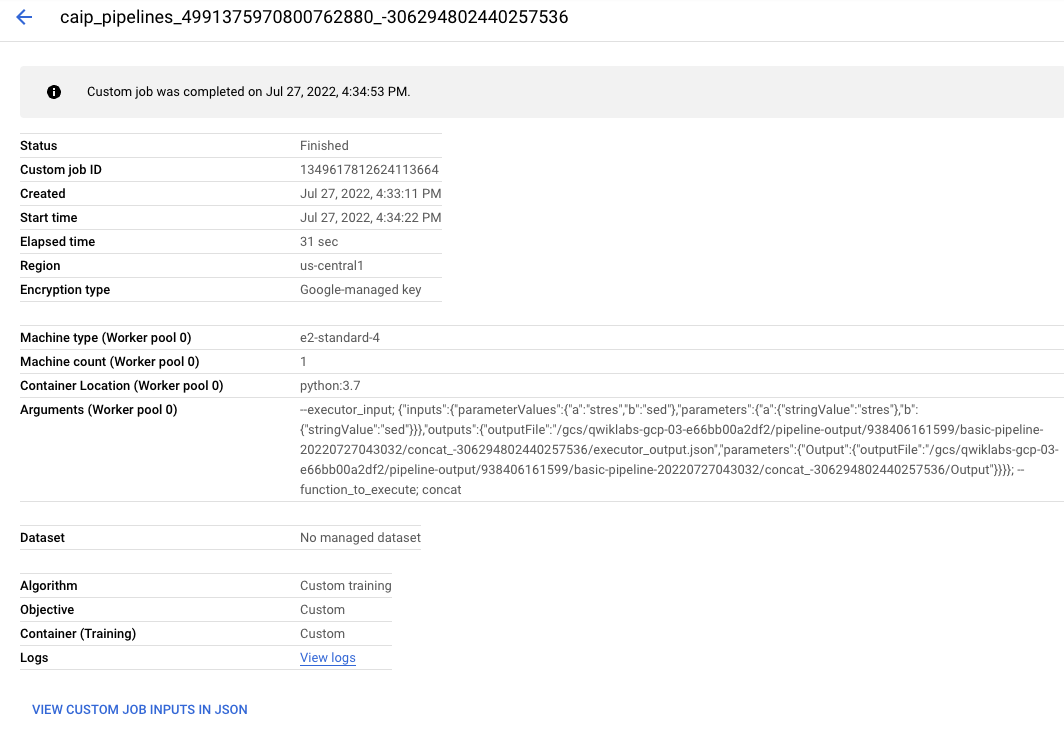

Fai clic sul pulsante Visualizza job. Si aprirà una nuova scheda con il job personalizzato Vertex AI inviato al backend per soddisfare la richiesta della pipeline.

Se vuoi, puoi esaminare maggiori dettagli sull'esecuzione della pipeline.

Complimenti!

Hai utilizzato con successo Vertex AI Pipelines per eseguire una semplice pipeline ML derivata dall'SDK Kubeflow Pipeline.

Ultimo aggiornamento del manuale: 26 aprile 2024

Ultimo test del lab: 26 aprile 2024

Copyright 2020 Google LLC Tutti i diritti riservati. Google e il logo Google sono marchi di Google LLC. Tutti gli altri nomi di società e prodotti sono marchi delle rispettive società a cui sono associati.

), seleziona IAM e amministrazione > IAM.

), seleziona IAM e amministrazione > IAM.