GSP903

개요

Google Cloud Pub/Sub는 애플리케이션 및 서비스 간에 이벤트 데이터를 교환하는 데 사용되는 메시지 서비스입니다. 데이터 제작자는 Cloud Pub/Sub 주제에 메시지를 게시하고 소비자는 해당 주제에 관한 구독을 만듭니다. 구독자는 구독에서 메시지를 가져오거나 푸시(push) 구독을 위한 웹훅을 구성합니다. 구성에서 설정 가능한 기간 안에 모든 구독자가 각 메시지를 확인해야 합니다.

Dataflow는 신뢰성과 표현 능력은 그대로 유지하면서 스트림(실시간) 및 일괄 모드에서 데이터를 변환하고 강화하는 완전 관리형 서비스입니다. 소스 및 싱크 커넥터의 생태계는 물론 다양한 기간 설정과 세션 분석 기본 도구를 제공하는 Apache Beam SDK를 사용하여 간소화된 파이프라인 개발 환경을 제공합니다.

Pub/Sub는 확장 가능하고 내구성 있는 이벤트 수집 및 전달 시스템입니다. Dataflow는 Pub/Sub의 확장 가능한 최소 1회 전달 모델을 메시지 중복 삭제 기능과 단 한 번에 순서대로 처리하는 기능(기간과 버퍼링을 사용하는 경우)으로 보완합니다.

실습할 내용

- Pub/Sub 주제에 게시된 메시지 읽기

- 타임스탬프로 메시지 기간 설정 또는 그룹화

- Cloud Storage에 메시지 쓰기

설정

실습 시작 버튼을 클릭하기 전에

다음 안내를 확인하세요. 실습에는 시간 제한이 있으며 일시중지할 수 없습니다. 실습 시작을 클릭하면 타이머가 시작됩니다. 이 타이머는 Google Cloud 리소스를 사용할 수 있는 시간이 얼마나 남았는지를 표시합니다.

실무형 실습을 통해 시뮬레이션이나 데모 환경이 아닌 실제 클라우드 환경에서 실습 활동을 진행할 수 있습니다. 실습 시간 동안 Google Cloud에 로그인하고 액세스하는 데 사용할 수 있는 새로운 임시 사용자 인증 정보가 제공됩니다.

이 실습을 완료하려면 다음을 준비해야 합니다.

- 표준 인터넷 브라우저 액세스 권한(Chrome 브라우저 권장)

참고: 이 실습을 실행하려면 시크릿 모드(권장) 또는 시크릿 브라우저 창을 사용하세요. 개인 계정과 학습자 계정 간의 충돌로 개인 계정에 추가 요금이 발생하는 일을 방지해 줍니다.

- 실습을 완료하기에 충분한 시간(실습을 시작하고 나면 일시중지할 수 없음)

참고: 이 실습에는 학습자 계정만 사용하세요. 다른 Google Cloud 계정을 사용하는 경우 해당 계정에 비용이 청구될 수 있습니다.

실습을 시작하고 Google Cloud 콘솔에 로그인하는 방법

-

실습 시작 버튼을 클릭합니다. 실습 비용을 결제해야 하는 경우 결제 수단을 선택할 수 있는 대화상자가 열립니다.

왼쪽에는 다음과 같은 항목이 포함된 실습 세부정보 창이 있습니다.

- Google Cloud 콘솔 열기 버튼

- 남은 시간

- 이 실습에 사용해야 하는 임시 사용자 인증 정보

- 필요한 경우 실습 진행을 위한 기타 정보

-

Google Cloud 콘솔 열기를 클릭합니다(Chrome 브라우저를 실행 중인 경우 마우스 오른쪽 버튼으로 클릭하고 시크릿 창에서 링크 열기를 선택합니다).

실습에서 리소스가 가동되면 다른 탭이 열리고 로그인 페이지가 표시됩니다.

팁: 두 개의 탭을 각각 별도의 창으로 나란히 정렬하세요.

참고: 계정 선택 대화상자가 표시되면 다른 계정 사용을 클릭합니다.

-

필요한 경우 아래의 사용자 이름을 복사하여 로그인 대화상자에 붙여넣습니다.

{{{user_0.username | "Username"}}}

실습 세부정보 창에서도 사용자 이름을 확인할 수 있습니다.

-

다음을 클릭합니다.

-

아래의 비밀번호를 복사하여 시작하기 대화상자에 붙여넣습니다.

{{{user_0.password | "Password"}}}

실습 세부정보 창에서도 비밀번호를 확인할 수 있습니다.

-

다음을 클릭합니다.

중요: 실습에서 제공하는 사용자 인증 정보를 사용해야 합니다. Google Cloud 계정 사용자 인증 정보를 사용하지 마세요.

참고: 이 실습에 자신의 Google Cloud 계정을 사용하면 추가 요금이 발생할 수 있습니다.

-

이후에 표시되는 페이지를 클릭하여 넘깁니다.

- 이용약관에 동의합니다.

- 임시 계정이므로 복구 옵션이나 2단계 인증을 추가하지 않습니다.

- 무료 체험판을 신청하지 않습니다.

잠시 후 Google Cloud 콘솔이 이 탭에서 열립니다.

참고: Google Cloud 제품 및 서비스에 액세스하려면 탐색 메뉴를 클릭하거나 검색창에 제품 또는 서비스 이름을 입력합니다.

Cloud Shell 활성화

Cloud Shell은 다양한 개발 도구가 탑재된 가상 머신으로, 5GB의 영구 홈 디렉터리를 제공하며 Google Cloud에서 실행됩니다. Cloud Shell을 사용하면 명령줄을 통해 Google Cloud 리소스에 액세스할 수 있습니다.

-

Google Cloud 콘솔 상단에서 Cloud Shell 활성화  를 클릭합니다.

를 클릭합니다.

-

다음 창을 클릭합니다.

- Cloud Shell 정보 창을 통해 계속 진행합니다.

- 사용자 인증 정보를 사용하여 Google Cloud API를 호출할 수 있도록 Cloud Shell을 승인합니다.

연결되면 사용자 인증이 이미 처리된 것이며 프로젝트가 학습자의 PROJECT_ID, (으)로 설정됩니다. 출력에 이 세션의 PROJECT_ID를 선언하는 줄이 포함됩니다.

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

gcloud는 Google Cloud의 명령줄 도구입니다. Cloud Shell에 사전 설치되어 있으며 명령줄 자동 완성을 지원합니다.

- (선택사항) 다음 명령어를 사용하여 활성 계정 이름 목록을 표시할 수 있습니다.

gcloud auth list

-

승인을 클릭합니다.

출력:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (선택사항) 다음 명령어를 사용하여 프로젝트 ID 목록을 표시할 수 있습니다.

gcloud config list project

출력:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

참고: gcloud 전체 문서는 Google Cloud에서 gcloud CLI 개요 가이드를 참고하세요.

리전 설정

- Cloud Shell에서 다음 명령어를 실행하여 이 실습을 위한 프로젝트 리전을 설정합니다.

gcloud config set compute/region {{{project_0.default_region | "REGION"}}}

Dataflow API가 사용 설정되어 있는지 확인

필요한 API에 액세스할 수 있도록 Dataflow API에 대한 연결을 다시 시작합니다.

gcloud services disable dataflow.googleapis.com --project {{{project_0.project_id|Project ID}}} --force

gcloud services enable dataflow.googleapis.com --project {{{project_0.project_id|Project ID}}}

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

Dataflow API를 사용 중지한 후 다시 사용 설정

작업 1. 프로젝트 리소스 만들기

- Cloud Shell에서 버킷, 프로젝트, 리전의 변수를 만듭니다.

PROJECT_ID=$(gcloud config get-value project)

BUCKET_NAME="${PROJECT_ID}-bucket"

TOPIC_ID=my-id

REGION={{{project_0.default_region | "filled in at lab start"}}}

- App Engine 리전을 설정합니다.

참고: us-central1 및 europe-west1 이외 리전의 경우 App Engine 리전 변수를 할당된 리전과 동일하게 설정합니다. us-central1이 할당된 경우 App Engine 리전 변수를 us-central로 설정합니다. europe-west1이 할당된 경우 App Engine 리전 변수를 europe-west로 설정합니다.

자세한 내용은 App Engine 위치를 참조하세요.

AE_REGION={{{project_0.startup_script.app_region|region_to_be_set}}}

- 이 프로젝트가 소유한 Cloud Storage 버킷을 만듭니다.

gsutil mb gs://$BUCKET_NAME

참고: Cloud Storage 버킷 이름은 전역적으로 고유해야 합니다. Qwiklabs 프로젝트 ID는 항상 고유하므로 이 실습에서는 프로젝트 ID를 버킷 이름으로 사용합니다.

- 이 프로젝트에서 Pub/Sub 주제를 만듭니다.

gcloud pubsub topics create $TOPIC_ID

- 프로젝트의 App Engine 앱을 만듭니다.

gcloud app create --region=$AE_REGION

- 이 프로젝트에서 Cloud Scheduler 작업을 만듭니다. 작업은 1분 간격으로 Cloud Pub/Sub 주제에 메시지를 게시합니다.

gcloud scheduler jobs create pubsub publisher-job --schedule="* * * * *" \

--topic=$TOPIC_ID --message-body="Hello!"

- Cloud Scheduler API를 사용 설정하라는 메시지가 표시되면

y를 누르고 Enter 키를 누릅니다.

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

프로젝트 리소스 만들기

- 작업을 시작합니다.

gcloud scheduler jobs run publisher-job

참고: RESOURCE_EXHAUSTED 오류가 발생하면 명령어를 다시 실행해 보세요.

- 다음 명령어를 사용하여 빠른 시작 저장소를 클론하고 샘플 코드 디렉터리로 이동합니다.

git clone https://github.com/GoogleCloudPlatform/java-docs-samples.git

cd java-docs-samples/pubsub/streaming-analytics

docker run -it -e DEVSHELL_PROJECT_ID=$DEVSHELL_PROJECT_ID python:3.7 /bin/bash

git clone https://github.com/GoogleCloudPlatform/python-docs-samples.git

cd python-docs-samples/pubsub/streaming-analytics

pip install -U -r requirements.txt # Install Apache Beam dependencies

참고: Python 옵션을 사용하는 경우 Python 명령어를 개별적으로 실행합니다.

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

Cloud Scheduler 작업 시작

작업 2. Pub/Sub에서 Cloud Storage로 메시지를 스트리밍하는 코드 검토

코드 샘플

Dataflow를 사용하여 다음을 수행하는 샘플 코드를 검토합니다.

- Pub/Sub 메시지를 읽습니다.

- 게시 타임스탬프를 기준으로 메시지를 고정 크기 간격으로 기간 설정 또는 그룹화합니다.

- 각 창의 메시지를 Cloud Storage의 파일에 작성합니다.

import java.io.IOException;

import org.apache.beam.examples.common.WriteOneFilePerWindow;

import org.apache.beam.sdk.Pipeline;

import org.apache.beam.sdk.io.gcp.pubsub.PubsubIO;

import org.apache.beam.sdk.options.Default;

import org.apache.beam.sdk.options.Description;

import org.apache.beam.sdk.options.PipelineOptionsFactory;

import org.apache.beam.sdk.options.StreamingOptions;

import org.apache.beam.sdk.options.Validation.Required;

import org.apache.beam.sdk.transforms.windowing.FixedWindows;

import org.apache.beam.sdk.transforms.windowing.Window;

import org.joda.time.Duration;

public class PubSubToGcs {

/*

* Define your own configuration options. Add your own arguments to be processed

* by the command-line parser, and specify default values for them.

*/

public interface PubSubToGcsOptions extends StreamingOptions {

@Description("The Cloud Pub/Sub topic to read from.")

@Required

String getInputTopic();

void setInputTopic(String value);

@Description("Output file's window size in number of minutes.")

@Default.Integer(1)

Integer getWindowSize();

void setWindowSize(Integer value);

@Description("Path of the output file including its filename prefix.")

@Required

String getOutput();

void setOutput(String value);

}

public static void main(String[] args) throws IOException {

// The maximum number of shards when writing output.

int numShards = 1;

PubSubToGcsOptions options =

PipelineOptionsFactory.fromArgs(args).withValidation().as(PubSubToGcsOptions.class);

options.setStreaming(true);

Pipeline pipeline = Pipeline.create(options);

pipeline

// 1) Read string messages from a Pub/Sub topic.

.apply("Read PubSub Messages", PubsubIO.readStrings().fromTopic(options.getInputTopic()))

// 2) Group the messages into fixed-sized minute intervals.

.apply(Window.into(FixedWindows.of(Duration.standardMinutes(options.getWindowSize()))))

// 3) Write one file to GCS for every window of messages.

.apply("Write Files to GCS", new WriteOneFilePerWindow(options.getOutput(), numShards));

// Execute the pipeline and wait until it finishes running.

pipeline.run().waitUntilFinish();

}

}

import argparse

from datetime import datetime

import logging

import random

from apache_beam import (

DoFn,

GroupByKey,

io,

ParDo,

Pipeline,

PTransform,

WindowInto,

WithKeys,

)

from apache_beam.options.pipeline_options import PipelineOptions

from apache_beam.transforms.window import FixedWindows

class GroupMessagesByFixedWindows(PTransform):

"""A composite transform that groups Pub/Sub messages based on publish time

and outputs a list of tuples, each containing a message and its publish time.

"""

def __init__(self, window_size, num_shards=5):

# Set window size to 60 seconds.

self.window_size = int(window_size * 60)

self.num_shards = num_shards

def expand(self, pcoll):

return (

pcoll

# Bind window info to each element using element timestamp (or publish time).

| "Window into fixed intervals"

>> WindowInto(FixedWindows(self.window_size))

| "Add timestamp to windowed elements" >> ParDo(AddTimestamp())

# Assign a random key to each windowed element based on the number of shards.

| "Add key" >> WithKeys(lambda _: random.randint(0, self.num_shards - 1))

# Group windowed elements by key. All the elements in the same window must fit

# memory for this. If not, you need to use `beam.util.BatchElements`.

| "Group by key" >> GroupByKey()

)

class AddTimestamp(DoFn):

def process(self, element, publish_time=DoFn.TimestampParam):

"""Processes each windowed element by extracting the message body and its

publish time into a tuple.

"""

yield (

element.decode("utf-8"),

datetime.utcfromtimestamp(float(publish_time)).strftime(

"%Y-%m-%d %H:%M:%S.%f"

),

)

class WriteToGCS(DoFn):

def __init__(self, output_path):

self.output_path = output_path

def process(self, key_value, window=DoFn.WindowParam):

"""Write messages in a batch to Google Cloud Storage."""

ts_format = "%H:%M"

window_start = window.start.to_utc_datetime().strftime(ts_format)

window_end = window.end.to_utc_datetime().strftime(ts_format)

shard_id, batch = key_value

filename = "-".join([self.output_path, window_start, window_end, str(shard_id)])

with io.gcsio.GcsIO().open(filename=filename, mode="w") as f:

for message_body, publish_time in batch:

f.write(f"{message_body},{publish_time}\n".encode())

def run(input_topic, output_path, window_size=1.0, num_shards=5, pipeline_args=None):

# Set `save_main_session` to True so DoFns can access globally imported modules.

pipeline_options = PipelineOptions(

pipeline_args, streaming=True, save_main_session=True

)

with Pipeline(options=pipeline_options) as pipeline:

(

pipeline

# Because `timestamp_attribute` is unspecified in `ReadFromPubSub`, Beam

# binds the publish time returned by the Pub/Sub server for each message

# to the element's timestamp parameter, accessible via `DoFn.TimestampParam`.

# https://beam.apache.org/releases/pydoc/current/apache_beam.io.gcp.pubsub.html#apache_beam.io.gcp.pubsub.ReadFromPubSub

| "Read from Pub/Sub" >> io.ReadFromPubSub(topic=input_topic)

| "Window into" >> GroupMessagesByFixedWindows(window_size, num_shards)

| "Write to GCS" >> ParDo(WriteToGCS(output_path))

)

if __name__ == "__main__":

logging.getLogger().setLevel(logging.INFO)

parser = argparse.ArgumentParser()

parser.add_argument(

"--input_topic",

help="The Cloud Pub/Sub topic to read from."

'"projects//topics/".',

)

parser.add_argument(

"--window_size",

type=float,

default=1.0,

help="Output file's window size in minutes.",

)

parser.add_argument(

"--output_path",

help="Path of the output GCS file including the prefix.",

)

parser.add_argument(

"--num_shards",

type=int,

default=5,

help="Number of shards to use when writing windowed elements to GCS.",

)

known_args, pipeline_args = parser.parse_known_args()

run(

known_args.input_topic,

known_args.output_path,

known_args.window_size,

known_args.num_shards,

pipeline_args,

)

참고: 샘플 코드를 자세히 살펴보려면 각각의 java-docs-samples 및 python-docs-samples GitHub 페이지를 방문하세요.

작업 3. 파이프라인 시작

- 파이프라인을 시작하려면 다음 명령어를 실행합니다.

mvn compile exec:java \

-Dexec.mainClass=com.examples.pubsub.streaming.PubSubToGcs \

-Dexec.cleanupDaemonThreads=false \

-Dexec.args=" \

--project=$PROJECT_ID \

--region=$REGION \

--inputTopic=projects/$PROJECT_ID/topics/$TOPIC_ID \

--output=gs://$BUCKET_NAME/samples/output \

--runner=DataflowRunner \

--windowSize=2 \

--tempLocation=gs://$BUCKET_NAME/temp"

python PubSubToGCS.py \

--project=project_id \

--region=region \

--input_topic=projects/project_id/topics/my-id \

--output_path=gs://bucket_name/samples/output \

--runner=DataflowRunner \

--window_size=2 \

--num_shards=2 \

--temp_location=gs://bucket_name/temp

참고: Python 명령어를 실행할 때 project_id, bucket_name, region을 프로젝트 ID, 버킷 이름, 할당된 실습 리전으로 바꿉니다.

위 명령어는 로컬에서 실행되고, 클라우드에서 실행되는 Dataflow 작업을 시작합니다.

참고: 코드가 완전히 실행되고 다음 작업에서 파이프라인 작업이 Dataflow 콘솔에 표시되려면 10분 정도 기다려야 할 수 있습니다.

참고: StaticLoggerBinder와 관련된 경고가 표시되면 무시하고 실습을 계속 진행하세요.

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

파이프라인을 시작하고 Dataflow 작업 실행

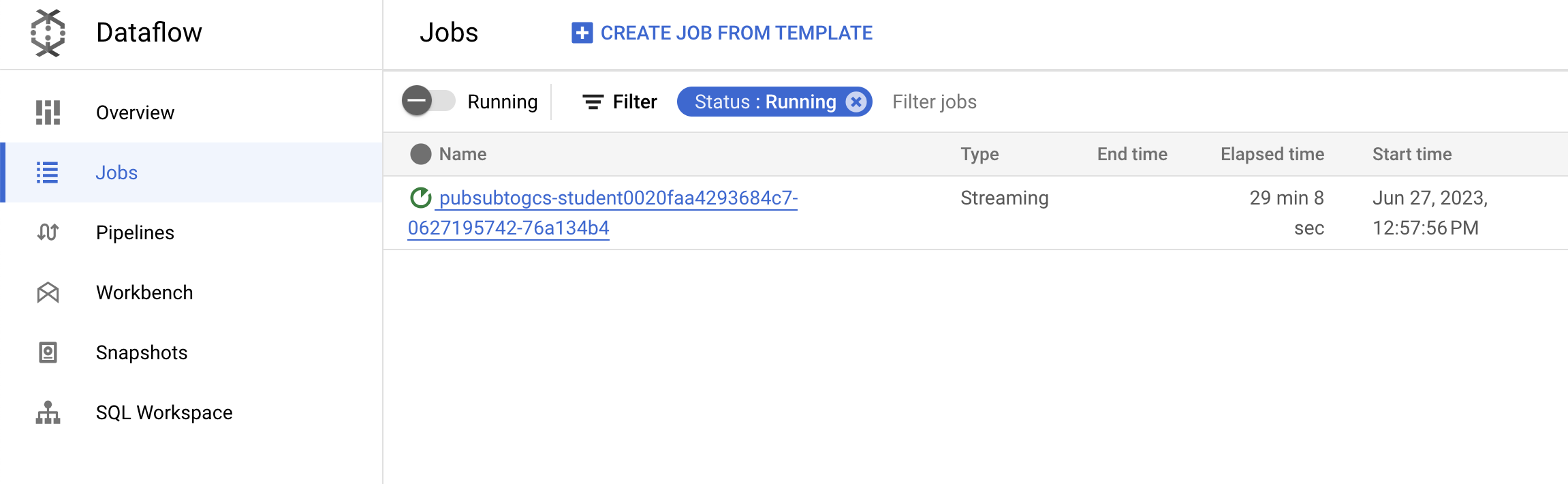

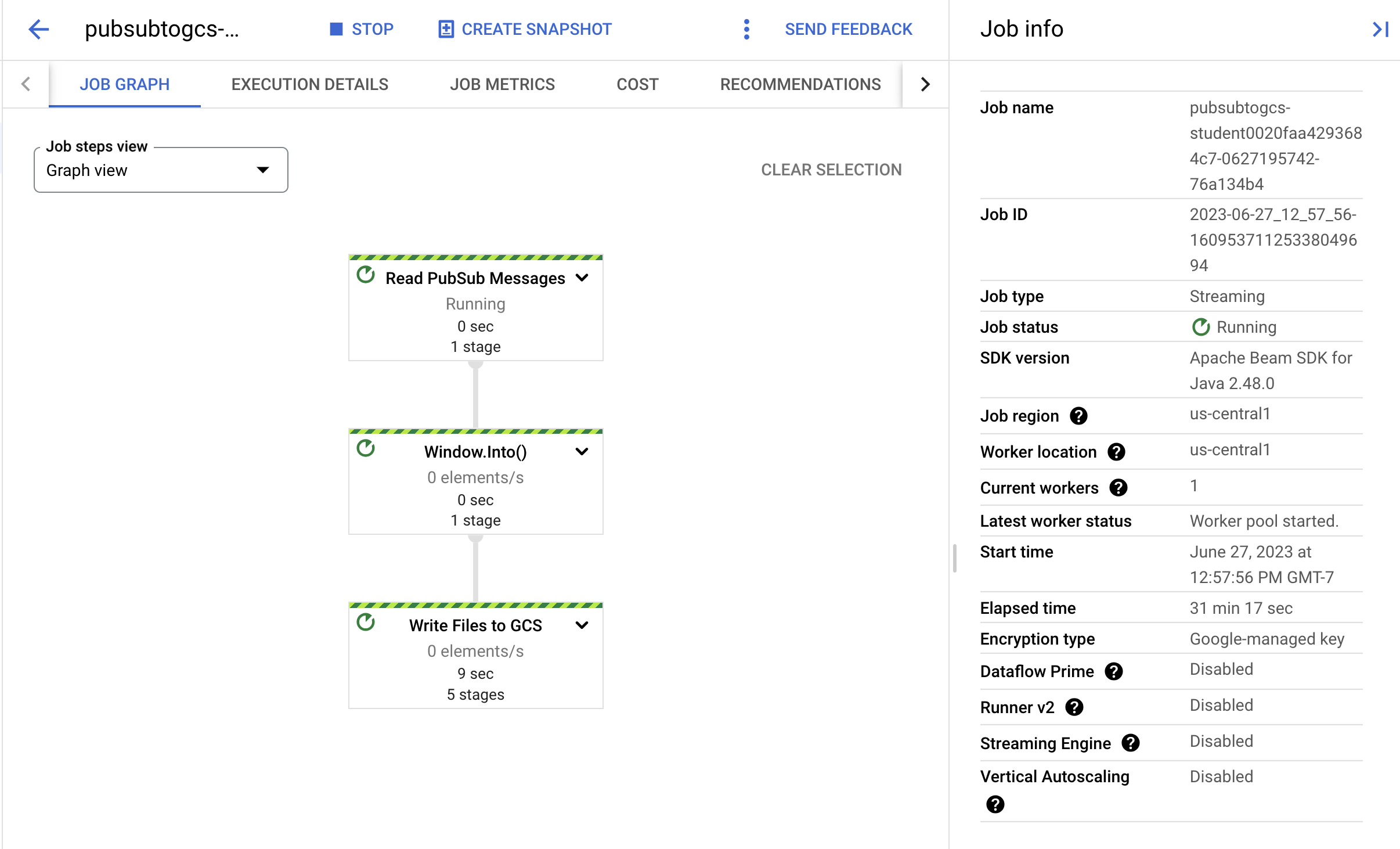

작업 4. 작업 및 파이프라인 진행 상황 관찰

-

Dataflow 콘솔로 이동하여 작업 진행률을 관찰합니다.

-

새로고침을 클릭하여 작업과 최신 상태 업데이트를 확인합니다.

- 작업 이름을 클릭하여 작업 세부정보를 열고 다음을 검토합니다.

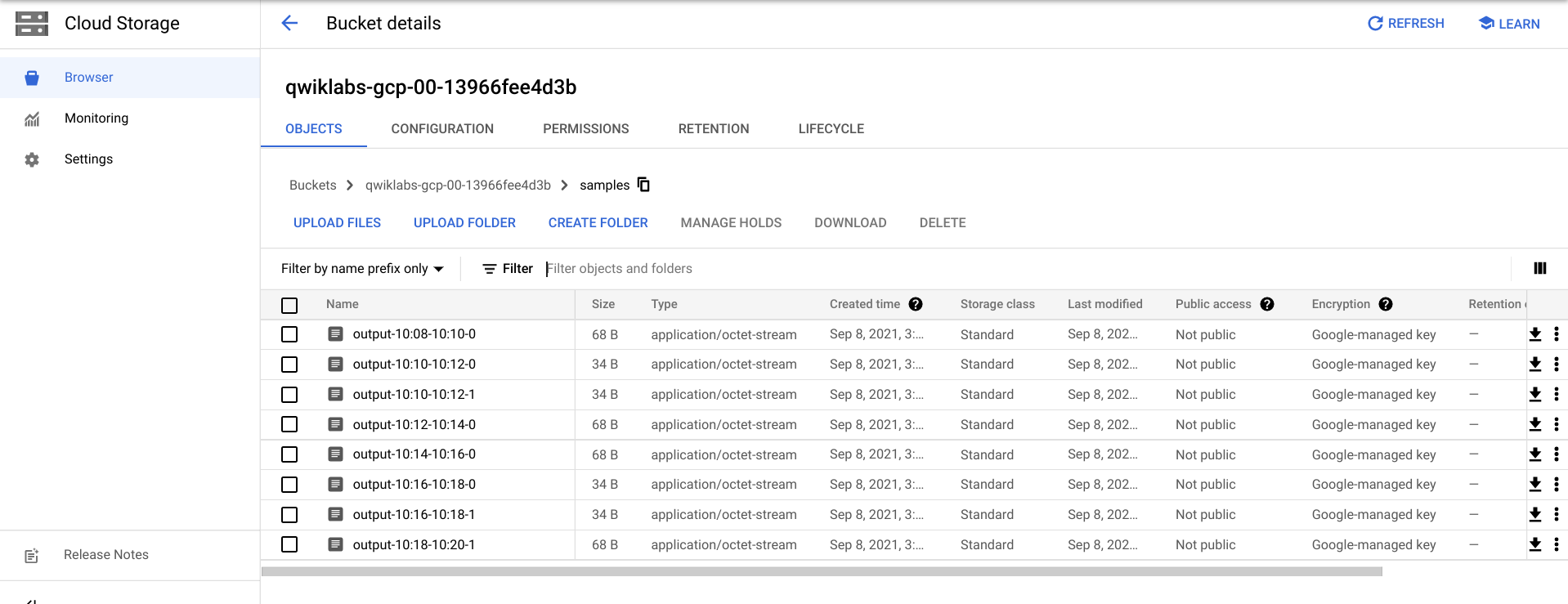

Cloud Storage에서 출력 파일을 보려면 몇 분 정도 기다려야 할 수 있습니다.

-

탐색 메뉴 > Cloud Storage로 이동하여 버킷 이름을 클릭한 다음 샘플을 클릭하면 출력 파일을 확인할 수 있습니다.

- 또는 CTRL+C(Python 옵션의 경우

exit 입력)를 사용하여 Cloud Shell에서 애플리케이션을 종료한 다음 아래 명령어를 실행하여 Cloud Storage에 작성된 파일을 나열할 수 있습니다.

gsutil ls gs://${BUCKET_NAME}/samples/

출력은 다음과 같이 표시됩니다.

gs://{$BUCKET_NAME}/samples/output-22:30-22:32-0-of-1

gs://{$BUCKET_NAME}/samples/output-22:32-22:34-0-of-1

gs://{$BUCKET_NAME}/samples/output-22:34-22:36-0-of-1

gs://{$BUCKET_NAME}/samples/output-22:36-22:38-0-of-1

gs://{$BUCKET_NAME}/samples/output-22:30-22:32-0

gs://{$BUCKET_NAME}/samples/output-22:30-22:32-1

gs://{$BUCKET_NAME}/samples/output-22:32-22:34-0

gs://{$BUCKET_NAME}/samples/output-22:32-22:34-1

작업 5. 삭제

- 아직 종료하지 않았다면 Cloud Shell에서 CTRL+C를 사용하여 애플리케이션을 종료합니다.

Python 옵션의 경우 exit를 입력하여 Python 환경을 종료합니다.

- Cloud Shell에서 Cloud Scheduler 작업을 삭제합니다.

gcloud scheduler jobs delete publisher-job

'계속 진행하시겠어요?' 메시지가 표시되면 Y를 누르고 Enter 키를 누릅니다.

- Dataflow 콘솔에서 작업 이름을 선택하고 중지를 클릭하여 작업을 중지합니다.

메시지가 표시되면 작업 중지 > 취소를 클릭하여 드레이닝하지 않고 파이프라인을 취소합니다.

- Cloud Shell에서 주제를 삭제합니다.

gcloud pubsub topics delete $TOPIC_ID

- Cloud Shell에서 파이프라인이 만든 파일을 삭제합니다.

gsutil -m rm -rf "gs://${BUCKET_NAME}/samples/output*"

gsutil -m rm -rf "gs://${BUCKET_NAME}/temp/*"

- Cloud Shell에서 Cloud Storage 버킷을 삭제합니다.

gsutil rb gs://${BUCKET_NAME}

수고하셨습니다

Pub/Sub 주제에서 메시지를 읽고, 타임스탬프로 메시지의 기간을 설정하고, Cloud Storage 버킷에 메시지를 작성하는 Dataflow 파이프라인을 만들었습니다.

다음 단계/더 학습하기

Google Cloud 교육 및 자격증

Google Cloud 기술을 최대한 활용하는 데 도움이 됩니다. Google 강의에는 빠른 습득과 지속적인 학습을 지원하는 기술적인 지식과 권장사항이 포함되어 있습니다. 기초에서 고급까지 수준별 학습을 제공하며 바쁜 일정에 알맞은 주문형, 실시간, 가상 옵션이 포함되어 있습니다. 인증은 Google Cloud 기술에 대한 역량과 전문성을 검증하고 입증하는 데 도움이 됩니다.

설명서 최종 업데이트: 2025년 8월 20일

실습 최종 테스트: 2025년 8월 20일

Copyright 2025 Google LLC. All rights reserved. Google 및 Google 로고는 Google LLC의 상표입니다. 기타 모든 회사명 및 제품명은 해당 업체의 상표일 수 있습니다.