GSP1096

Übersicht

In diesem Lab lernen Sie in der Praxis, wie Sie SingleStoreDB bereitstellen und mit cloudnativen Produkten von Google Cloud wie Pub/Sub, Dataflow und Cloud Storage kombinieren. Sie arbeiten mit dem öffentlichen Dataset der New Yorker Taxis, um die Funktionen dieser Produkte kennenzulernen.

Zuerst stellen Sie SingleStoreDB über Ihren lokalen Browser bereit und erstellen das entsprechende Schema. Anschließend übertragen Sie die Daten mit Pub/Sub und Dataflow in Echtzeit an Cloud Storage. Die im Objektspeicher erzeugten und gespeicherten Daten werden über die native Pipeline von SingleStoreDB verarbeitet. Nachdem SingleStoreDB die Daten aufgenommen hat, können Sie Abfragen ausführen und mit SingleStore interagieren.

Lerninhalte

Aufgaben in diesem Lab:

- In Google Cloud anmelden

- SingleStoreDB-Instanz/‑Cluster erstellen

- Mithilfe von Cloud Shell eine Verbindung zu SingleStoreDB herstellen und ein Schema erstellen

- Pub/Sub-Themen und ‑Abos erstellen sowie Daten per Pull- und Push-Verfahren an andere Dienste senden

- Dataflow-Streamingjob erstellen

- Native SingleStore-Pipeline verwenden, um Daten aus dem Objektspeicher zu laden

- Abfragen ausführen und mit Ihren Daten in SingleStore interagieren

Voraussetzungen

Sie benötigen Zugriff auf ein privates E‑Mail-Konto, über das Sie eine Bestätigungs-E‑Mail von SingleStore empfangen können. Sie müssen während dieses Labs einen Bestätigungscode empfangen, was nur mit einer privaten E‑Mail-Adresse möglich ist.

Vorkenntnisse in Google Cloud und SingleStore sind hilfreich, aber nicht zwingend erforderlich.

Einrichtung und Anforderungen

Vor dem Klick auf „Start Lab“ (Lab starten)

Lesen Sie diese Anleitung. Labs sind zeitlich begrenzt und können nicht pausiert werden. Der Timer beginnt zu laufen, wenn Sie auf Lab starten klicken, und zeigt Ihnen, wie lange Google Cloud-Ressourcen für das Lab verfügbar sind.

In diesem praxisorientierten Lab können Sie die Lab-Aktivitäten in einer echten Cloud-Umgebung durchführen – nicht in einer Simulations- oder Demo-Umgebung. Dazu erhalten Sie neue, temporäre Anmeldedaten, mit denen Sie für die Dauer des Labs auf Google Cloud zugreifen können.

Für dieses Lab benötigen Sie Folgendes:

- Einen Standardbrowser (empfohlen wird Chrome)

Hinweis: Nutzen Sie den privaten oder Inkognitomodus (empfohlen), um dieses Lab durchzuführen. So wird verhindert, dass es zu Konflikten zwischen Ihrem persönlichen Konto und dem Teilnehmerkonto kommt und zusätzliche Gebühren für Ihr persönliches Konto erhoben werden.

- Zeit für die Durchführung des Labs – denken Sie daran, dass Sie ein begonnenes Lab nicht unterbrechen können.

Hinweis: Verwenden Sie für dieses Lab nur das Teilnehmerkonto. Wenn Sie ein anderes Google Cloud-Konto verwenden, fallen dafür möglicherweise Kosten an.

Lab starten und bei der Google Cloud Console anmelden

-

Klicken Sie auf Lab starten. Wenn Sie für das Lab bezahlen müssen, wird ein Dialogfeld geöffnet, in dem Sie Ihre Zahlungsmethode auswählen können.

Auf der linken Seite befindet sich der Bereich „Details zum Lab“ mit diesen Informationen:

- Schaltfläche „Google Cloud Console öffnen“

- Restzeit

- Temporäre Anmeldedaten für das Lab

- Ggf. weitere Informationen für dieses Lab

-

Klicken Sie auf Google Cloud Console öffnen (oder klicken Sie mit der rechten Maustaste und wählen Sie Link in Inkognitofenster öffnen aus, wenn Sie Chrome verwenden).

Im Lab werden Ressourcen aktiviert. Anschließend wird ein weiterer Tab mit der Seite „Anmelden“ geöffnet.

Tipp: Ordnen Sie die Tabs nebeneinander in separaten Fenstern an.

Hinweis: Wird das Dialogfeld Konto auswählen angezeigt, klicken Sie auf Anderes Konto verwenden.

-

Kopieren Sie bei Bedarf den folgenden Nutzernamen und fügen Sie ihn in das Dialogfeld Anmelden ein.

{{{user_0.username | "Username"}}}

Sie finden den Nutzernamen auch im Bereich „Details zum Lab“.

-

Klicken Sie auf Weiter.

-

Kopieren Sie das folgende Passwort und fügen Sie es in das Dialogfeld Willkommen ein.

{{{user_0.password | "Password"}}}

Sie finden das Passwort auch im Bereich „Details zum Lab“.

-

Klicken Sie auf Weiter.

Wichtig: Sie müssen die für das Lab bereitgestellten Anmeldedaten verwenden. Nutzen Sie nicht die Anmeldedaten Ihres Google Cloud-Kontos.

Hinweis: Wenn Sie Ihr eigenes Google Cloud-Konto für dieses Lab nutzen, können zusätzliche Kosten anfallen.

-

Klicken Sie sich durch die nachfolgenden Seiten:

- Akzeptieren Sie die Nutzungsbedingungen.

- Fügen Sie keine Wiederherstellungsoptionen oder Zwei-Faktor-Authentifizierung hinzu (da dies nur ein temporäres Konto ist).

- Melden Sie sich nicht für kostenlose Testversionen an.

Nach wenigen Augenblicken wird die Google Cloud Console in diesem Tab geöffnet.

Hinweis: Wenn Sie auf Google Cloud-Produkte und ‑Dienste zugreifen möchten, klicken Sie auf das Navigationsmenü oder geben Sie den Namen des Produkts oder Dienstes in das Feld Suchen ein.

Aufgabe 1: Eigenen SingleStore-Cluster starten

Sie sollten jetzt in einem Inkognitofenster in der Google Cloud Console angemeldet sein.

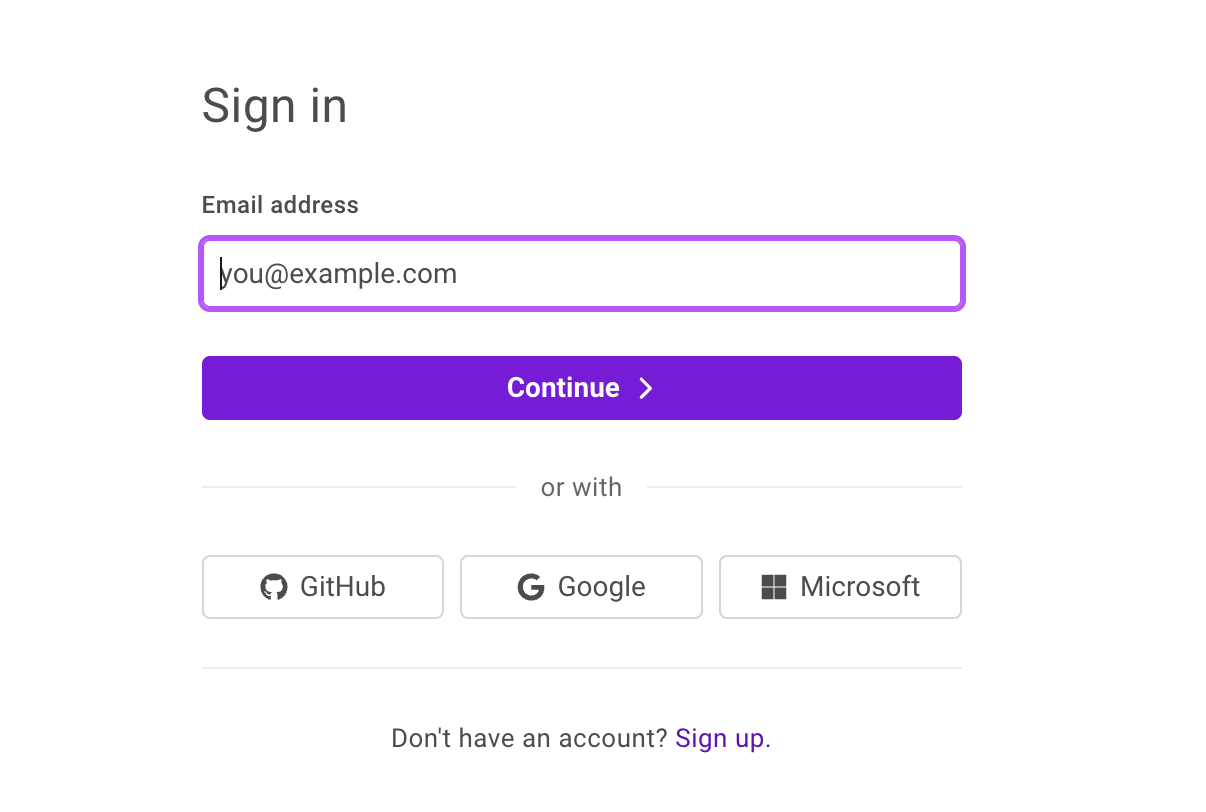

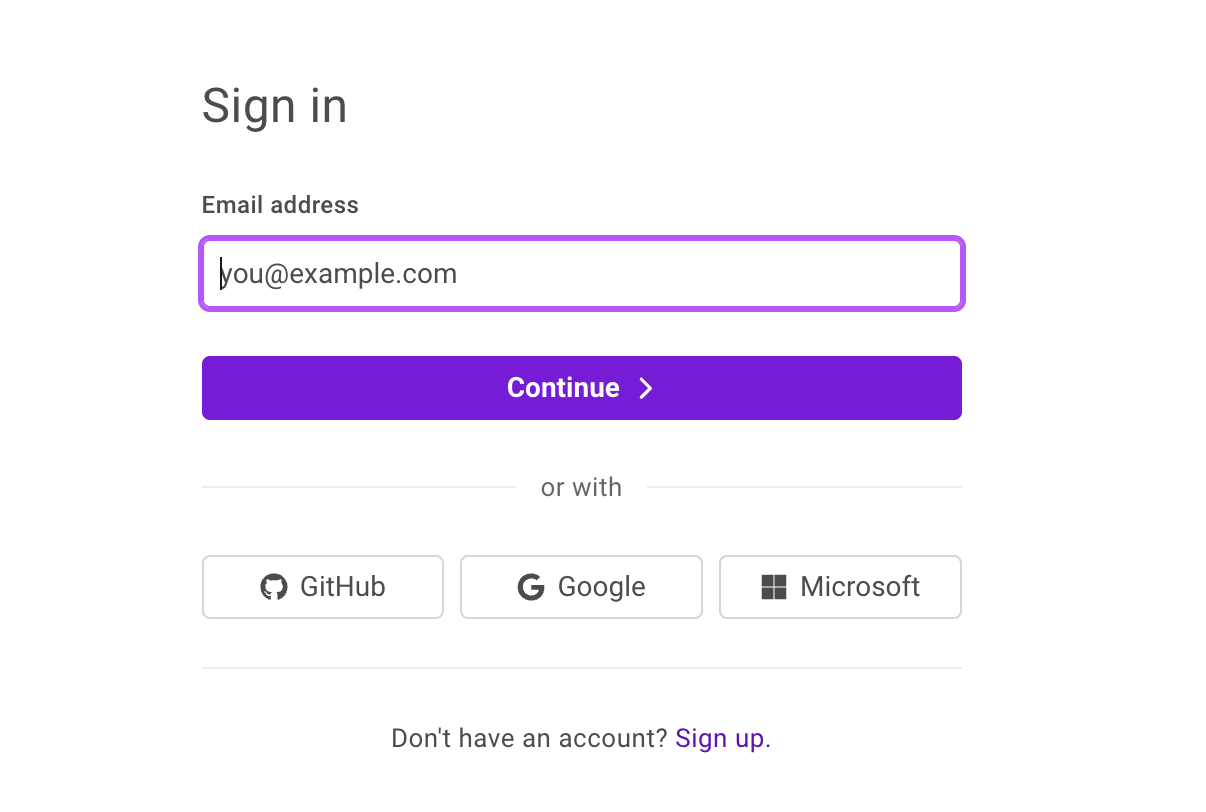

- Öffnen Sie in einem weiteren Tab des Inkognitofensters das SingleStore-Portal. Die folgende Seite sollte angezeigt werden:

- Klicken Sie auf Sign up (Registrieren) und geben Sie Ihre Daten ein.

- Geben Sie unter Company email address (E‑Mail-Adresse des Unternehmens) Ihre private E‑Mail-Adresse ein.

- Klicken Sie auf Weiter.

- Legen Sie ein Passwort fest und klicken Sie auf Continue (Weiter), um sich bei SingleStore anzumelden.

- Geben Sie den Bestätigungscode ein, den Sie per E‑Mail erhalten haben, und klicken Sie auf Submit (Senden).

- Aktivieren Sie das Kästchen neben Terms of Service + Privacy Policy (Nutzungsbedingungen und Datenschutzerklärung) und klicken Sie auf Continue.

- Wählen Sie auf dem Bildschirm About your project (Über Ihr Projekt) eine der Optionen aus und klicken Sie auf Next (Weiter).

- Klicken Sie auf View my Deployment (Bereitstellung ansehen), um zum SingleStore-Kundenportal zu gelangen.

- Klicken Sie auf Start Using SingleStore (SingleStore verwenden), wenn die Meldung Your free starter workspace is ready! (Ihr kostenloser Arbeitsbereich für den Einstieg ist bereit!) angezeigt wird.

Arbeitsbereich erstellen

-

Klicken Sie oben links auf + Create New (+ Neu erstellen) und wählen Sie Deployment (Bereitstellung) aus.

-

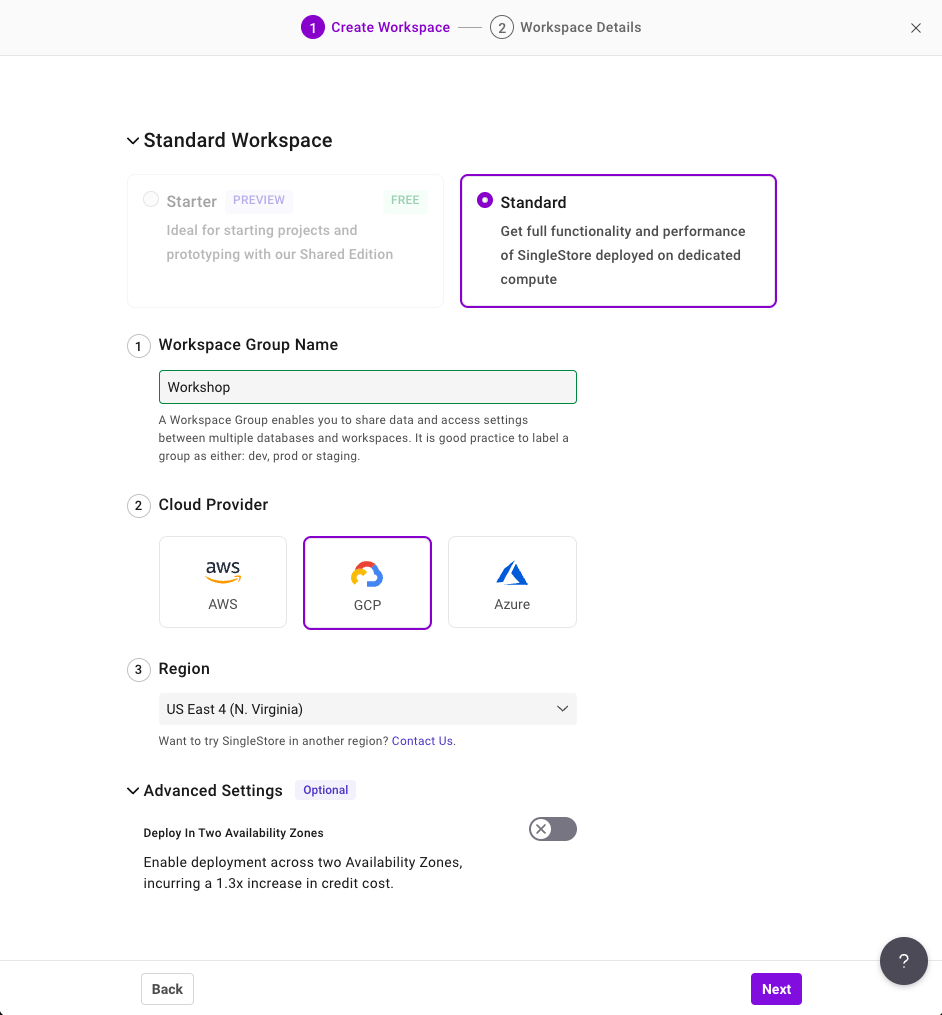

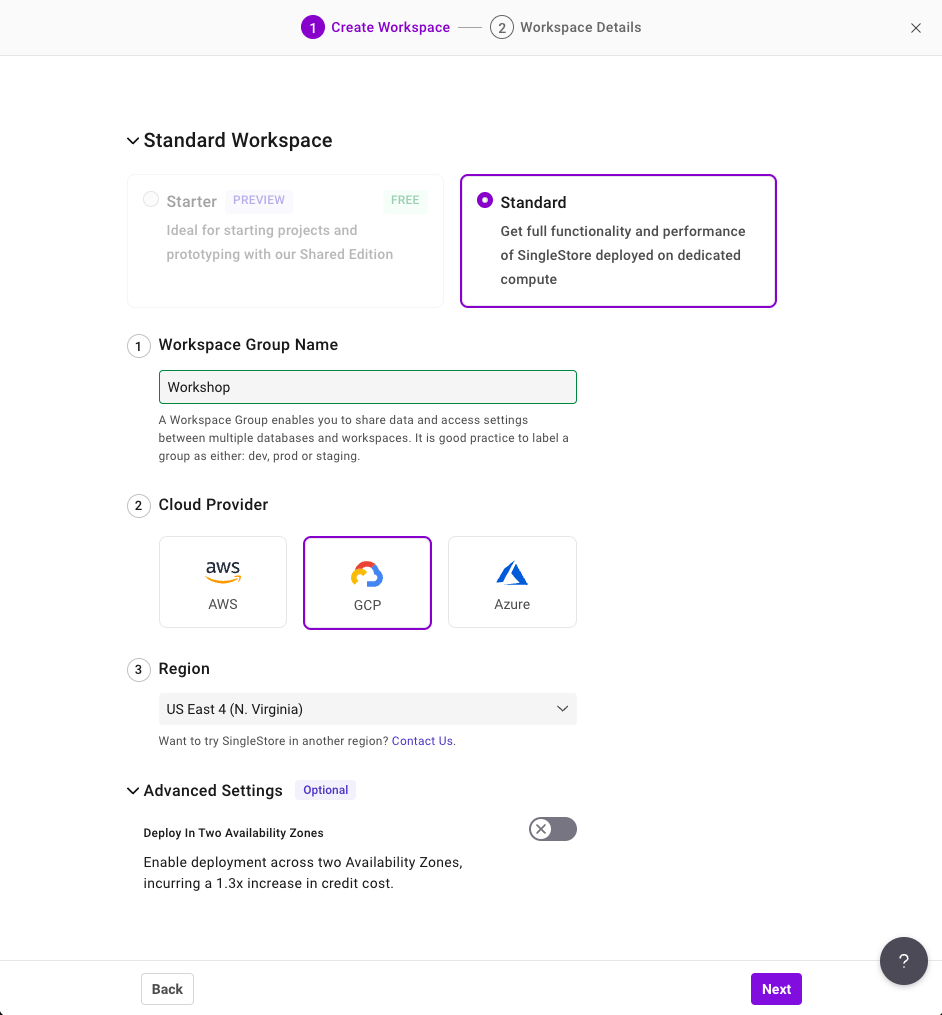

Konfigurieren Sie auf der Seite „Create Workspace“ (Arbeitsbereich erstellen) diese Einstellungen:

- Workspace Group Name (Name der Arbeitsbereichsgruppe): Workshop

- Cloud Provider (Cloud-Anbieter): GCP

- Region: US East 4 (N.Virginia). Dies sollte die Standardeinstellung sein. Falls nicht, ändern Sie sie entsprechend.

Ihre Konfiguration sollte dann so aussehen:

-

Klicken Sie auf Weiter.

-

Lassen Sie auf der Seite Workspace Details (Details zum Arbeitsbereich) die Standardeinstellungen unverändert und klicken Sie auf Create Workspace (Arbeitsbereich erstellen).

Es dauert ein paar Minuten, bis der Arbeitsbereich eingerichtet ist. Für Sie wird eine Beispieldatenbank generiert, die Sie in diesem Lab aber nicht verwenden werden.

Aufgabe 2: Verbindung zu SingleStore und Google Cloud herstellen

-

Bevor Sie sich mit dem SingleStore-Arbeitsbereich verbinden, kehren Sie zur Google Cloud Console zurück.

-

Öffnen Sie ein neues Cloud Shell-Fenster, indem Sie oben rechts in der Console auf das Symbol Cloud Shell aktivieren ( ) klicken. Klicken Sie auf Weiter und dann auf Autorisieren, wenn Sie dazu aufgefordert werden.

) klicken. Klicken Sie auf Weiter und dann auf Autorisieren, wenn Sie dazu aufgefordert werden.

-

Führen Sie in Cloud Shell die folgenden Befehle aus, um das GitHub-Repository zu klonen und den Code für den Workshop herunterzuladen:

git clone https://github.com/mlochbihler/singlestore-gcp-looker-devday-01

cd singlestore-gcp-looker-devday-01/section_b

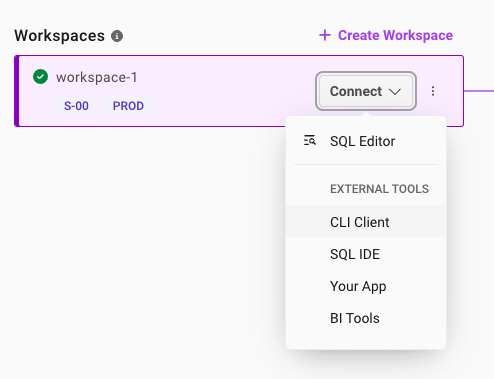

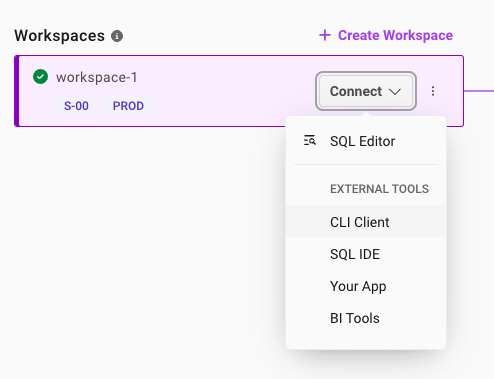

- Kehren Sie zum SingleStore-Portal zurück. Sobald Ihr Arbeitsbereich initialisiert ist, klicken Sie auf den Drop-down-Pfeil neben Connect (Verbinden) und wählen Sie CLI Client (Befehlszeilen-Client) aus.

-

Kopieren Sie auf der Seite Connect to Workspace (Mit Arbeitsbereich verbinden) zuerst das für Sie generierte Passwort. Neben dem Passwort befindet sich ein Symbol zum Kopieren. Es empfiehlt sich, dieses in einer lokalen Datei zu speichern, da Sie es später im Lab noch benötigen.

-

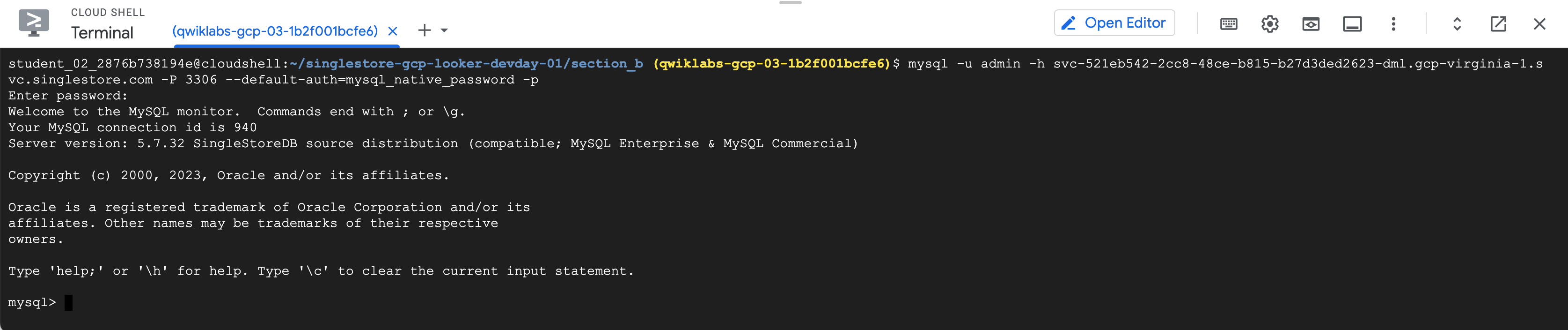

Klicken Sie rechts neben dem MySQL-Befehl auf das Symbol zum Kopieren. Dadurch wird der Befehl in die Zwischenablage kopiert.

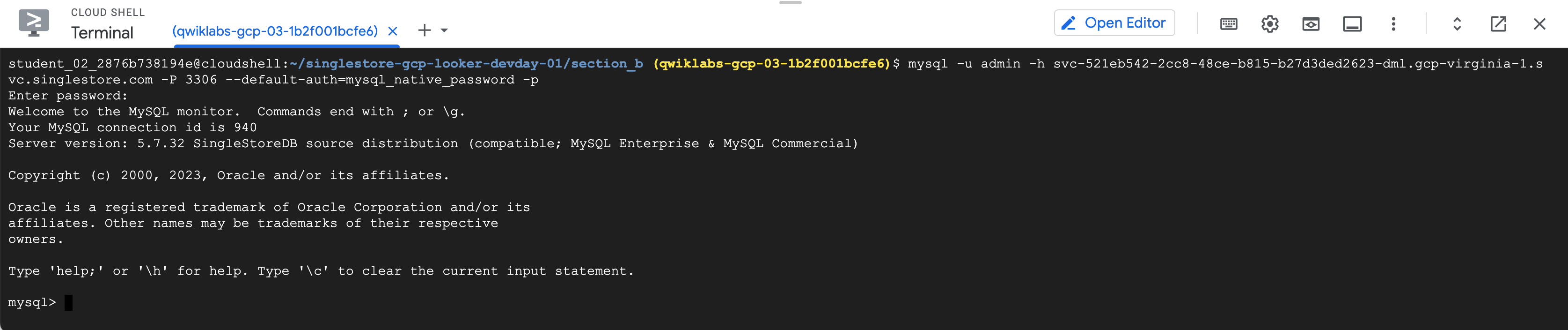

Der MySQL-Befehl sollte so aussehen: mysql -u admin -h svc-b675ae2f-b129-4baf-86ca-0a03c2c31d19-dml.gcp-virginia-1.svc.singlestore.com -P 3306 --default-auth=mysql_native_password --password

Hinweis: Sie sehen das gerade erstellte Passwort im obigen MySQL-Befehl. Das passiert nur beim ersten Öffnen des Fensters. Danach wird das Passwort nicht mehr angezeigt. Speichern Sie es daher unbedingt.

Falls Sie aus irgendeinem Grund keine Verbindung zu SingleStoreDB herstellen können, können Sie Ihr Passwort zurücksetzen. Klicken Sie dazu auf den Tab Access (Zugriff) und dann auf Reset (Zurücksetzen).

-

Kehren Sie zur Google Cloud Console und Ihrer Cloud Shell-Instanz zurück.

-

Fügen Sie den MySQL-Befehl in das Terminal ein.

-

Geben Sie das zuvor kopierte Passwort ein, wenn Sie dazu aufgefordert werden. Sie sehen jetzt die Eingabeaufforderung „mysql>“.

Hinweis: Falls die Bereitstellung nicht mehr auf die MySQL-Befehle reagiert, prüfen Sie den Status des Arbeitsbereichs in SingleStore. Er ist so konfiguriert, dass er pausiert, wenn er länger als 20 Minuten inaktiv ist. In diesem Fall wird die Schaltfläche Resume (Fortsetzen) angezeigt. Klicken Sie darauf, um die Pause zu beenden. Das sollte nur ein paar Minuten dauern.

Aufgabe 3: Schema erstellen und mit SingleStore interagieren

In diesem Abschnitt erstellen Sie die Tabellenschemas.

Verwenden Sie die folgende DDL, um eine neue Datenbank mit dem Namen nyc_taxi zu erstellen.

- Geben Sie nach der Eingabeaufforderung „mysql>“ den folgenden Code ein:

source create_nyctaxi_tables.ddl;

use nyc_taxi; show tables;

Das Ergebnis sollte in etwa so aussehen:

Ausgabe:

Database changed

+--------------------+

| Tables_in_nyc_taxi |

+--------------------+

| avgcost |

| avgdist |

| avgriders |

| avgridetime |

| avgwait_driver |

| avgwait_passenger |

| drivers |

| nab_nyctaxi_scored |

| neighborhoods |

| trips |

| triptotals |

| triptotalsc |

+--------------------+

12 rows in set (0.05 sec)

Sie haben das Schema erstellt und die Datenbanktabellen werden aufgelistet.

- Führen Sie diesen Befehl aus:

select * from avgcost limit 5;

Die Ausgabe dieser Abfrage ist „Empty set“ oder „0“. Das liegt daran, dass Sie nur das Schema erstellt haben und die Tabelle leer ist.

Halten Sie hier kurz inne. Sie haben die SingleStore-Datenbank erstellt und eine Verbindung zu ihr hergestellt. Das Schema ist eingerichtet, aber es sind noch keine Daten vorhanden.

Wenn Sie Zeit haben, können Sie sich gern noch etwas genauer mit SingleStore vertraut machen.

Aufgabe 4: Daten im Lab ansehen (optional)

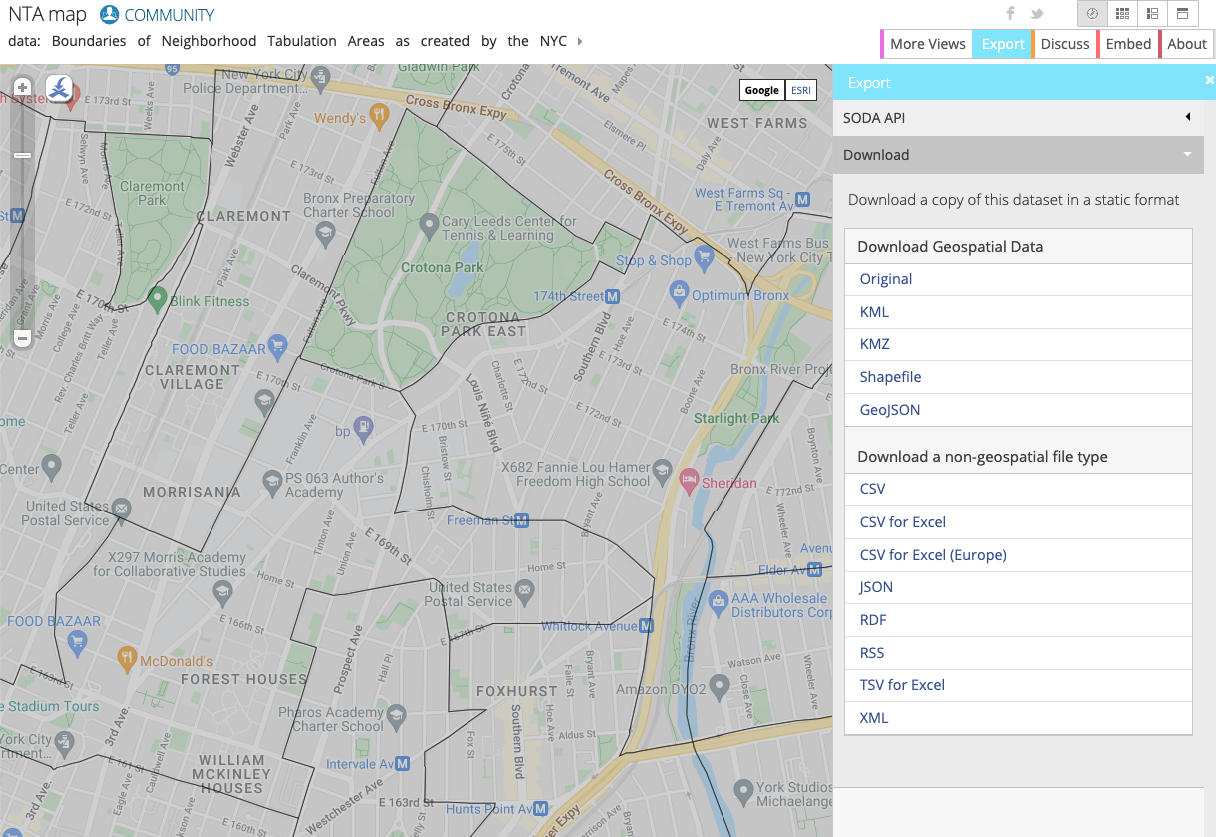

In diesem Lab verwenden Sie Daten der New Yorker Taxis. Sie finden diese in den öffentlichen Datasets von BigQuery oder auf der Website NYC Open Data.

Die Daten wurden bereits in einem Cloud Storage-Bucket für Sie bereitgestellt, sodass Sie sie nicht in Google Cloud herunterladen/importieren müssen. Sie können sich die Daten genauer ansehen, wenn Sie möchten.

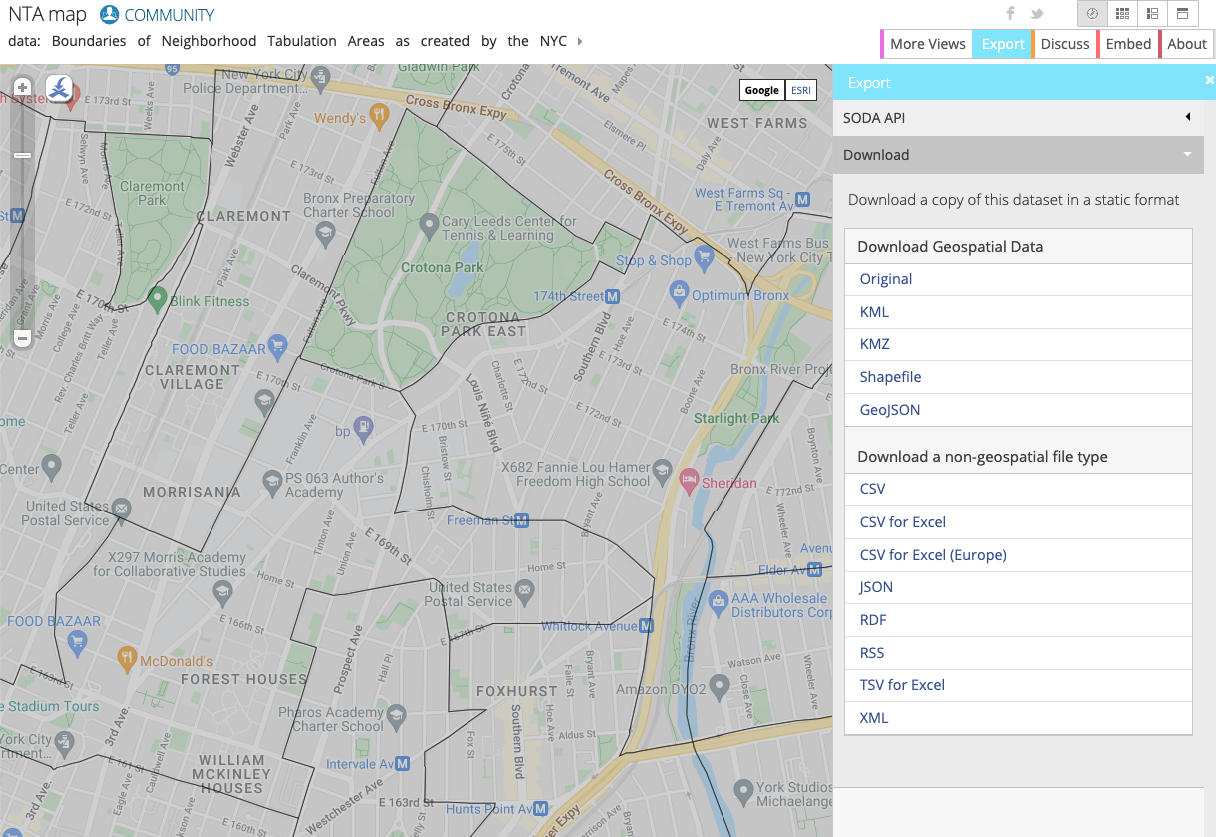

Auf der Website NYC Open Data finden Sie kostenlose Datensätze zu New York City, darunter Daten zu Taxis, Bildung oder Aufgaben der Polizei.

In diesem Lab arbeiten Sie mit den Neighborhood Tabulation Areas (NTAs) des New Yorker Amts für Stadtplanung, die Informationen zu ungefähren Gebieten und Stadtteilen von New York City enthalten. Sie verwenden diese Daten in Kombination mit den New Yorker Taxidaten, um zu sehen, wo Fahrgäste aufgenommen und abgesetzt wurden.

Auf der Website können Sie die Daten nach Stadtviertel visualisieren:

Aufgabe 5: Cloud Storage-Bucket einrichten

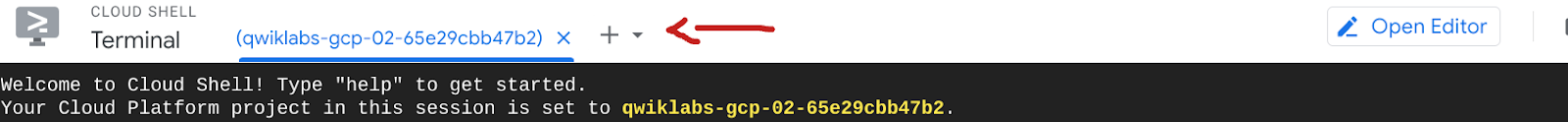

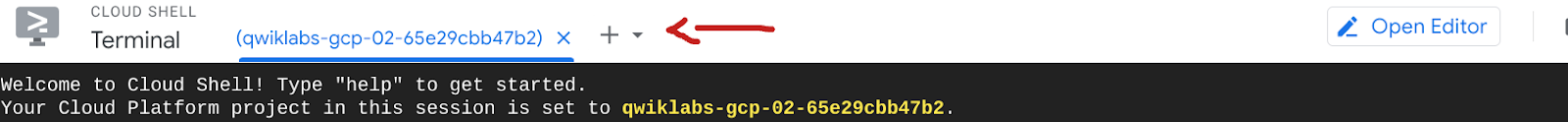

- Öffnen Sie vor Beginn dieses Abschnitts einen neuen Cloud Shell-Terminal-Tab, indem Sie auf die Schaltfläche + klicken:

In Google Cloud gibt es zwei Hauptmethoden zum Einrichten von Ressourcen: über das GUI und über die Befehlszeile. In diesem Lab verwenden Sie die Befehlszeile, um den Bucket zu erstellen und die neuesten Daten zu Stadtteilen von der Website NYC Open Data abzurufen.

- Kopieren Sie die folgenden Befehle und führen Sie sie aus, um einen eigenen Bucket zu erstellen und die Daten aus einem öffentlichen Bucket in diesen zu importieren:

gcloud storage buckets create gs://$GOOGLE_CLOUD_PROJECT --location={{{ project_0.default_region | "REGION" }}}

gcloud storage cp -r gs://configuring-singlestore-on-gcp/drivers gs://$GOOGLE_CLOUD_PROJECT

gcloud storage cp -r gs://configuring-singlestore-on-gcp/trips gs://$GOOGLE_CLOUD_PROJECT

gcloud storage cp gs://configuring-singlestore-on-gcp/neighborhoods.csv gs://$GOOGLE_CLOUD_PROJECT

Wenn Sie dazu aufgefordert werden, klicken Sie auf Autorisieren.

In Ihrem Projekt wurde bereits ein weiterer Bucket erstellt. Dieser ist ein Staging-/temporärer Speicherort für Dataflow.

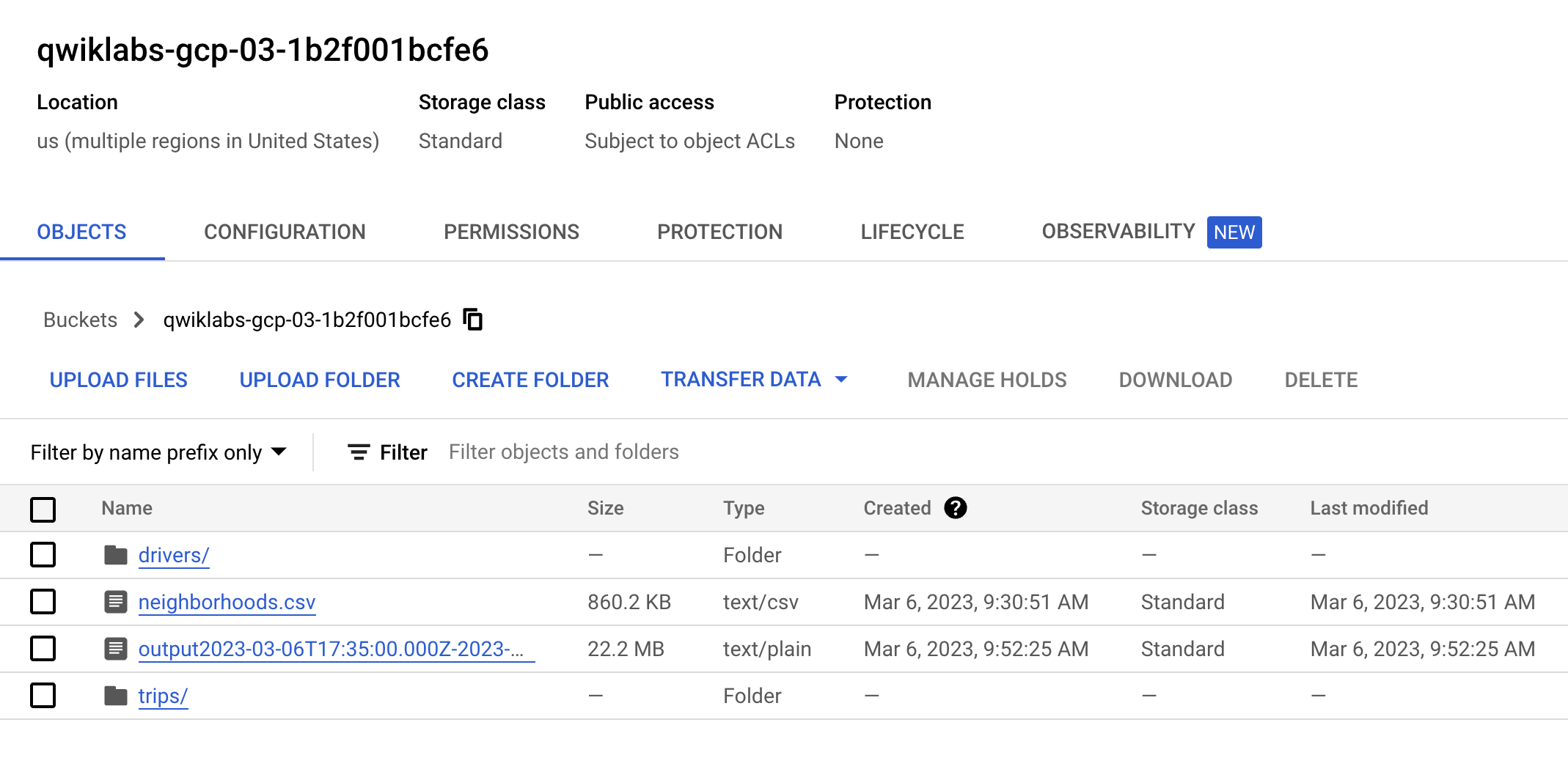

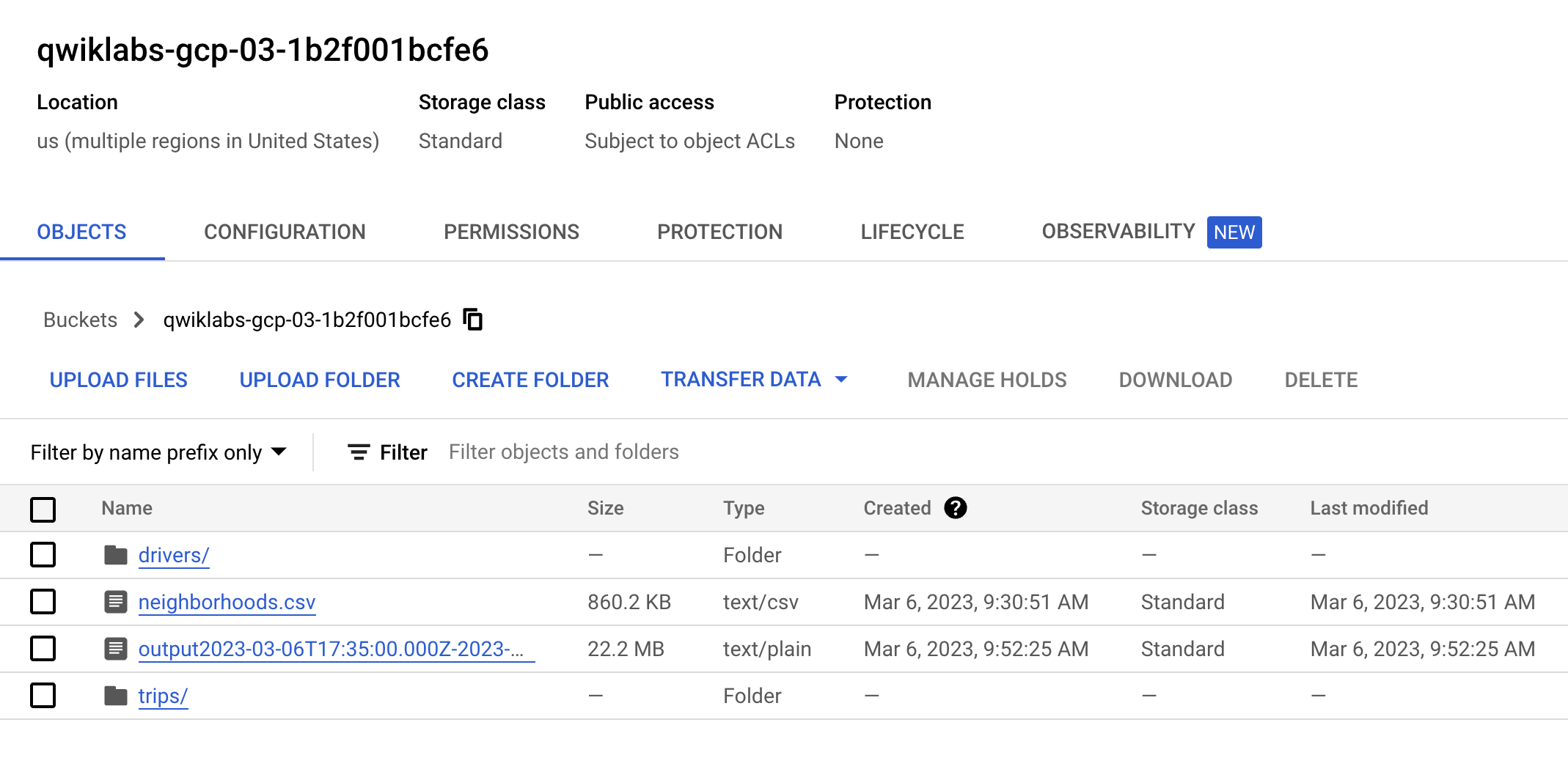

- Rufen Sie Cloud Storage > Buckets auf, suchen Sie Ihren Bucket () und prüfen Sie, ob er zwei Ordner und eine CSV-Datei enthält. Das sollte so aussehen:

Klicken Sie auf Fortschritt prüfen.

Cloud Storage-Bucket einrichten

Aufgabe 6: Pub/Sub und einen Dataflow-Streamingjob konfigurieren

Pub/Sub- und Dataflow-Ressourcen wurden in Ihrem Projekt vorab eingerichtet. Geben Sie im Suchfeld oben in der Cloud Console Pub/Sub beziehungsweise Dataflow ein, um sie zu finden.

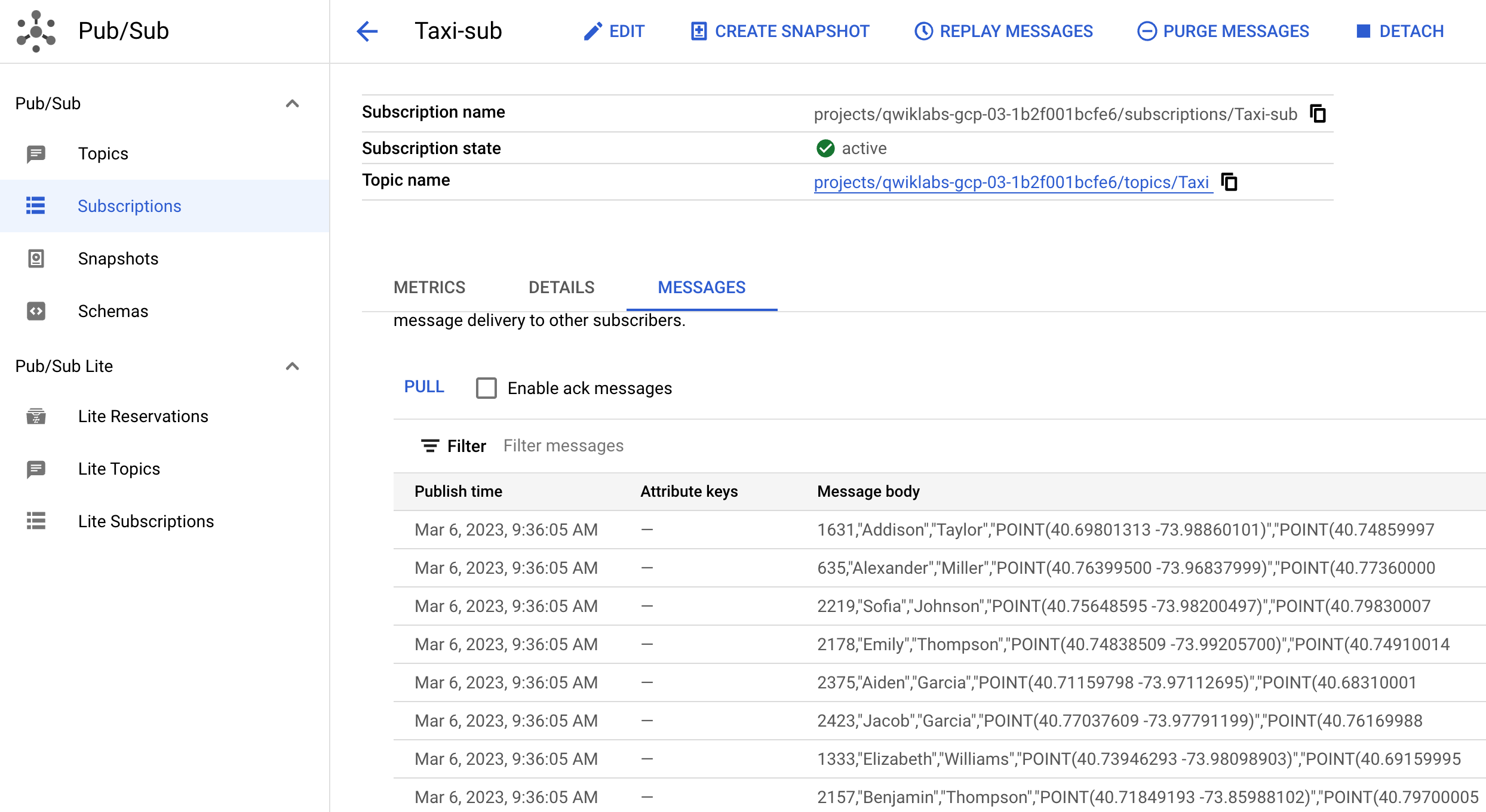

- Führen Sie für Pub/Sub diese Schritte aus:

- Prüfen Sie, ob das Thema „Taxi“ vorhanden ist.

- Prüfen Sie, ob ein Abo mit dem Namen „Taxi-sub“ vorhanden ist.

- Führen Sie für Dataflow diesen Schritt aus:

- Prüfen Sie, ob ein Job namens „GCStoPS“ mit dem Status Fehlgeschlagen vorhanden ist.

-

Klicken Sie auf den Job und dann auf Klonen, um genau diesen Job auszuführen. Benennen Sie ihn um und prüfen Sie die Jobinformationen (die beim Klonen automatisch übernommen wurden), damit Sie wissen, was Sie ausführen. Scrollen Sie nach unten und klicken Sie auf Job ausführen.

-

Kehren Sie zu Dataflow-Jobs zurück und prüfen Sie, ob der Status Ihres Jobs „Wird ausgeführt“ lautet.

Hinweis: Es kann fünf bis sieben Minuten dauern, bis der Dataflow-Job mit dem Streaming beginnt.

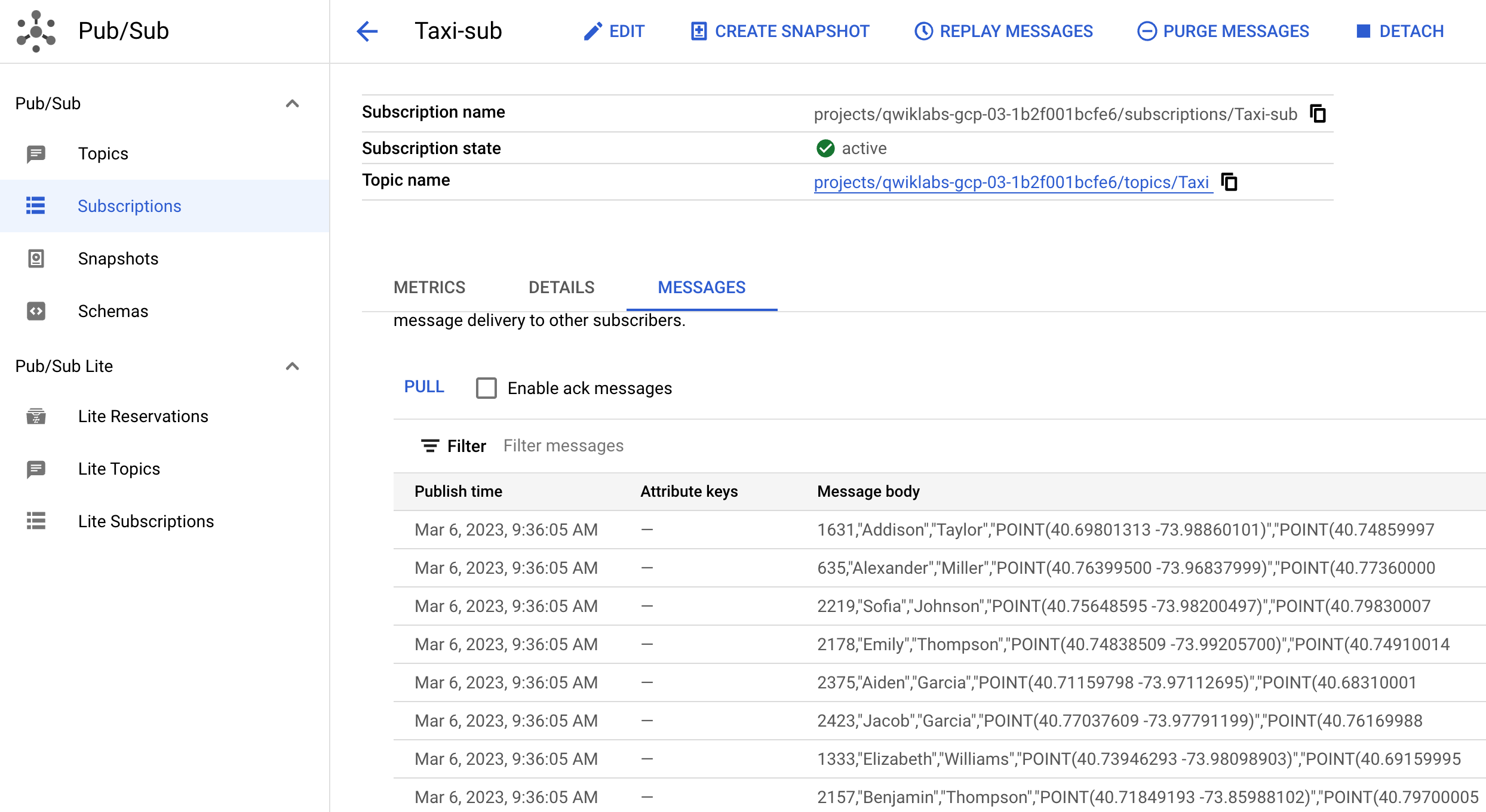

- Kehren Sie zu Pub/Sub zurück, suchen Sie das Abo Taxi-sub, klicken Sie auf Nachrichten und dann auf Pull. Jetzt sollten die ersten Nachrichten eingehen. Das sollte in etwa so aussehen:

Damit simulieren Sie das Live-Streaming von Daten. Wenn Sie beispielsweise weitere Daten in GCS hochladen und in Pub/Sub abrufen, verschiebt Dataflow die Daten live.

Klicken Sie auf Fortschritt prüfen.

Dataflow-Job klonen

Aufgabe 7: Streamingarchitektur in Google Cloud einrichten

Eine gängige Streamingarchitektur in Google Cloud besteht aus Pub/Sub > Dataflow > GCS. In dieser Aufgabe richten Sie diese ein und verbinden dann SingleStore mit GCS.

-

Wechseln Sie zurück zu Dataflow.

-

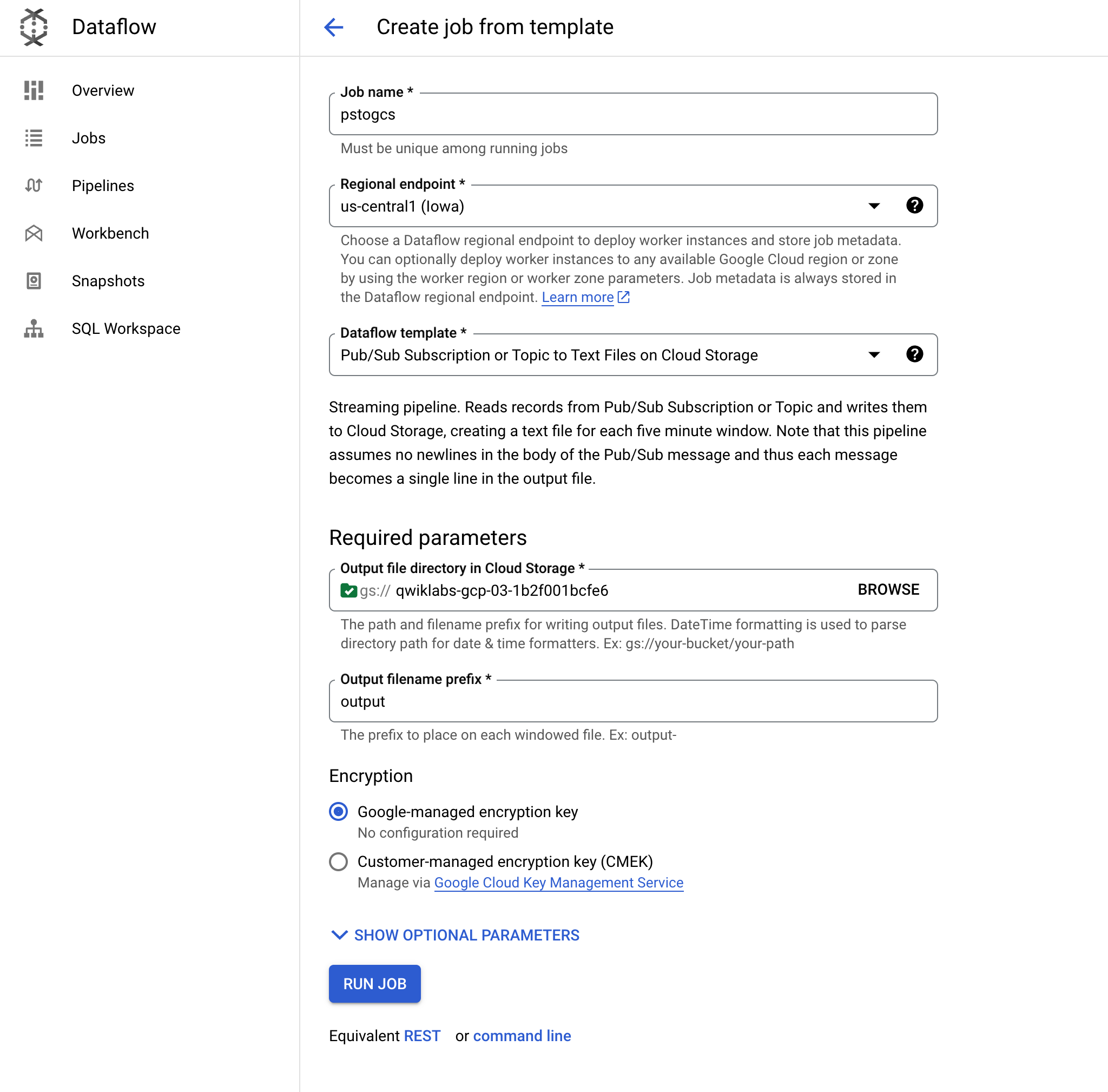

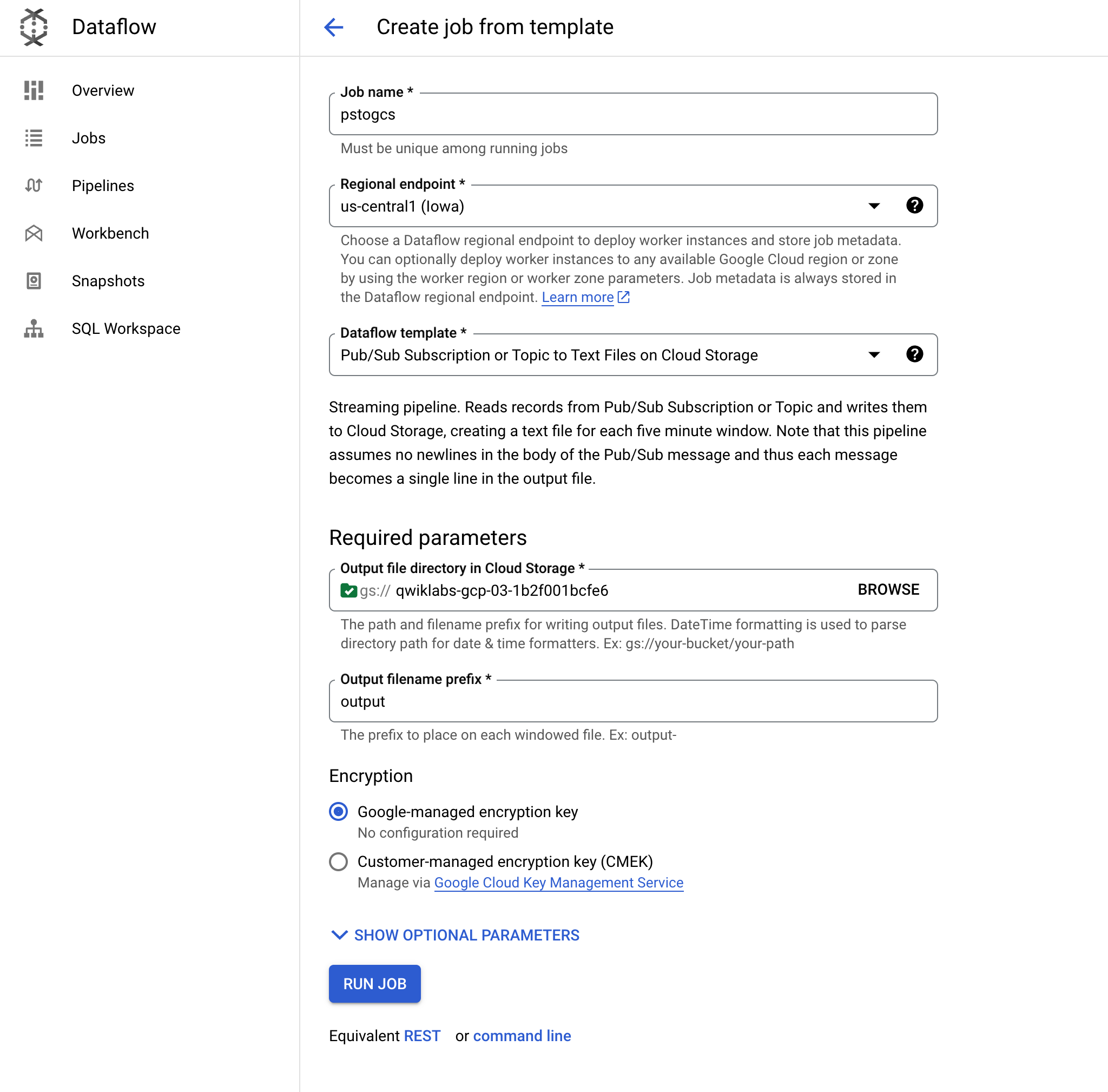

Klicken Sie auf Job aus Vorlage erstellen und nennen Sie ihn pstogcs (Pub/Sub zu GCS).

-

Wählen Sie als regionalen Endpunkt aus.

-

Wählen Sie die Dataflow-Vorlage Pub/Sub Subscription or Topic to Text Files on Cloud Storage aus. Es werden mehrere Optionen angezeigt. Sie müssen also möglicherweise danach filtern.

-

Klicken Sie unter Ziel auf Durchsuchen und wählen Sie den zuvor erstellten Bucket aus. Die Ausgabe des Jobs soll in dem Bucket gespeichert werden, den Sie zuvor im Lab erstellt haben. Klicken Sie auf Auswählen.

-

Lassen Sie das Präfix des Ausgabedateinamens auf output. So werden die Ausgabedateien eindeutig gekennzeichnet.

-

Maximieren Sie Optionale Parameter anzeigen. Wählen Sie als Pub/Sub-Eingabeabo das Abo Taxi-sub aus, in dem Sie gerade Nachrichten empfangen haben. Das Eingabethema muss nicht angegeben werden.

-

Übernehmen Sie für alle anderen Einstellungen die Standardwerte, scrollen Sie zum Ende der Seite und klicken Sie auf JOB AUSFÜHREN.

Hinweis: Wenn beim Ausführen des Jobs ein Fehler auftritt, prüfen Sie, ob die Probleme in den Feldern mit benutzerdefinierten Mustern für Datum und Uhrzeit liegen. Löschen Sie in diesem Fall die Werte in diesen Feldern und versuchen Sie es noch einmal.

Dieser Dataflow-Job sollte die Nachrichten lesen, die Sie zuvor in Pub/Sub gesehen haben, und sie in Ihren Cloud Storage-Bucket streamen.

Hinweis: Es kann fünf bis sieben Minuten dauern, bis der Dataflow-Job mit dem Streaming beginnt.

-

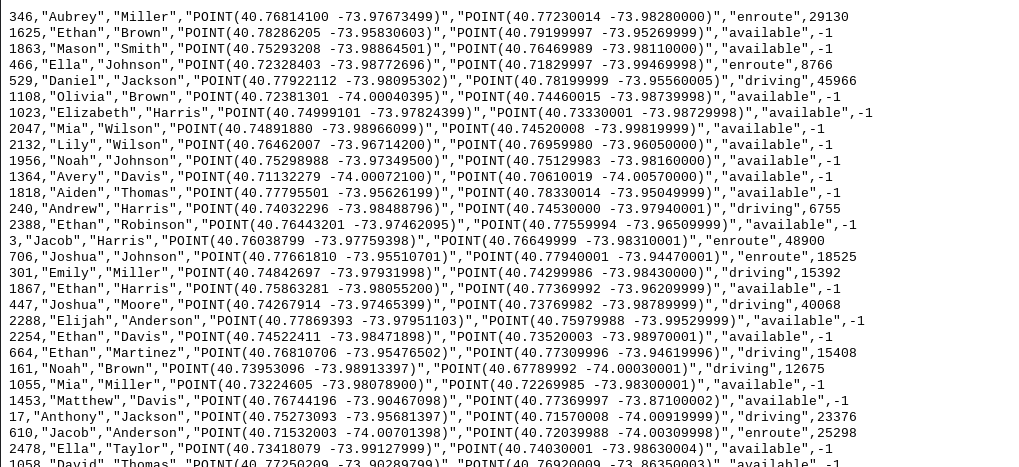

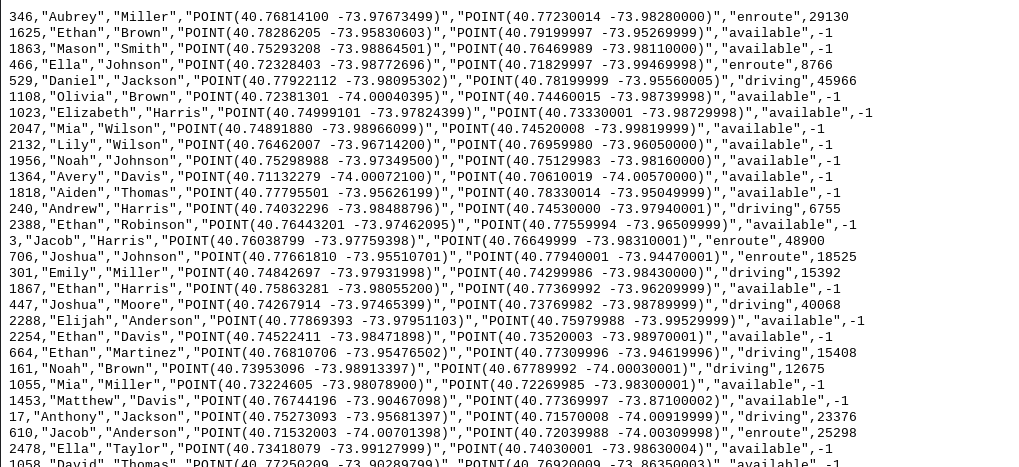

Rufen Sie Cloud Storage > Buckets auf und öffnen Sie den Bucket . Dieser sollte eine mit einem Zeitstempel versehene Ausgabedatei enthalten.

-

Klicken Sie auf die Ausgabedatei und wählen Sie Herunterladen aus. Es sollten Taxidaten einschließlich Namen, Koordinaten und Zeitangaben angezeigt werden.

Klicken Sie auf Fortschritt prüfen.

Streamingarchitektur in Google Cloud einrichten

Gemini Code Assist in der Cloud Shell-IDE aktivieren

Sie können Gemini Code Assist in einer integrierten Entwicklungsumgebung (Integrated Development Environment, IDE) wie Cloud Shell verwenden, um Unterstützung beim Programmieren zu erhalten oder Probleme mit Ihrem Code zu lösen. Bevor Sie Gemini Code Assist verwenden können, müssen Sie das Tool aktivieren.

- Aktivieren Sie in Cloud Shell die Gemini for Google Cloud API mit dem folgenden Befehl:

gcloud services enable cloudaicompanion.googleapis.com

- Klicken Sie in der Cloud Shell-Symbolleiste auf Editor öffnen.

Hinweis: Klicken Sie zum Öffnen des Cloud Shell-Editors in der Cloud Shell-Symbolleiste auf Editor öffnen. Sie können zwischen Cloud Shell und dem Code-Editor wechseln. Klicken Sie dazu entsprechend auf Editor öffnen oder Terminal öffnen.

-

Klicken Sie im linken Bereich auf das Symbol Einstellungen und suchen Sie unter Einstellungen nach Gemini Code Assist.

-

Suchen Sie nach Gemini Code Assist: Aktivieren und prüfen Sie, ob das Kästchen ausgewählt ist. Schließen Sie dann die Einstellungen.

-

Klicken Sie in der Statusleiste unten auf dem Bildschirm auf Cloud Code – kein Projekt.

-

Autorisieren Sie das Plug-in wie beschrieben. Wenn kein Projekt automatisch ausgewählt wurde, klicken Sie auf Google Cloud-Projekt auswählen und wählen Sie aus.

-

Prüfen Sie, ob Ihr Google Cloud-Projekt () in der Cloud Code-Statusmeldung in der Statusleiste angezeigt wird.

Cloud Storage mit SingleStore verbinden

Jetzt müssen Sie einen Schlüssel erstellen, um diesen privaten Cloud Storage-Bucket mit SingleStore zu verbinden.

-

Rufen Sie in Cloud Storage über das Navigationsmenü die Einstellungen auf.

-

Klicken Sie auf den Tab Interoperabilität. Klicken Sie unten auf Schlüssel erstellen.

Als Nächstes nehmen Sie mithilfe von Pipelines Daten in SingleStore auf und starten eine gespeicherte Prozedur.

- Kehren Sie zum Cloud Shell-Tab zurück, auf dem das SingleStore-Terminal geöffnet ist.

-

So erstellen Sie erste SingleStore-Pipelines:

- Klicken Sie im ersten Cloud Shell-Tab auf Editor öffnen. Wenn Sie dazu aufgefordert werden, klicken Sie auf In neuem Fenster öffnen.

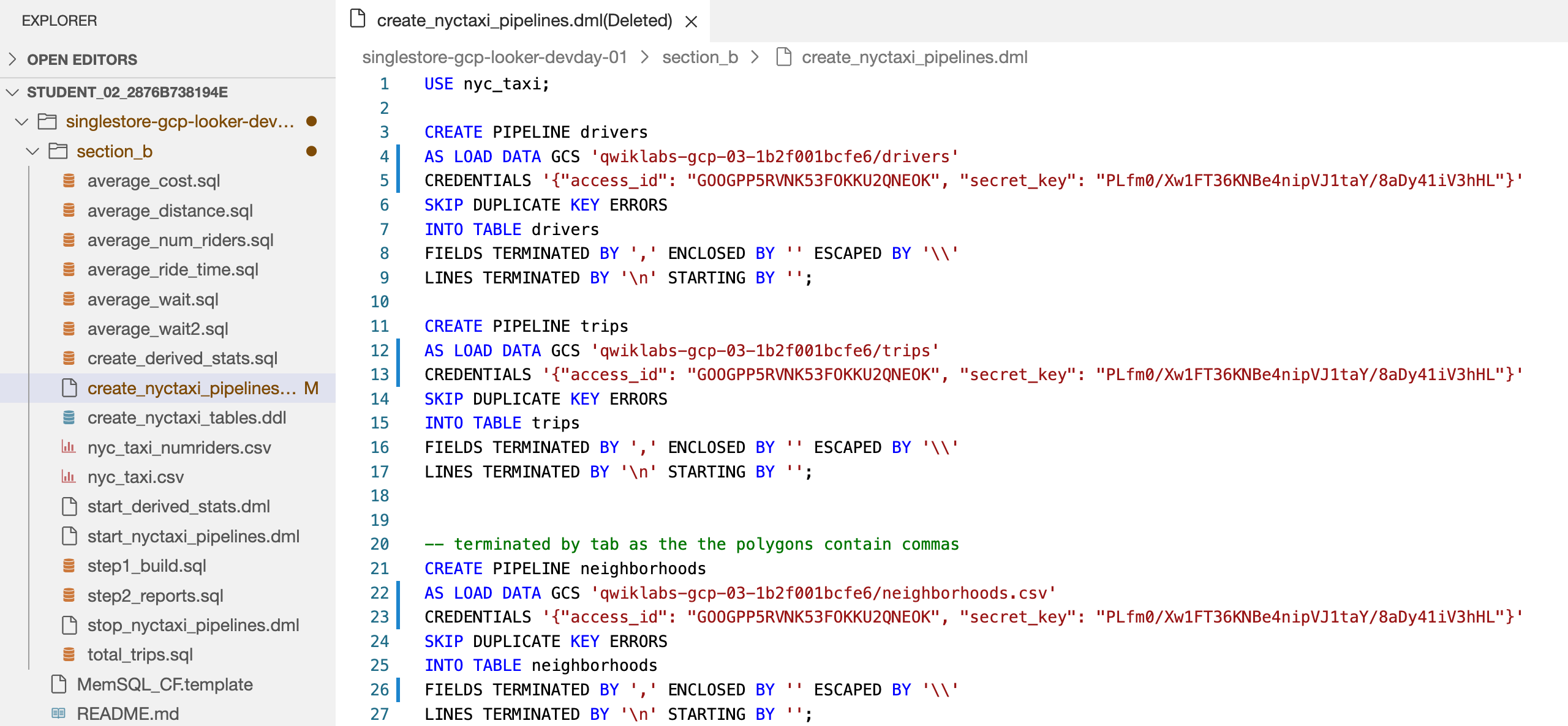

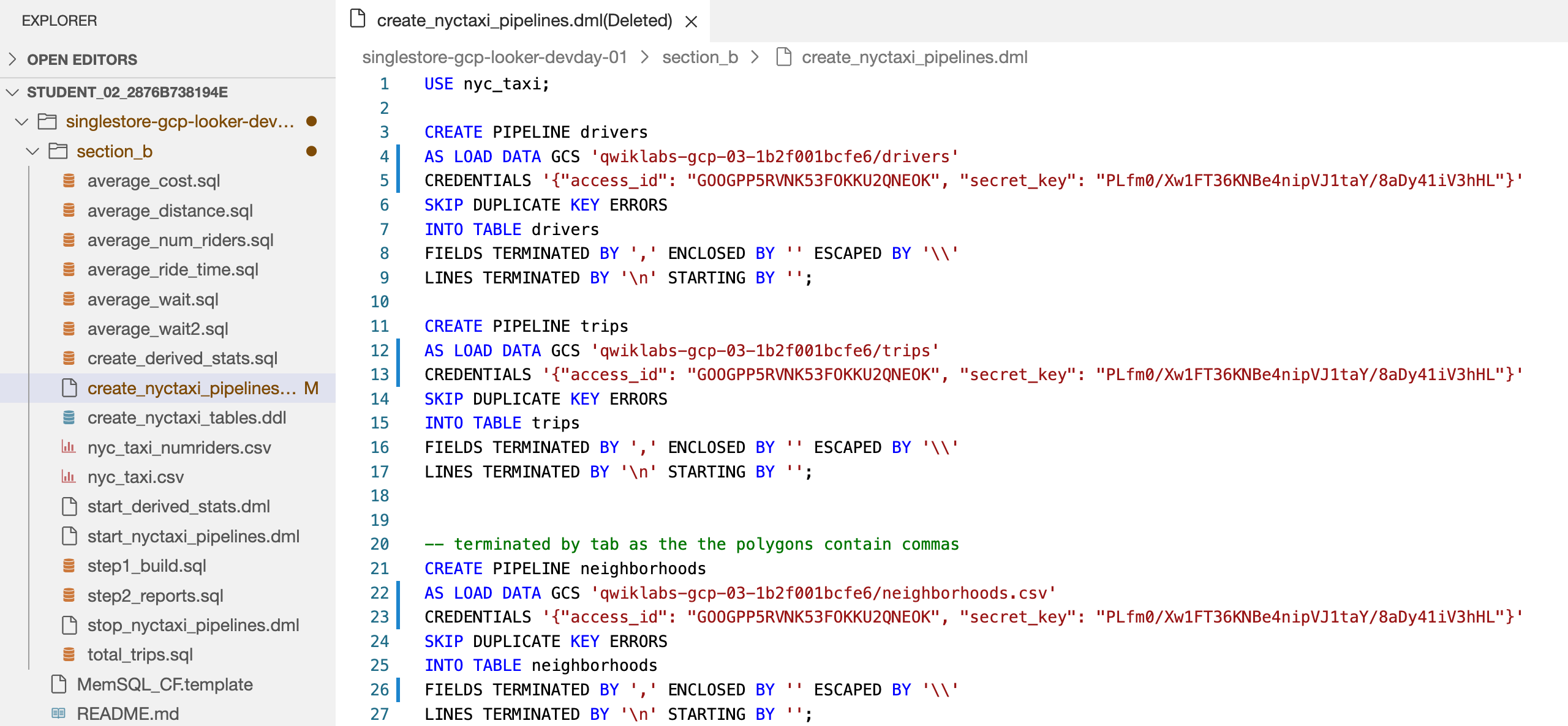

- Öffnen Sie die Datei singlestore-gcp-looker-devday-01 > section b > create_nyctaxi_pipelines.dml.

Dadurch wird Gemini Code Assist aktiviert. Dies lässt sich am Symbol  rechts oben im Editor ablesen.

rechts oben im Editor ablesen.

Mit Gemini Code Assist Informationen zu einer SingleStore-Pipelinedatei abrufen

-

Klicken Sie auf das Gemini Code Assist: Intelligente Aktionen-Symbol  und wählen Sie Erkläre mir das aus.

und wählen Sie Erkläre mir das aus.

-

Gemini Code Assist öffnet ein Chatfenster mit dem vorausgefüllten Prompt Erkläre mir das. Ersetzen Sie im Inline-Textfeld des Code Assist-Chats den vorausgefüllten Prompt durch Folgendes und klicken Sie auf Senden:

You are an expert Data Engineer at Cymbal AI. A new team member is unfamiliar with this SingleStore Pipelines code. Explain this "create_nyctaxi_pipelines.dml" file in detail, breaking down its key components used in the code.

For the suggested improvements, don't update this file.

Die Erklärung des Codes in der Datei create_nyctaxi_pipelines.dml wird im Gemini Code Assist-Chat angezeigt.

- Nehmen Sie die folgenden Änderungen an der Datei vor:

- Ändern Sie in Zeile 4 den Bucket-Namen in den Namen Ihres Buckets.

- Fügen Sie in Zeile 5 die Zugriffs-ID des Storage-Buckets und den geheimen Schlüssel ein, die Sie gerade erstellt haben.

- Ändern Sie in Zeile 12 den Bucket-Namen in den Namen Ihres Buckets.

- Fügen Sie in Zeile 13 die Zugriffs-ID des Storage-Buckets und den geheimen Schlüssel ein, die Sie gerade erstellt haben.

- Ändern Sie in Zeile 22 den Bucket-Namen in den Namen Ihres Buckets und

.tsv in .csv.

- Fügen Sie in Zeile 23 die Zugriffs-ID des Storage-Buckets und den geheimen Schlüssel ein, die Sie gerade erstellt haben.

- Ändern Sie in Zeile 26

/t in ,.

Die Datei sollte jetzt in etwa so aussehen:

- Klicken Sie auf Speichern.

-

Kehren Sie zum Cloud Shell-Terminal zurück. Stellen Sie mit dem MySQL-Befehl, den Sie zuvor bereits verwendet haben, eine Verbindung zu SingleStore her. Sie können denselben Befehl verwenden, den Sie vorher schon zum Herstellen einer Verbindung zu SingleStore verwendet haben.

-

Geben Sie nach der MySQL-Eingabeaufforderung den folgenden Befehl ein, um die Pipelines zu erstellen:

source create_nyctaxi_pipelines.dml;

show pipelines;

Die Ausgabe sollte in etwa so aussehen:

Ausgabe:

| Pipelines_in_nyc_taxi | State | Scheduled |

| --------------------- | ------- | --------- |

| neighborhoods | Stopped | False |

| drivers | Stopped | False |

| trips | Stopped | False |

Aufgabe 8: Pipelines starten

- Führen Sie die folgenden Befehle aus, um die Pipelines zu starten:

source start_nyctaxi_pipelines.dml;

show pipelines;

Ausgabe:

| Pipelines_in_nyc_taxi | State | Scheduled |

| --------------------- | ------- | --------- |

| neighborhoods | Running | False |

| drivers | Running | False |

| trips | Running | False |

- Der Status aller drei Pipelines sollte Wird ausgeführt sein.

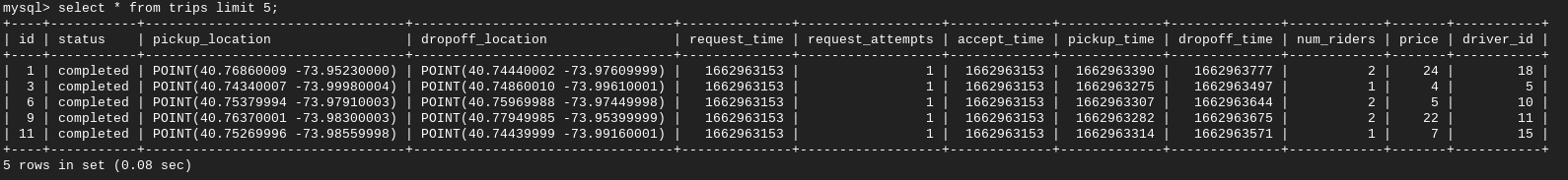

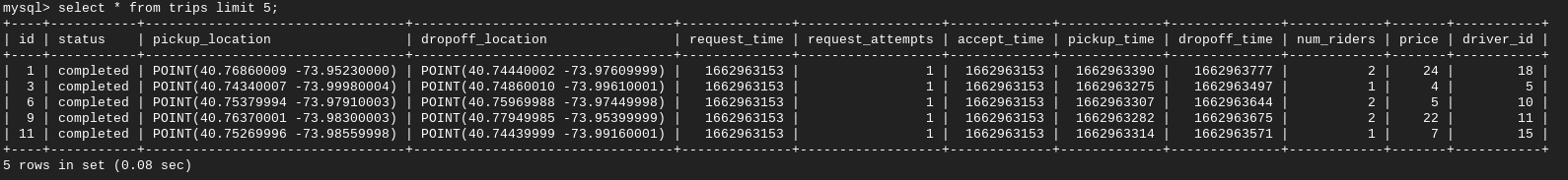

Aufgabe 9: Abfragen für operative Analysen ausführen

- Mit den folgenden Befehlen führen Sie Abfragen für operative Analysen aus:

select * from trips limit 5;

select * from drivers limit 5;

select * from neighborhoods limit 5;

Bericht 1: Gesamtzahl der Fahrten für jedes Viertel.

- Führen Sie dann diesen Befehl aus:

source total_trips.sql;

Bericht 2: Die durchschnittliche Zeitspanne zwischen dem Bestellen eines Taxis und der Abholung der Person.

- Führen Sie als Nächstes diesen Befehl aus:

source average_wait.sql;

Bericht 3: Die durchschnittliche Strecke einer Fahrt.

- Führen Sie den folgenden Befehl aus:

source average_distance.sql;

Bericht 4: Die durchschnittliche Zeitspanne zwischen dem Abholen und dem Absetzen einer Person.

- Führen Sie den folgenden Befehl aus:

source average_ride_time.sql;

Bericht 5: Die durchschnittlichen Kosten einer Taxifahrt.

- Führen Sie den folgenden Befehl aus:

source average_cost.sql;

Bericht 6: Die durchschnittliche Zeitspanne zwischen der Annahme einer Fahrt durch einen Taxifahrer und der Abholung des Fahrgasts.

- Führen Sie den folgenden Befehl aus:

source average_wait2.sql;

Bericht 7: Die durchschnittliche Anzahl der Fahrgäste pro Fahrt.

- Führen Sie zum Schluss den folgenden Befehl aus:

source average_num_riders.sql;

Das wars!

Sie haben das Lab erfolgreich abgeschlossen. In diesem Lab haben Sie SingleStoreDB bereitgestellt und mit cloudnativen Produkten von Google Cloud wie Pub/Sub, Dataflow und Cloud Storage kombiniert. Außerdem haben Sie die native Pipeline von SingleStoreDB verwendet, um Daten aus Cloud Storage aufzunehmen und Abfragen für operative Analysen auszuführen.

Weitere Informationen zu SingleStore finden Sie unter SingleStore.com.

Google Cloud-Schulungen und -Zertifizierungen

In unseren Schulungen erfahren Sie alles zum optimalen Einsatz unserer Google Cloud-Technologien und können sich entsprechend zertifizieren lassen. Unsere Kurse vermitteln technische Fähigkeiten und Best Practices, damit Sie möglichst schnell mit Google Cloud loslegen und Ihr Wissen fortlaufend erweitern können. Wir bieten On-Demand-, Präsenz- und virtuelle Schulungen für Anfänger wie Fortgeschrittene an, die Sie individuell in Ihrem eigenen Zeitplan absolvieren können. Mit unseren Zertifizierungen weisen Sie nach, dass Sie Experte im Bereich Google Cloud-Technologien sind.

Anleitung zuletzt am 04. September 2025 aktualisiert

Lab zuletzt am 04. September 2025 getestet

© 2025 Google LLC. Alle Rechte vorbehalten. Google und das Google-Logo sind Marken von Google LLC. Alle anderen Unternehmens- und Produktnamen können Marken der jeweils mit ihnen verbundenen Unternehmen sein.

) klicken. Klicken Sie auf Weiter und dann auf Autorisieren, wenn Sie dazu aufgefordert werden.

) klicken. Klicken Sie auf Weiter und dann auf Autorisieren, wenn Sie dazu aufgefordert werden.

rechts oben im Editor ablesen.

rechts oben im Editor ablesen.