GSP927

Übersicht

Die Document AI API ist eine Dokumenterkennungslösung. Sie ermöglicht es, unstrukturierte Daten wie Dokumente und E‑Mails leichter zu verstehen, zu analysieren und zu nutzen.

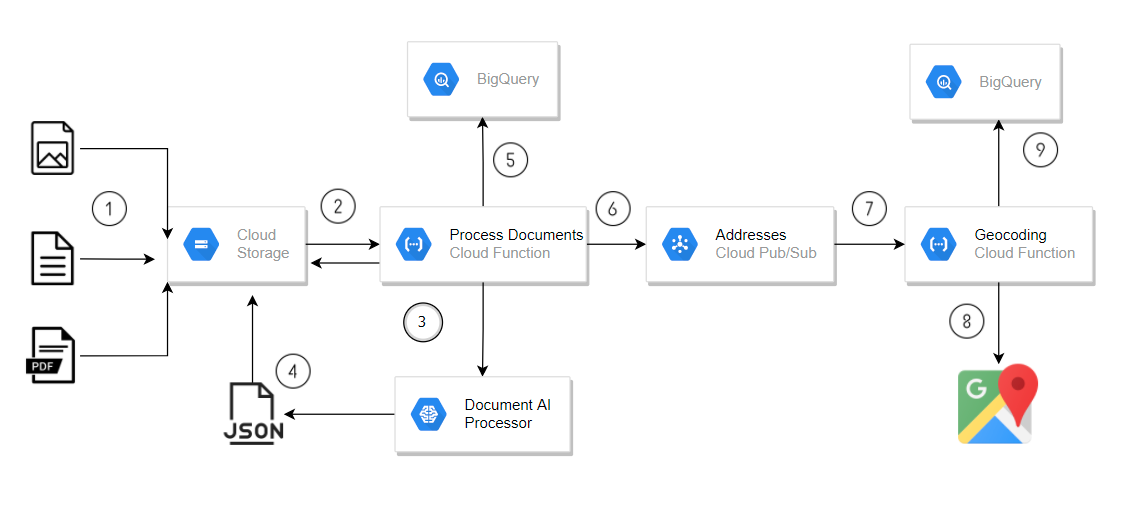

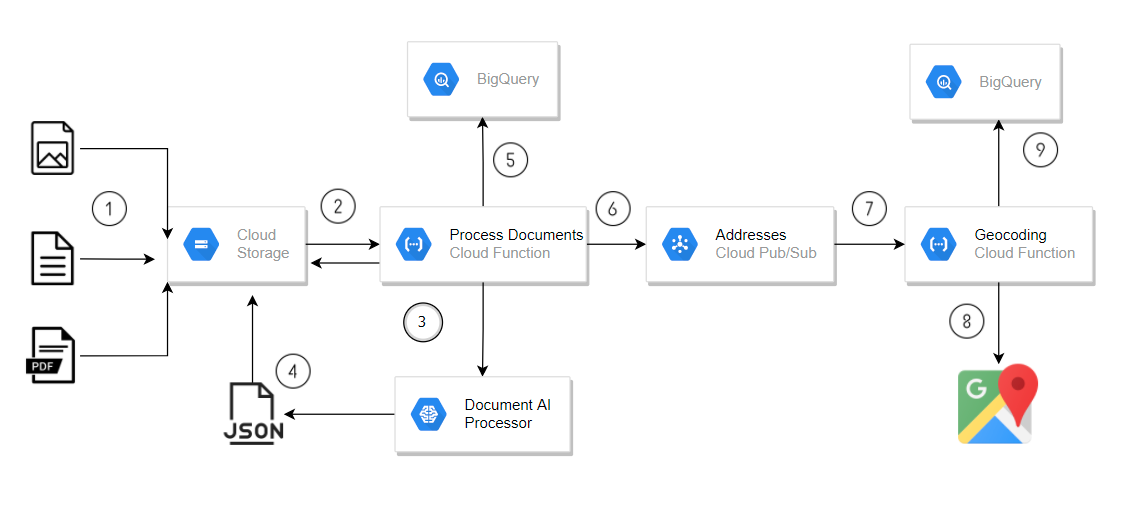

In diesem Lab erstellen Sie eine Pipeline zur Dokumentverarbeitung, um in Cloud Storage hochgeladene Dokumente automatisch zu analysieren Die Pipeline verwendet eine Cloud Run-Funktion mit einem Document AI-Formularprozessor, um Daten zu extrahieren und in BigQuery zu speichern. Wenn das Formular Adressfelder enthält, werden die Adressdaten an ein Pub/Sub-Thema gesendet. Dadurch wird eine zweite Cloud Run-Funktion ausgelöst, die mit der Geocoding API Koordinaten hinzufügt und die Ergebnisse in BigQuery schreibt.

Diese einfache Pipeline verwendet einen allgemeinen Formularprozessor, um grundlegende Formulardaten wie mit Labels versehene Adressfelder zu erkennen. Für komplexere Dokumente bietet Document AI spezielle Parser (die in diesem Lab nicht behandelt werden), mit denen detaillierte Informationen auch ohne explizite Label extrahiert werden. Der Rechnungsparser kann beispielsweise anhand gängiger Rechnungslayouts aus einer Rechnung ohne Labels Adress- und Lieferantendetails ermitteln.

Die Gesamtarchitektur, die Sie erstellen, sieht so aus:

- Formulare werden mit Adressdaten in Cloud Storage hochgeladen.

- Der Upload löst einen Cloud Run-Funktionsaufruf aus, um die Formulare zu verarbeiten.

- Document AI wird von einer Cloud Run-Funktion aufgerufen.

- Document AI-JSON-Daten werden in Cloud Storage gespeichert.

- Formulardaten werden von der Cloud Run-Funktion in BigQuery geschrieben.

- Die Cloud Run-Funktion sendet Adressen an ein Pub/Sub-Thema.

- Die Pub/Sub-Nachricht löst die Cloud Run-Funktion zur Verarbeitung von Geocodes aus.

- Die Geocoding API wird von der Cloud Run-Funktion aufgerufen.

- Die Geocoding-Daten werden von der Cloud Run-Funktion in BigQuery geschrieben.

In dieser Beispielarchitektur werden Cloud Run-Funktionen verwendet, um eine einfache Pipeline zu implementieren. Cloud Run-Funktionen werden jedoch nicht für Produktionsumgebungen empfohlen, da die Document AI API-Aufrufe die von Cloud Run-Funktionen unterstützten Zeitlimits überschreiten können. Für eine robustere serverlose Lösung wird Cloud Tasks empfohlen.

Lerninhalte

Aufgaben in diesem Lab:

- Document AI API aktivieren

- Cloud Run-Funktionen bereitstellen, die die Document AI API, die BigQuery API, die Cloud Storage API und die Pub/Sub API verwenden

Sie werden eine Cloud Run-Funktion konfigurieren, für die Folgendes gilt:

- Sie wird ausgelöst, wenn Dokumente in Cloud Storage hochgeladen werden.

- Sie verwendet die Document AI-Clientbibliothek für Python.

- Sie wird ausgelöst, wenn eine Pub/Sub-Nachricht erstellt wird.

Einrichtung und Anforderungen

Vor dem Klick auf „Start Lab“ (Lab starten)

Lesen Sie diese Anleitung. Labs sind zeitlich begrenzt und können nicht pausiert werden. Der Timer beginnt zu laufen, wenn Sie auf Lab starten klicken, und zeigt Ihnen, wie lange Google Cloud-Ressourcen für das Lab verfügbar sind.

In diesem praxisorientierten Lab können Sie die Lab-Aktivitäten in einer echten Cloud-Umgebung durchführen – nicht in einer Simulations- oder Demo-Umgebung. Dazu erhalten Sie neue, temporäre Anmeldedaten, mit denen Sie für die Dauer des Labs auf Google Cloud zugreifen können.

Für dieses Lab benötigen Sie Folgendes:

- Einen Standardbrowser (empfohlen wird Chrome)

Hinweis: Nutzen Sie den privaten oder Inkognitomodus (empfohlen), um dieses Lab durchzuführen. So wird verhindert, dass es zu Konflikten zwischen Ihrem persönlichen Konto und dem Teilnehmerkonto kommt und zusätzliche Gebühren für Ihr persönliches Konto erhoben werden.

- Zeit für die Durchführung des Labs – denken Sie daran, dass Sie ein begonnenes Lab nicht unterbrechen können.

Hinweis: Verwenden Sie für dieses Lab nur das Teilnehmerkonto. Wenn Sie ein anderes Google Cloud-Konto verwenden, fallen dafür möglicherweise Kosten an.

Cloud Shell aktivieren

Cloud Shell ist eine virtuelle Maschine, auf der Entwicklertools installiert sind. Sie bietet ein Basisverzeichnis mit 5 GB nichtflüchtigem Speicher und läuft auf Google Cloud. Mit Cloud Shell erhalten Sie Befehlszeilenzugriff auf Ihre Google Cloud-Ressourcen.

-

Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren  .

.

-

Klicken Sie sich durch die folgenden Fenster:

- Fahren Sie mit dem Informationsfenster zu Cloud Shell fort.

- Autorisieren Sie Cloud Shell, Ihre Anmeldedaten für Google Cloud API-Aufrufe zu verwenden.

Wenn eine Verbindung besteht, sind Sie bereits authentifiziert und das Projekt ist auf Project_ID, eingestellt. Die Ausgabe enthält eine Zeile, in der die Project_ID für diese Sitzung angegeben ist:

Ihr Cloud-Projekt in dieser Sitzung ist festgelegt als {{{project_0.project_id | "PROJECT_ID"}}}

gcloud ist das Befehlszeilentool für Google Cloud. Das Tool ist in Cloud Shell vorinstalliert und unterstützt die Tab-Vervollständigung.

- (Optional) Sie können den aktiven Kontonamen mit diesem Befehl auflisten:

gcloud auth list

- Klicken Sie auf Autorisieren.

Ausgabe:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

Um das aktive Konto festzulegen, führen Sie diesen Befehl aus:

$ gcloud config set account `ACCOUNT`

- (Optional) Sie können die Projekt-ID mit diesem Befehl auflisten:

gcloud config list project

Ausgabe:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Hinweis: Die vollständige Dokumentation für gcloud finden Sie in Google Cloud in der Übersicht zur gcloud CLI.

Aufgabe 1: APIs aktivieren und API-Schlüssel erstellen

Für dieses Lab müssen Sie die APIs für Document AI, Cloud Run Functions, Cloud Build und Geocoding aktivieren und dann den API-Schlüssel erstellen, der für die Geocoding-Cloud Run-Funktion erforderlich ist.

-

Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren  .

.

-

Geben Sie in der Cloud Shell die folgenden Befehle ein, um die für das Lab erforderlichen APIs zu aktivieren:

gcloud services enable documentai.googleapis.com

gcloud services enable cloudfunctions.googleapis.com

gcloud services enable cloudbuild.googleapis.com

gcloud services enable geocoding-backend.googleapis.com

-

Klicken Sie in der Console im Navigationsmenü ( ) auf APIs und Dienste > Anmeldedaten.

) auf APIs und Dienste > Anmeldedaten.

-

Wählen Sie Anmeldedaten erstellen und dann im Drop-down-Menü die Option API-Schlüssel.

Im Dialogfeld „API-Schlüssel erstellt“ wird der neu erstellte Schlüssel angezeigt. Ein API-Schlüssel ist ein langer String, der Groß- und Kleinbuchstaben, Zahlen und Bindestriche enthalten kann. Beispiel: a4db08b757294ea94c08f2df493465a1

-

Klicken Sie unter Aktionen auf das Dreipunkt-Menü und dann im Dialogfeld auf API-Schlüssel bearbeiten.

-

Wählen Sie im Bereich API-Einschränkungen die Option Schlüssel einschränken aus, um API-Einschränkungen für Ihren neuen API-Schlüssel hinzuzufügen.

-

Klicken Sie auf das Drop-down-Menü APIs auswählen und geben Sie im Filterfeld Geocoding API ein.

-

Wählen Sie Geocoding API aus und klicken Sie auf OK.

-

Klicken Sie auf den Button Speichern.

Hinweis: Wenn Sie die Geocoding API nicht in der Drop-down-Liste Schlüssel einschränken finden, aktualisieren Sie die Seite, um die Liste der verfügbaren APIs zu aktualisieren.

Prüfen, ob alle erforderlichen APIs aktiviert wurden

Aufgabe 2: Quellcode für das Lab herunterladen

In dieser Aufgabe kopieren Sie die Quelldateien in Ihre Cloud Shell. Diese Dateien enthalten den Quellcode für die Cloud Run-Funktionen und die Schemas für die BigQuery-Tabellen, die Sie im Lab erstellen.

- Geben Sie in der Cloud Shell den folgenden Befehl ein, um den Quellcode für dieses Lab herunterzuladen:

mkdir ./documentai-pipeline-demo

gcloud storage cp -r \

gs://spls/gsp927/documentai-pipeline-demo/* \

~/documentai-pipeline-demo/

Aufgabe 3: Formularprozessor erstellen

Erstellen Sie eine Instanz des generischen Formularprozessors, die Sie in der Document AI Platform verwenden können, indem Sie den spezialisierten Document AI-Parser Form Parser von verwenden. Der generische Formularprozessor kann beliebige Arten von Dokumenten verarbeiten und den gesamten Textinhalt extrahieren, der in einem Dokument zu finden ist. Er ist nicht auf gedruckten Text beschränkt, sondern kann auch handschriftlichen Text und Text in beliebiger Ausrichtung verarbeiten. Er unterstützt mehrere Sprachen und weiß, wie Datenelemente in Formularen miteinander in Beziehung stehen. Sie können damit also Schlüssel/Wert-Paare für Formularfelder mit Textlabels extrahieren.

-

Geben Sie in der Google Cloud Console in der Suchleiste Document AI ein und klicken Sie auf das Ergebnis auf der Produktseite.

-

Klicken Sie auf Prozessoren ansehen und dann auf Formularparser, um einen neuen Prozessor zu erstellen.

-

Geben Sie dem Prozessor den Namen form-processor und wählen Sie aus der Liste die Region US (United States) aus.

-

Klicken Sie auf Erstellen, um den Prozessor zu erstellen.

Später in diesem Lab konfigurieren Sie eine Cloud Run-Funktion mit der Prozessor-ID und dem Standort dieses Prozessors, sodass die Cloud Run-Funktion diesen Prozessor zum Verarbeiten von Beispielrechnungen verwendet.

Aufgabe 4: Cloud Storage-Buckets und BigQuery-Dataset erstellen

In diesem Abschnitt bereiten Sie Ihre Umgebung vor, indem Sie die Google Cloud-Ressourcen erstellen, die für Ihre Pipeline zur Dokumentverarbeitung erforderlich sind.

Cloud Storage-Buckets für Eingabe, Ausgabe und Archivierung erstellen

Cloud Storage-Buckets für Eingabe, Ausgabe und Archivierung für Ihre Pipeline zur Dokumentverarbeitung erstellen

- Geben Sie in der Cloud Shell den folgenden Befehl ein, um die Cloud Storage-Buckets für das Lab zu erstellen:

export PROJECT_ID=$(gcloud config get-value core/project)

export BUCKET_LOCATION="{{{my_primary_project.default_region|REGION}}}"

gsutil mb -c standard -l ${BUCKET_LOCATION} -b on \

gs://${PROJECT_ID}-input-invoices

gsutil mb -c standard -l ${BUCKET_LOCATION} -b on \

gs://${PROJECT_ID}-output-invoices

gsutil mb -c standard -l ${BUCKET_LOCATION} -b on \

gs://${PROJECT_ID}-archived-invoices

BigQuery-Dataset und ‑Tabellen erstellen

Erstellen Sie ein BigQuery-Dataset und die drei Ausgabetabellen, die für Ihre Datenverarbeitungspipeline erforderlich sind.

- Geben Sie in der Cloud Shell den folgenden Befehl ein, um die BigQuery-Tabellen für das Lab zu erstellen:

bq --location="US" mk -d \

--description "Form Parser Results" \

${PROJECT_ID}:invoice_parser_results

cd ~/documentai-pipeline-demo/scripts/table-schema/

bq mk --table \

invoice_parser_results.doc_ai_extracted_entities \

doc_ai_extracted_entities.json

bq mk --table \

invoice_parser_results.geocode_details \

geocode_details.json

Sie können in der Cloud Console zu BigQuery wechseln und die Schemas für die Tabellen im Dataset invoice_parser_results mit dem BigQuery-SQL-Arbeitsbereich überprüfen.

Pub/Sub-Thema erstellen

Initialisieren Sie das Pub/Sub-Thema, das zum Auslösen der Datenanreicherungsoperationen der Geocoding API in der Verarbeitungspipeline verwendet wird.

- Geben Sie in der Cloud Shell den folgenden Befehl ein, um die Pub/Sub-Themen für das Lab zu erstellen:

export GEO_CODE_REQUEST_PUBSUB_TOPIC=geocode_request

gcloud pubsub topics \

create ${GEO_CODE_REQUEST_PUBSUB_TOPIC}

Kontrollieren Sie, dass das BigQuery-Dataset, die Cloud Storage-Buckets und das Pub/Sub-Thema erstellt wurden.

Aufgabe 5: Cloud Run-Funktionen erstellen

Erstellen Sie die beiden Cloud Run-Funktionen, die Ihre Datenverarbeitungspipeline zum Verarbeiten von in Cloud Storage hochgeladenen Rechnungen verwendet. Diese Funktionen nutzen die Document AI API, um aus den Rohdokumenten Formulardaten zu extrahieren, und dann die GeoCode API, um Standortbestimmungsdaten zu den aus den Dokumenten extrahierten Adressinformationen abzurufen.

Sie können den Quellcode für die beiden Cloud Run-Funktionen mit dem Code-Editor oder einem anderen Editor Ihrer Wahl untersuchen. Die Cloud Run-Funktionen werden in der Cloud Shell in den folgenden Ordnern gespeichert:

- Rechnungen verarbeiten:

scripts/cloud-functions/process-invoices

- Adressen geocodieren:

scripts/cloud-functions/geocode-addresses

Die Cloud Run-Hauptfunktion process-invoices wird ausgelöst, wenn Dateien in den Speicher-Bucket für Eingabedateien hochgeladen werden, den Sie zuvor erstellt haben.

Der Funktionsordner scripts/cloud-functions/process-invoices enthält die beiden Dateien, die zum Erstellen der Cloud Run-Funktion process-invoices verwendet werden.

In der Datei requirements.txt sind die Python-Bibliotheken angegeben, die für die Funktion erforderlich sind. Dazu gehören die Document AI-Clientbibliothek sowie die anderen Google Cloud-Bibliotheken, die der Python-Code benötigt, um die Dateien aus Cloud Storage zu lesen, Daten in BigQuery zu speichern und in Pub/Sub Nachrichten zu schreiben, die die übrigen Funktionen in der Lösungspipeline auslösen.

Die Python-Datei main.py enthält den Cloud Run-Funktionscode, der die API-Clients für Document AI, BigQuery und Pub/Sub sowie die folgenden internen Funktionen zur Dokumentverarbeitung erstellt:

-

write_to_bq: schreibt das Wörterbuchobjekt in die BigQuery-Tabelle. Hinweis: Sie müssen dafür sorgen, dass das Schema gültig ist, bevor Sie diese Funktion aufrufen.

-

get_text: ordnet Textanker für Formularname und ‑wert dem gescannten Text im Dokument zu. So kann die Funktion bestimmte Formularelemente wie „Lieferantenname“ und „Adresse“ identifizieren und den relevanten Wert extrahieren. Ein spezieller Document AI-Prozessor stellt diese Kontextinformationen direkt in im Attribut „entities“ bereit.

-

process_invoice: verwendet die asynchrone Document AI-Client-API, um Dateien aus Cloud Storage zu lesen und zu verarbeiten. Dabei wird so vorgegangen:

- Es wird eine asynchrone Anfrage zur Verarbeitung der Dateien erstellt, die den Aufruf der Cloud Run-Funktion ausgelöst haben.

- Die Daten werden verarbeitet, um Rechnungsfelder zu extrahieren. Bestimmte Felder, die Teil des vordefinierten Schemas sind, werden in einem Wörterbuch gespeichert.

- Es werden Pub/Sub-Nachrichten veröffentlicht, um mit Adressformulardaten, die aus dem Dokument extrahiert wurden, die Cloud Run-Geocoding-Funktion auszulösen.

- Die Formulardaten werden in eine BigQuery-Tabelle geschrieben.

- Die Zwischenausgabedateien, die über den asynchronen Document AI API-Aufruf erstellt wurden, werden gelöscht.

- Die Eingabedateien werden in den Archiv-Bucket kopiert.

- Die verarbeiteten Eingabedateien werden gelöscht.

Die Cloud Run-Funktion process_invoices verarbeitet nur Formulardaten, denen Formularfelder mit den folgenden Namen zugeordnet werden konnten:

input_file_nameaddresssupplierinvoice_numberpurchase_orderdatedue_datesubtotaltaxtotal

Die andere Cloud Run-Funktion, geocode-addresses, wird ausgelöst, wenn eine neue Nachricht in einem Pub/Sub-Thema eingeht. Sie extrahiert ihre Parameterdaten aus der Pub/Sub-Nachricht.

Cloud Run-Funktion zur Verarbeitung von in Cloud Storage hochgeladenen Dokumenten erstellen

Erstellen Sie eine Cloud Run-Funktion, die einen Document AI-Formularprozessor verwendet, um Formulardokumente zu parsen, die in einen Cloud Storage-Bucket hochgeladen wurden.

- Führen Sie den folgenden Befehl aus, um die E‑Mail-Adresse des Cloud Storage-Dienst-Agenten des Projekts abzurufen:

gcloud storage service-agent --project=$PROJECT_ID

- Führen Sie den folgenden Befehl aus, um dem Cloud Storage-Dienstkonto die erforderlichen Berechtigungen zu erteilen:

PROJECT_NUMBER=$(gcloud projects describe $PROJECT_ID --format="value(projectNumber)")

gcloud iam service-accounts create "service-$PROJECT_NUMBER" \

--display-name "Cloud Storage Service Account" || true

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:service-$PROJECT_NUMBER@gs-project-accounts.iam.gserviceaccount.com" \

--role="roles/pubsub.publisher"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:service-$PROJECT_NUMBER@gs-project-accounts.iam.gserviceaccount.com" \

--role="roles/iam.serviceAccountTokenCreator"

Hinweis: Wenn das Cloud Storage-Dienstkonto bereits vorhanden ist, können Sie die Fehlermeldung ignorieren.

- Erstellen Sie die Cloud Run-Rechnungsprozessorfunktion:

cd ~/documentai-pipeline-demo/scripts

export CLOUD_FUNCTION_LOCATION="{{{my_primary_project.default_region|REGION}}}"

gcloud functions deploy process-invoices \

--no-gen2 \

--region=${CLOUD_FUNCTION_LOCATION} \

--entry-point=process_invoice \

--runtime=python39 \

--source=cloud-functions/process-invoices \

--timeout=400 \

--env-vars-file=cloud-functions/process-invoices/.env.yaml \

--trigger-resource=gs://${PROJECT_ID}-input-invoices \

--trigger-event=google.storage.object.finalize

Hinweis: Wenn der Befehl mit einem Berechtigungsfehler fehlschlägt, warten Sie eine Minute und versuchen Sie es noch einmal.

Cloud Run-Funktion zum Abrufen von Geocodedaten aus einer Adresse erstellen

Erstellen Sie die Cloud Run-Funktion, die Adressdaten aus einer Pub/Sub-Nachricht akzeptiert und die Geocoding API verwendet, um die Adresse genau zu lokalisieren.

- Erstellen Sie die Cloud Run-Geocoding-Funktion:

cd ~/documentai-pipeline-demo/scripts

gcloud functions deploy geocode-addresses \

--no-gen2 \

--region=${CLOUD_FUNCTION_LOCATION} \

--entry-point=process_address \

--runtime=python39 \

--source=cloud-functions/geocode-addresses \

--timeout=60 \

--env-vars-file=cloud-functions/geocode-addresses/.env.yaml \

--trigger-topic=${GEO_CODE_REQUEST_PUBSUB_TOPIC}

Aufgabe 6: Umgebungsvariablen für Cloud Run-Funktionen bearbeiten

In dieser Aufgabe schließen Sie die Konfiguration der Cloud Run-Funktionen ab, indem Sie die Umgebungsvariablen für jede Funktion so bearbeiten, dass sie die lab-spezifischen Parameter über die Cloud Console widerspiegeln.

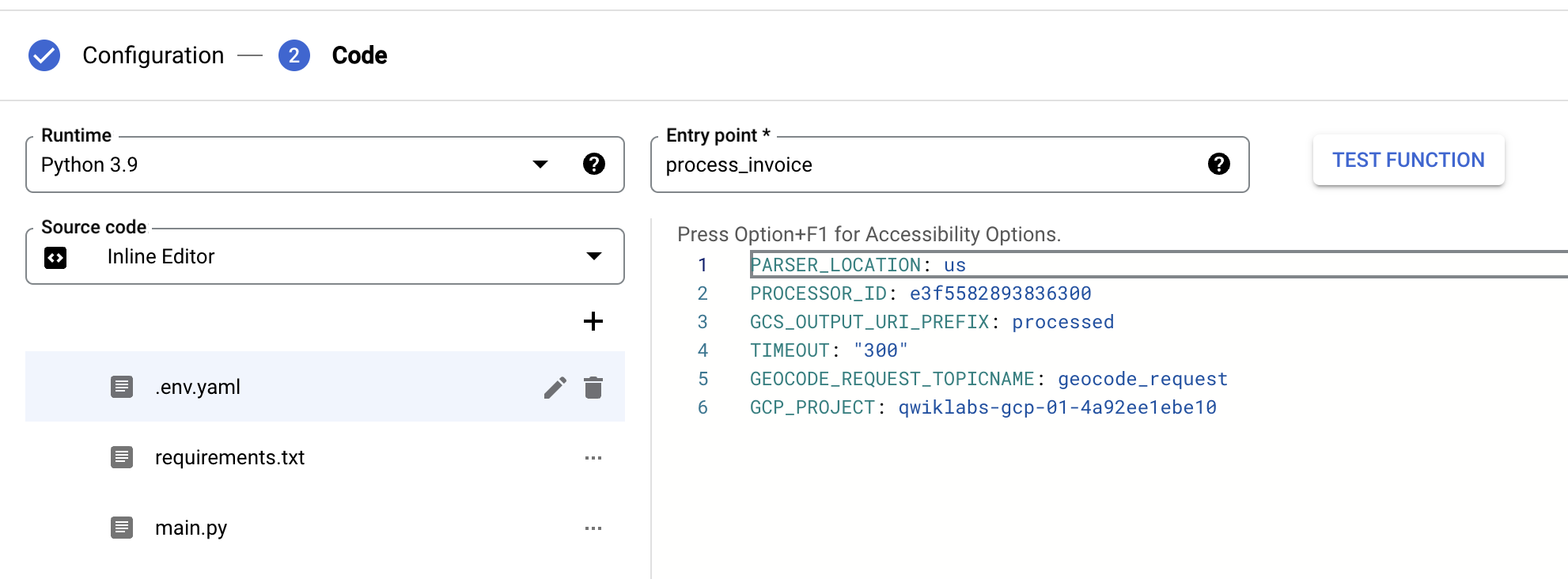

Umgebungsvariablen für die Cloud Run-Funktion „process-invoices“ bearbeiten

Legen Sie die Umgebungsvariablen für die Cloud Run-Funktion process-invoices fest.

- Geben Sie in der Cloud Console in der Suchleiste

Cloud Run functions ein und klicken Sie auf das Ergebnis der Produktseite.

Sie werden zur Cloud Run-Konsole weitergeleitet. Klicken Sie auf Zu Funktionen von Cloud Run Functions (1. Generation), um die bereitgestellten Funktionen process-invoices und geocode-addresses aufzurufen.

Hinweis: Wenn Sie den Link Zu Funktionen von Cloud Run Functions (1. Generation) nicht sehen, aktualisieren Sie die Cloud Run-Konsole.

- Klicken Sie auf die Cloud Run-Funktion process-invoices, um die Verwaltungsseite zu öffnen.

- Klicken Sie auf Bearbeiten.

- Klicken Sie auf Laufzeit, Build, Verbindungen und Sicherheitseinstellungen, um den Bereich zu maximieren.

- Fügen Sie unter Laufzeitumgebungsvariablen die Variable GCP_PROJECT und den Wert entsprechend Ihrer Projekt-ID hinzu.

- Aktualisieren Sie unter Laufzeitumgebungsvariablen den Wert von PROCESSOR_ID, sodass er mit der ID des zuvor erstellten Rechnungsprozessors übereinstimmt.

- Aktualisieren Sie unter Laufzeitumgebungsvariablen den Wert von PARSER_LOCATION, sodass er mit der Region des zuvor erstellten Rechnungsprozessors übereinstimmt. Das kann

us oder eu sein. Dieser Parameter muss in Kleinbuchstaben geschrieben werden.

- Klicken Sie auf Weiter, wählen Sie .env.yaml aus und aktualisieren Sie die Werte für

PROCESSOR_ID, PARSER_LOCATION und GCP_PROJECT für Ihren Rechnungsprozessor.

- Klicken Sie auf Bereitstellen.

Cloud Run-Funktion „process-invoices“ bereitstellen

Umgebungsvariablen für die Cloud Run-Funktion „geocode-addresses“ bearbeiten

Legen Sie die Umgebungsvariablen der Cloud Run-Funktion zur Anreicherung der Geocodedaten fest.

- Klicken Sie auf die Cloud Run-Funktion geocode-addresses, um die Verwaltungsseite zu öffnen.

- Klicken Sie auf Bearbeiten.

- Klicken Sie auf Laufzeit, Build, Verbindungen und Sicherheitseinstellungen, um den Bereich zu maximieren.

- Aktualisieren Sie unter Laufzeitumgebungsvariablen den Wert von API_key, sodass er mit dem in Aufgabe 1 erstellten API-Schlüssel übereinstimmt.

- Klicken Sie auf Weiter, wählen Sie .env.yaml aus und aktualisieren Sie den Wert von API_key so, dass er mit dem Wert des API-Schlüssels übereinstimmt, den Sie im vorherigen Schritt festgelegt haben.

- Klicken Sie auf Bereitstellen.

Cloud Run-Funktion „geocode-addresses“ bereitstellen

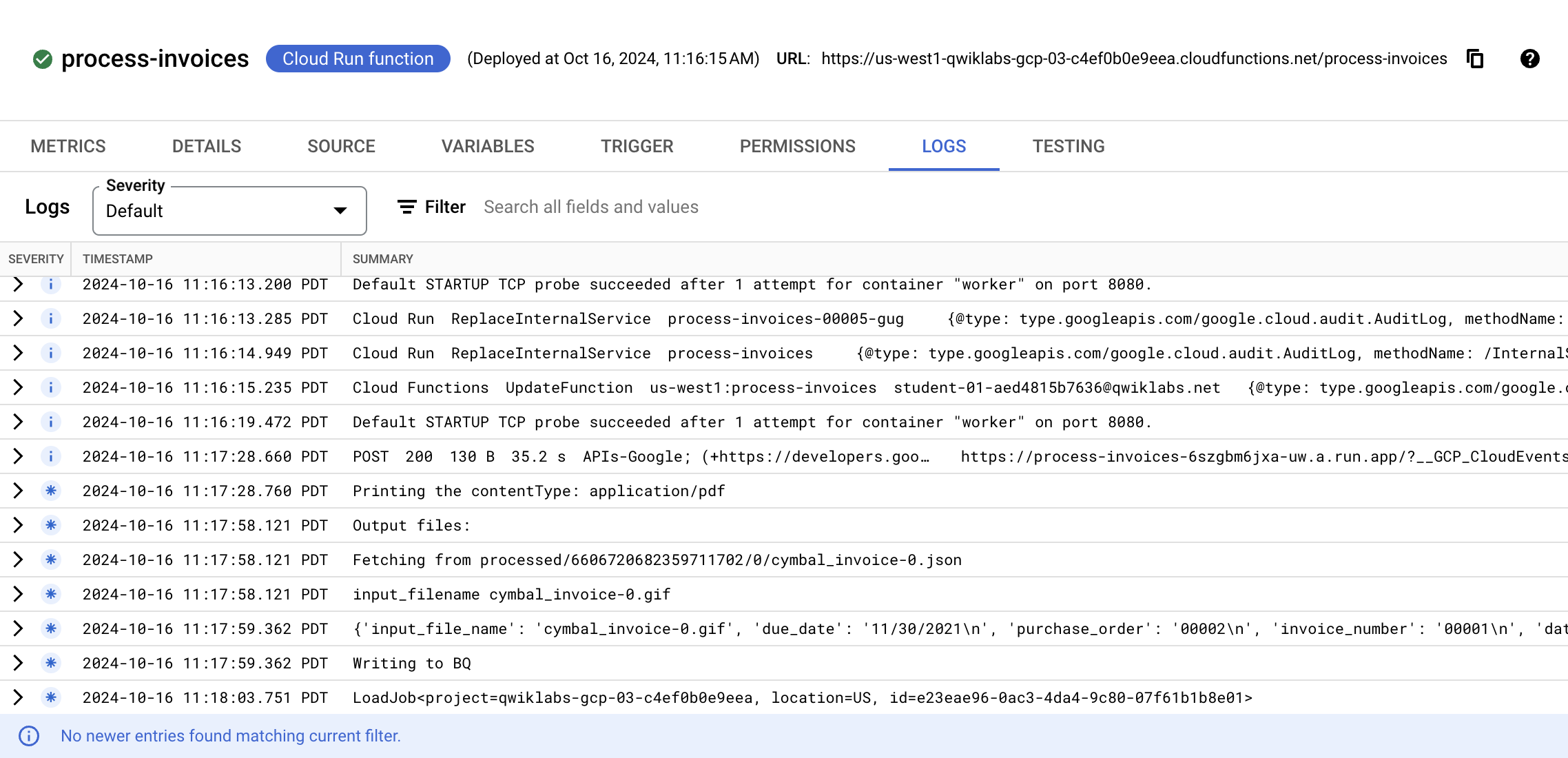

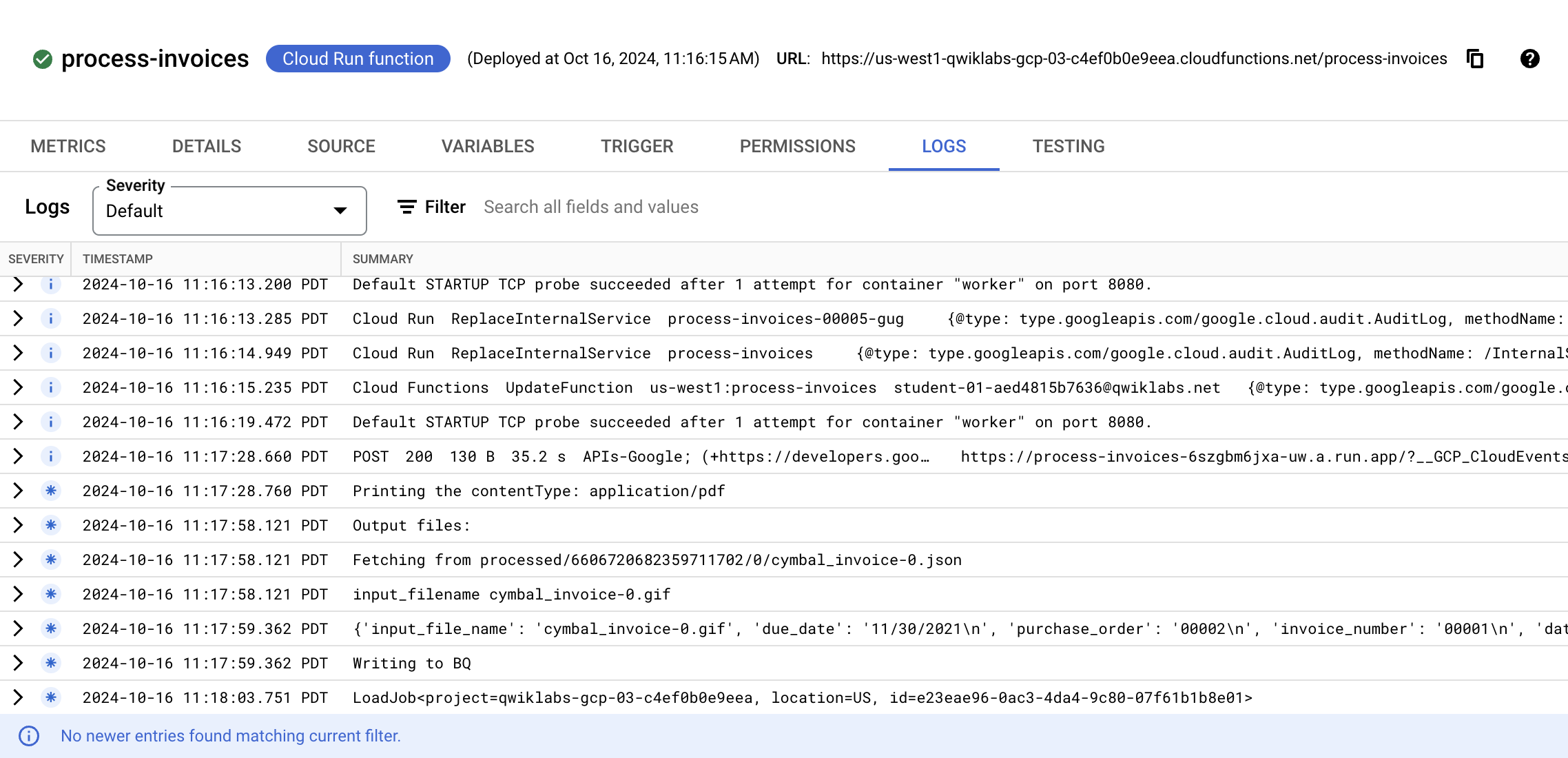

Aufgabe 7: End-to-End-Lösung testen und validieren

Laden Sie Testdaten in Cloud Storage hoch und beobachten Sie den Fortschritt der Pipeline, während die Dokumente verarbeitet und die extrahierten Daten angereichert werden.

- Geben Sie in der Cloud Shell den folgenden Befehl ein, um Beispielformulare in den Cloud Storage-Bucket hochzuladen, der die Cloud Run-Funktion

process-invoices auslöst:

export PROJECT_ID=$(gcloud config get-value core/project)

gsutil cp gs://spls/gsp927/documentai-pipeline-demo/sample-files/* gs://${PROJECT_ID}-input-invoices/

- Geben Sie in der Cloud Console in der Suchleiste

Cloud Run functions ein und klicken Sie auf das Ergebnis der Produktseite.

- Klicken Sie auf die Cloud Run-Funktion process-invoices, um die Verwaltungsseite zu öffnen.

- Klicken Sie auf Logs.

Sie sehen Ereignisse im Zusammenhang mit der Erstellung der Funktion und den vorgenommenen Aktualisierungen zur Konfiguration der Umgebungsvariablen, gefolgt von Ereignissen mit Details zur verarbeiteten Datei und zu den von Document AI erkannten Daten.

Beobachten Sie die Ereignisse, bis Sie ein letztes Ereignis sehen, das anzeigt, dass die Funktionsausführung mit einem LoadJob beendet wurde. Wenn Fehler gemeldet werden, prüfen Sie, ob die im vorherigen Abschnitt in der Datei .env.yaml festgelegten Parameter korrekt sind. Prüfen Sie insbesondere, ob die Prozessor-ID, der Standort und die Projekt-ID gültig sind. Die Liste der Ereignisse wird nicht automatisch aktualisiert.

Nach der Verarbeitung werden Ihre BigQuery-Tabellen mit den von Document AI extrahierten Entitäten sowie mit angereicherten Daten aus der Geocoding API gefüllt, wenn der Document AI-Prozessor im hochgeladenen Dokument Adressdaten erkannt hat.

Die BigQuery Console öffnen

- Klicken Sie in der Google Cloud Console im Navigationsmenü auf BigQuery.

Zuerst wird das Fenster Willkommen bei BigQuery in der Cloud Console geöffnet, das neben allgemeinen Informationen auch einen Link zur Kurzanleitung und zu den Versionshinweisen enthält.

- Klicken Sie auf Fertig.

Die BigQuery Console wird geöffnet.

-

Maximieren Sie im Explorer Ihre Projekt-ID.

-

Maximieren Sie invoice_parser_results.

-

Wählen Sie doc_ai_extracted_entities aus und klicken Sie auf Vorschau.

Sie sehen die vom Rechnungsprozessor aus den Rechnungen extrahierten Formularinformationen. Es ist ersichtlich, dass Adressinformationen und der Lieferantenname erkannt wurden.

- Wählen Sie geocode_details aus und klicken Sie auf Vorschau.

Sie sehen die formatierte Adresse, den Breitengrad und den Längengrad für jede verarbeitete Rechnung, die Adressdaten enthielt, die Document AI extrahieren konnte.

Prüfen, ob die End-to-End-Pipeline Formular- und Adressdaten verarbeitet hat

Glückwunsch!

Sie haben erfolgreich die Document AI API und andere Google Cloud-Dienste verwendet, um eine End-to-End-Pipeline für die Rechnungsverarbeitung zu erstellen. In diesem Lab haben Sie die Document AI API aktiviert, Cloud Run-Funktionen bereitgestellt, die die Document AI API, die BigQuery API, die Cloud Storage API und die Pub/Sub API verwenden, und eine Cloud Run-Funktion so konfiguriert, dass sie ausgelöst wird, wenn Dokumente in Cloud Storage hochgeladen werden. Außerdem haben Sie eine Cloud Run-Funktion konfiguriert, die die Document AI-Clientbibliothek für Python verwendet und ausgelöst wird, wenn eine Pub/Sub-Nachricht erstellt wurde.

Weitere Informationen

- Weitere Informationen zu dieser Form der Authentifizierung finden Sie in der Anleitung.

Google Cloud-Schulungen und -Zertifizierungen

In unseren Schulungen erfahren Sie alles zum optimalen Einsatz unserer Google Cloud-Technologien und können sich entsprechend zertifizieren lassen. Unsere Kurse vermitteln technische Fähigkeiten und Best Practices, damit Sie möglichst schnell mit Google Cloud loslegen und Ihr Wissen fortlaufend erweitern können. Wir bieten On-Demand-, Präsenz- und virtuelle Schulungen für Anfänger wie Fortgeschrittene an, die Sie individuell in Ihrem eigenen Zeitplan absolvieren können. Mit unseren Zertifizierungen weisen Sie nach, dass Sie Experte im Bereich Google Cloud-Technologien sind.

Anleitung zuletzt am 26. August 2025 aktualisiert

Lab zuletzt am 29. Juli 2025 getestet

© 2026 Google LLC. Alle Rechte vorbehalten. Google und das Google-Logo sind Marken von Google LLC. Alle anderen Unternehmens- und Produktnamen können Marken der jeweils mit ihnen verbundenen Unternehmen sein.

.

. ) auf APIs und Dienste > Anmeldedaten.

) auf APIs und Dienste > Anmeldedaten.